Limpar filtro

Artigo

Angelo Bruno Braga · Out. 4, 2022

Olá Comunidade,

Deseja obter ajuda, discutir um recurso interessante, fazer um anúncio ou compartilhar seu conhecimento? Neste post, vamos dizer-lhe como fazer tudo isso.

Para facilitar a navegação neste "como fazer" basta seguir o conteúdo:

Diretrizes Gerais

Pergunta

Artigo ou Anúncio

Discussão

Diretrizes Gerais

Para começar, você precisa clicar no botão "Nova postagem" no menu superior do site da Comunidade de desenvolvedores:

Depois disso, você verá o editor que lhe dará a opção de criar uma Pergunta, um Anúncio, um Artigo ou uma Discussão. Diferentes tipos de postagens têm seus próprios conjuntos de campos obrigatórios e opcionais.

Primeiro, vamos falar sobre os campos comuns para todos os tipos de postagens e, em seguida, passar para os detalhes.

Basicamente, cada post tem um Título*, Corpo*, Grupo*, Tags e algumas opções adicionais onde você pode adicionar uma enquete ou anexar arquivos PDF. Todos os campos de texto marcados com asteriscos (*) são obrigatórios. Então, primeiro, você precisa escolher o tipo de postagem, pode ser como mencionado acima uma Pergunta, um Anúncio, um Artigo ou uma Discussão.

Em seguida, formule a ideia principal da sua pergunta da maneira mais precisa e concisa e escreva-a como um Título.

Depois disso, no Corpo, você escreve o que quiser compartilhar com os outros. Existem duas opções para escolher ao escrever o texto do seu post. Você pode usar o editor WYSIWYG ou Markdown. Ambos vão te dar a mesma coisa como resultado, é claro.

vs.

Depois de terminar de escrever o texto, você deve escolher o Grupo, que geralmente é a tecnologia, produto ou serviço fornecido pela InterSystems.

Após o campo Grupo, há um campo Tags onde você pode adicionar tags relacionadas ao conteúdo do seu post. Existem várias tags, então escolha com responsabilidade, porque outras pessoas usam essas tags para procurar ou classificar as informações quando estão pesquisando algo.

Abaixo das Tags, há um link para ver mais opções. Lá você pode anexar um documento em pdf (por exemplo, o horário do evento em formato pdf) e fornecer o nome que deseja que seja exibido.

Outra coisa que você pode fazer através de mais opções é Adicionar uma enquete. Preencha os campos com uma pergunta, possíveis respostas, escolha a duração, etc.

Depois de terminar, você pode Visualizar sua postagem para ver como ela ficará para outras pessoas, Salvá-la para continuar editando mais tarde ou Publicá-la imediatamente.

Além disso, você pode agendar uma publicação do seu post. Basta clicar na seta para baixo, escolher Agendar postagem e definir a data e a hora.

Depois de tudo definido, basta clicar em Agendar postagem e pronto.

Basicamente, isso é para a funcionalidade comum de criar uma postagem.

Pergunta

Pelo nome, é óbvio que você deve escolher esse tipo de postagem se precisar da ajuda de alguém. Aqui, na Comunidade de desenvolvedores, há muitos especialistas e alguém já deve ter se deparado com a mesma situação. Então não hesite em fazer perguntas ou respondê-las ;)

Para pedir ajuda, por favor, formule a ideia principal da sua pergunta e escreva-a como um título. Em seguida, selecione a Versão do produto que você está usando, pois versões diferentes têm funcionalidades e classes diferentes e alguns conselhos podem ser úteis para algumas versões e inúteis para outras.

Para ser ainda mais preciso, você pode fornecer a compilação completa que está usando atualmente utilizando o comando $ZV no terminal. Para obter sua versão completa, você pode abrir o Terminal e executar o comando:

write $ZV

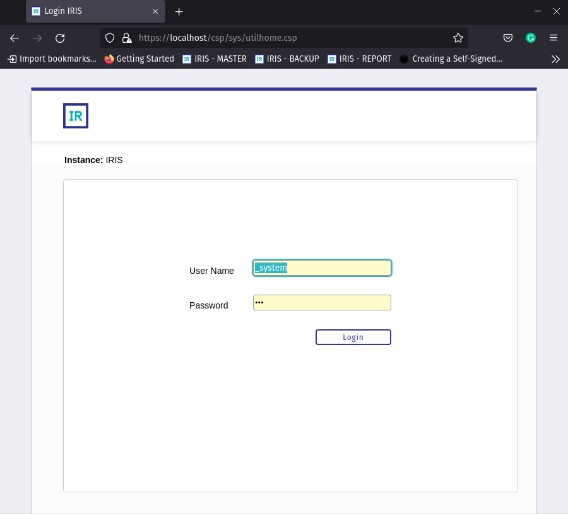

O mesmo pode ser feito no IDE que você está usando ou pode ser vista no Portal de Gerenciamento:

Os demais campos são os mesmos descritos anteriormente.

Artigo or Anúncio

Para compartilhar seu conhecimento ou fazer um anúncio você deve escolher um tipo de postagem de Artigo ou Anúncio respectivamente. Esses tipos de postagens, além dos campos comuns, também possuem alguns adicionais. Esses são o Post Anterior, o Próximo Post e o link do aplicativo Open Exchange.

Então, basicamente, se este artigo/anúncio atual (ou um ramo de uma discussão) estiver vinculado a outro, você pode adicionar o link no campo Postagem anterior e, como resultado, outros membros da comunidade verão as seguintes postagens relacionadas bloquear no final do post.

Você não precisa abrir a postagem anterior e adicionar o link para uma próxima postagem, isso será feito automaticamente.

Se sua postagem tiver um projeto no Open Exchange vinculado a ela, você poderá adicionar o link a este projeto em um campo respectivo.

Discussão

Para iniciar uma conversa sobre algum recurso ou outro ou talvez compartilhar sua experiência com o uso da tecnologia e pedir feedback, você pode iniciar uma Discussão. Esse tipo de postagem tem todos os campos comuns e também os links para Post anterior e Próximo post.

É isso

Isto é o que você precisa saber para iniciar um novo tópico na Comunidade. Boa sorte

E estamos ansiosos para ler seus pensamentos ;

Artigo

Heloisa Paiva · Maio 12

Ao trabalhar com InterSystems IRIS, desenvolvedores e arquitetos de banco de dados frequentemente enfrentam uma decisão crítica: usar Dynamic SQL ou Embedded SQL para consultar e atualizar dados. Ambos os métodos têm seus pontos fortes e casos de uso únicos, mas entender suas implicações de desempenho é essencial para fazer a escolha certa. O tempo de resposta, uma métrica chave na avaliação do desempenho de aplicações, pode variar significativamente dependendo da abordagem SQL utilizada. Dynamic SQL oferece flexibilidade, pois as consultas podem ser construídas e executadas em tempo de execução, tornando-o ideal para cenários com necessidades de consulta imprevisíveis ou altamente variáveis. Por outro lado, Embedded SQL enfatiza a estabilidade e a eficiência ao integrar código SQL diretamente na lógica da aplicação, oferecendo tempos de resposta otimizados para padrões de consulta predefinidos.

Neste artigo, explorarei os tempos de resposta ao usar esses dois tipos de SQL e como eles dependem de diferentes estruturas de classe e do uso de parâmetros. Para fazer isso, usarei as seguintes classes do diagrama:

Para testar os tempos, criei o seguinte número de objetos para cada classe:

Paciente - 50 milhões

Visita - 150 milhões

Médico - 500 mil

Endereço - 50 milhões

Dessa forma, esperava ver um tempo razoável para executar as consultas e observar as diferenças entre a execução de Embedded SQL e Dynamic SQL. O único índice que adicionei foi o índice automático de um-para-muitos para o relacionamento Médico-Visita.

Então, vamos dar uma olhada nas consultas que vou executar e, em seguida, na duração da execução:

select count(*) from Hospital.Address

select count(*) from Hospital.Address where State = :param

select count(*) from Hospital.Patient p left join Hospital.Address a on p.address = a.id

select count(*) from Hospital.Patient p left join Hospital.Address a on p.address = a.id where a.State = :param

select count(a.Address->State) from Hospital.Patient a

select count(*) from Hospital.Patient p where p.Address->State = :param

select count(p.Visit->VisitDate) from Hospital.Patient p

select count(*) from Hospital.Patient p where p.Visit->VisitDate > :param

select count(v.Patient->Name) from Hospital.Visit v

select count(*) from Hospital.Visit v where v.Patient->Name %startswith :param

select count(v.Patient->Address->State) from Hospital.Visit v

select count(*) from Hospital.Visit v where v.Patient->Address->State = :param

select count(v.Doctor->Name) from Hospital.Visit v

select count(*) from Hospital.Visit v where v.Doctor->Name %startswith :param

select count(*) into :p from Hospital.Visit v where v.Doctor->Name %startswith :param and v.Patient->Name %startswith :param

select count(*) into :p from Hospital.Visit v where v.Doctor->Name %startswith :param and v.Patient->Name %startswith :param and v.Patient->Address->State = :param1

Obviamente, o código acima é a sintaxe para Embedded SQL (porque há parâmetros nomeados). Para Dynamic SQL, as consultas são quase as mesmas, mas em vez de parâmetros nomeados, tenho parâmetros não nomeados 😉. Por exemplo, para a última, tenho a seguinte consulta:

select count(*) from Hospital.Visit v where v.Doctor->Name %startswith ? and v.Patient->Name %startswith ? and v.Patient->Address->State = ?

Agora, vamos dar uma olhada nos resultados:

No of query

Embedded SQL (sec)

Dynamic SQL (sec)

1

49

12

2

3

3

3

32

26

4

47

46

5

48

46

6

47

46

7

1767

1806

8

1768

1841

9

31

26

10

83

81

11

41

45

12

73

71

13

23

26

14

1

1

15

2

2

16

3

3

Podemos observar um valor discrepante colossal, que é a primeira consulta. O Embedded SQL levou muito mais tempo para executar do que o Dynamic SQL. Executar as mesmas consultas várias vezes me deu resultados mais ou menos iguais. Então, é o que é.

Em geral, podemos ver que o relacionamento pai-filho é muito mais lento do lado da propriedade dos filhos, mesmo que todos os dados de Paciente e Visita estejam armazenados no global de Paciente. O índice salvou o dia para o relacionamento de um-para-muitos, e o tempo de execução foi consideravelmente menor. No geral, o tempo de resposta é quase sempre similar e difere em menos de 10%; às vezes, é o mesmo. Claro, usei consultas simples que não demoraram muito para preparar, então essa etapa pôde ser quase ignorada.

Artigo

Danusa Calixto · jan 11, 2023

Como você deve se lembrar do Global Summit 2022 ou do 2022.2 launch webinar, estamos lançando um novo e empolgante recurso para incluir em suas soluções analíticas no InterSystems IRIS. O Armazenamento Colunar apresenta uma maneira alternativa de armazenar os dados da tabela SQL que oferece uma aceleração de ordem de grandeza para consultas analíticas. Lançado pela primeira vez como um recurso experimental em 2022.2, o mais recente Developer Preview 2022.3 inclui várias atualizações que achamos que valeriam uma postagem rápida aqui.

Uma rápida recapitulação

Se você não está familiarizado com o Armazenamento Colunar, por favor dê uma olhada neste vídeo de breve introdução ou na sessão do GS2022 sobre o assunto. Resumindo, estamos codificando os dados da tabela em blocos de 64 mil valores por coluna usando um novo tipo de dado $vector. $vector é um tipo de dados interno (por enquanto) que utiliza esquemas de codificação adaptáveis para permitir o armazenamento eficiente de dados esparsos e densos. A codificação também é otimizada para um monte de operações $vector dedicadas, como para calcular agregados, agrupamentos e filtros de partes inteiras de 64k valores por vez, aproveitando instruções SIMD onde possível.

No momento da consulta SQL, aproveitamos essas operações criando um plano de consulta que também opera nesses blocos, o que, como você pode imaginar, gera uma redução massiva na quantidade de IO e no número de instruções ObjectScript para executar sua consulta, em comparação com o clássico processamento linha a linha. É claro que os IOs individuais são maiores e as operações $vector são um pouco mais pesadas do que as contrapartes de valor único do mundo orientado a linha, mas os ganhos são enormes. Usamos o termo planos de consulta vetorizados para estratégias de execução que lidam com dados $vector, empurrando blocos inteiros por meio de uma cadeia de operações individuais rápidas.

Apenas mais rápido

Mais importante ainda, as coisas ficaram mais rápidas. O novo kit inclui várias alterações na pilha que melhoram o desempenho, desde otimizações até aquelas operações $vector de baixo nível sobre alguns aprimoramentos de processamento de consulta e um conjunto mais amplo de planos de consulta vetorizados que podem ser paralelizados. Certas formas de carregar dados, como por meio de instruções INSERT .. SELECT, agora também empregarão um modelo de buffer que já usamos para criar índices e agora permitem a construção de tabelas inteiras com alto desempenho.

JOINs vetorizados

O recurso mais empolgante que adicionamos nesta versão é o suporte para unir dados colunares de maneira vetorizada. Em 2022.2, quando você deseja combinar dados de duas tabelas em uma consulta, ainda recorremos a uma estratégia robusta de JOIN linha por linha que funciona tanto em dados organizados em colunas quanto em linhas. Agora, quando ambas as extremidades do JOIN são armazenadas em formato colunar, usamos uma nova API do kernel para JOIN na memória, mantendo seu formato $vector. Este é outro passo importante para planos de consulta totalmente vetorizados, mesmo para as consultas mais complexas.

Aqui está um exemplo de uma consulta que aproveita a nova função, fazendo um self-JOIN do conjunto de dados New York Taxi que usamos em demonstrações anteriores:

SELECT

COUNT(*),

MAX(r1.total_amount - r2.total_amount)

FROM

NYTaxi.Rides r1,

NYTaxi.Rides r2

WHERE

r1.DOLocationID = r2.PULocationID

AND r1.tpep_dropoff_datetime = r2.tpep_pickup_datetime

AND r2.DOLocationID = r1.PULocationID

AND r1.passenger_count > 2

AND r2.passenger_count > 2

Esta consulta procura pares de viagens com mais de 2 passageiros, onde a segunda viagem começou onde a primeira terminou, exatamente ao mesmo tempo e onde a segunda viagem levou um de volta para onde a primeira começou. Não é uma análise superútil, mas eu só tinha uma tabela real neste esquema e a chave JOIN composta tornou isso um pouco menos trivial. No plano de consulta dessa instrução, você verá trechos como Apply vector operation %VHASH (para construir a chave JOIN composta) e Read vector-join temp-file A, que indicam nosso novo marceneiro vetorizado em ação! Isso pode soar como uma pepita pequena e trivial em um plano de consulta longo, mas envolve muita engenharia inteligente internamente, e há alguns fornecedores de bancos de dados colunares de alto nível por aí que simplesmente não permitem nenhum dos isso e coloque severas restrições em seu layout de esquema, então, por favor, JUNTE-SE a nós para aproveitar isso! :-)

Quando o plano de consulta lê esse arquivo temporário, você pode perceber que ainda há algum processamento linha por linha no trabalho pós-junção, o que nos leva a...

O que vem a seguir?

O Armazenamento Colunar ainda está marcado como "experimental" em 2022.3, mas estamos nos aproximando da prontidão de produção e da vetorização completa de ponta a ponta para consultas de várias tabelas. Isso inclui o trabalho pós-junção mencionado acima, suporte mais amplo no otimizador de consulta, carregamento ainda mais rápido de tabelas colunares e aprimoramentos adicionais no joiner, como suporte a memória compartilhada. Resumindo: agora é um ótimo momento para dar uma primeira chance a tudo isso com o conjunto de dados de taxi de Nova York (agora em IPM ou com script docker) usando o 2022.3 Community Edition, então você só precisa pressionar "Executar" quando lançarmos o 2023.1!

Se você estiver interessado em obter conselhos mais personalizados sobre como aproveitar o armazenamento colunar com seus próprios dados e consultas, entre em contato comigo ou com sua equipe de contas diretamente e talvez nos encontremos no Global Summit 2023 ;-).

Artigo

Danusa Calixto · Mar. 26

A interface de usuário de interoperabilidade agora inclui experiências de usuário modernizadas para os aplicativos Editor DTL e Configuração da Produção que estão disponíveis para aceitação em todos os produtos de interoperabilidade. Você pode alternar entre as visualizações modernizada e padrão. Todas as outras telas de interoperabilidade permanecem na interface de usuário padrão. Observe que as alterações são limitadas a esses dois aplicativos e identificamos abaixo a funcionalidade que está disponível atualmente.

Para experimentar as novas telas antes de atualizar, você pode baixar a versão 2025.1 da nossa página do kit da comunidade aqui: https://evaluation.intersystems.com/Eval/. Revise este breve tutorial sobre os aprimoramentos feitos nessas telas assistindo ao Building Integrations: A New User Experience do Learning Service!

Configuração da Produção - Introdução às Tarefas de Configuração

Configuração da Produção: Suportado nesta versão da Configuração de Produção:

Criando/Editando/Copiando/Excluindo Hosts

Parar/Iniciar Hosts

Editar Configurações da Produção

Parar/Iniciar Produções

Integração de controle de origem: Suporte para integração de controle de origem para a funcionalidade de configuração acima está disponível.

Visualização de Painel Dividido: Os usuários podem abrir o Editor de Regras e o Editor DTL diretamente na tela Configuração de Produção para visualizar e editar regras e transformações incluídas na produção em uma exibição de painel dividido.

Filtros Aprimorados: uma caixa de pesquisa na parte superior permite que você pesquise e filtre em todos os componentes de negócios, incluindo várias categorias, DTLs e subtransformações. Use a barra lateral esquerda para pesquisar independentemente do painel principal para visualizar os resultados da pesquisa em hosts e categorias.

Edição em massa de Categorias de Hosts: você pode adicionar uma nova categoria ou editar uma categoria existente para uma produção adicionando hosts da configuração de produção.

Roteadores expansíveis: Os roteadores podem ser expandidos para visualizar todas as regras, transformações e conexões em linha.

Conexões de Host Retrabalhadas: conexões diretas e indiretas agora são renderizadas quando um host comercial é selecionado, permitindo que você veja o caminho completo que uma mensagem pode tomar. Passe o mouse sobre qualquer host de saída ou entrada para diferenciar ainda mais as conexões. Mostrar Somente Hosts Conectados filtrará apenas os hosts selecionados e suas conexões.

Editor DTL - Introdução às Ferramentas DTL

Integração a Controle de Fontes: suporte para integração de controle de fonte está disponível.

Integração com VS Code: Os usuários podem visualizar esta versão do Editor DTL no VS Code IDE.

Suporte a Python embutido: O suporte ao Python Embutido se estende a esta versão do Editor DTL.

Teste DTL : O utilitário de Teste de DTL está disponível nesta versão do Editor DTL.

Trocar o Layout do Painel: O editor DTL suporta um layout lado a lado e de cima para baixo. Clique no botão de layout na faixa superior para experimentar isso.

Desfazer/Refazer: Os usuários podem desfazer e refazer todas as ações com os botões desfazer/refazer que ainda não foram salvos no código.

Parâmetro Gerar Segmentos Vazios: o parâmetro GENERATEEMPTYSEGMENTS está disponível para gerar segmentos vazios para campos ausentes.

Visualização de Subtransformações: Os usuários podem visualizar as subtransformações clicando no ícone de olho para abrir o DTL da subtransformação em uma nova guia.

Rolagem:

Rolagem Independente: As seções esquerda e direita (origem e destino) do DTL podem ser roladas independentemente posicionando o cursor acima de uma das seções e usando a roda de rolagem ou o trackpad para mover os segmentos verticalmente.

Rolagem Conjunta: as seções de origem e de destino podem ser roladas conjuntamente colocando o cursor no meio do diagrama.

Preenchimento Automático de Campo: Preenchimento automático disponível para: campos 'origem', 'destino' e 'condição', bem como na Classe de origem, Tipo de documento de origem, Classe de destino, Tipo de documento de destino.

Numeração Ordinal: O editor visual permite que você ative ou desative a visualização dos números ordinais e da expressão de caminho completo para cada segmento.

Referências Fáceis: Quando um campo no Editor de Ações está em foco, clicar duas vezes em um segmento no Editor Gráfico insere a referência de segmento correspondente na posição atual do cursor no Editor de Ações.

Sincronização: Clique em um elemento no editor visual para destacar a linha correspondente no editor de ações.

📣 CHAMADA PARA AÇÃO 📣

Se você tiver algum feedback, envie-o das seguintes formas:

✨ NOVOS Recursos em toda a interoperabilidade: Insira uma ideia no portal de ideias ou envolva-se com outras ideias no Portal de Ideias da InterSystems. Para novas ideias, adicione a tag "Interoperabilidade" em sua postagem ou vote positivamente em recursos já propostos na lista!

💻 Feedback Geral da Experiência do Usuário em todas as soluções de interoperabilidade: Por favor, comente seu feedback ou interaja com outros comentários abaixo.

🗒 Sugestões/Feedback sobre aplicativos modernizados (conforme descrito acima): Comente seu feedback ou interaja com outros comentários abaixo.

Por favor, considere completar a oportunidade do Global Master para se envolver com a equipe em uma sessão de feedback guiada privada e ganhar pontos! Inscreva-se para essas sessões via Global Masters >> aqui.

Se você quiser fornecer algum feedback adicional em um formato privado, envie seus pensamentos ou perguntas por e-mail para: ux@intersystems.com

Artigo

Heloisa Paiva · Abr. 3

No artigo anterior, apresentamos o aplicativo d[IA]gnosis, desenvolvido para auxiliar na codificação de diagnósticos na CID-10. Neste artigo, veremos como o InterSystems IRIS for Health nos fornece as ferramentas necessárias para a geração de vetores a partir da lista de códigos da CID-10, usando um modelo de linguagem pré-treinado, seu armazenamento e a subsequente busca por similaridades em todos esses vetores gerados.

Introdução

Uma das principais características que surgiram com o desenvolvimento de modelos de IA é o que conhecemos como RAG (Geração Aumentada por Recuperação), que nos permite melhorar os resultados dos modelos LLM ao incorporar um contexto ao modelo. Bem, em nosso exemplo, o contexto é dado pelo conjunto de diagnósticos da CID-10 e, para usá-los, devemos primeiro vetorizá-los.

Como vetorizar nossa lista de diagnósticos?

SentenceTransformers e Embedded Python

Para a geração de vetores, utilizamos a biblioteca Python SentenceTransformers , que facilita muito a vetorização de textos livres a partir de modelos pré-treinados. Do próprio site deles:

Sentence Transformers (também conhecido como SBERT) é o módulo Python de referência para acessar, usar e treinar modelos de incorporação de texto e imagem de última geração. Pode ser usado para calcular incorporações usando modelos Sentence Transformer (início rápido) ou para calcular pontuações de similaridade usando modelos Cross-Encoder (início rápido). Isso desbloqueia uma ampla gama de aplicações, incluindo busca semântica, similaridade textual semântica, e mineração de paráfrases.

Dentre todos os modelos desenvolvidos pela comunidade SentenceTransformers, encontramos o BioLORD-2023-M, um modelo pré-treinado que gerará vetores de 786 dimensões.

Este modelo foi treinado usando o BioLORD, uma nova estratégia de pré-treinamento para produzir representações significativas para frases clínicas e conceitos biomédicos.

As metodologias de ponta operam maximizando a similaridade na representação de nomes que se referem ao mesmo conceito e evitando o colapso por meio do aprendizado contrastivo. No entanto, como os nomes biomédicos nem sempre são autoexplicativos, às vezes resulta em representações não semânticas.

O BioLORD supera esse problema fundamentando suas representações de conceitos usando definições, bem como descrições curtas derivadas de um grafo de conhecimento multirrelacional que consiste em ontologias biomédicas. Graças a essa fundamentação, nosso modelo produz representações de conceitos mais semânticas que correspondem mais de perto à estrutura hierárquica das ontologias. O BioLORD-2023 estabelece um novo estado da arte para similaridade de texto tanto em frases clínicas (MedSTS) quanto em conceitos biomédicos (EHR-Rel-B).

Como você pode ver em sua definição, este modelo é pré-treinado com conceitos médicos que serão úteis ao vetorizar tanto nossos códigos CID-10 quanto texto livre.

Para o nosso projeto, baixaremos este modelo para acelerar a criação de vetores:

if not os.path.isdir('/shared/model/'):

model = sentence_transformers.SentenceTransformer('FremyCompany/BioLORD-2023-M')

model.save('/shared/model/')

Uma vez em nossa equipe, podemos inserir os textos a serem vetorizados em listas para acelerar o processo. Vamos ver como vetorizamos os códigos CID-10 que registramos anteriormente em nossa classe ENCODER.Object.Codes.

st = iris.sql.prepare("SELECT TOP 50 CodeId, Description FROM ENCODER_Object.Codes WHERE VectorDescription is null ORDER BY ID ASC ")

resultSet = st.execute()

df = resultSet.dataframe()

if (df.size > 0):

model = sentence_transformers.SentenceTransformer("/shared/model/")

embeddings = model.encode(df['description'].tolist(), normalize_embeddings=True)

df['vectordescription'] = embeddings.tolist()

stmt = iris.sql.prepare("UPDATE ENCODER_Object.Codes SET VectorDescription = TO_VECTOR(?,DECIMAL) WHERE CodeId = ?")

for index, row in df.iterrows():

rs = stmt.execute(str(row['vectordescription']), row['codeid'])

else:

flagLoop = False

Como você pode ver, primeiro extraímos os códigos armazenados em nossa tabela de códigos CID-10 que ainda não vetorizamos, mas que registramos em uma etapa anterior após extraí-los do arquivo CSV, depois extraímos a lista de descrições a serem vetorizadas e, usando a biblioteca Python sentence_transformers, recuperaremos nosso modelo e geraremos os embeddings associados.

Finalmente, atualizaremos o código CID-10 com a descrição vetorizada executando o UPDATE. Como você pode ver, o comando para vetorizar o resultado retornado pelo modelo é o comando SQL TO_VECTOR no IRIS.

Usando-o no IRIS

Ok, temos nosso código Python, então só precisamos envolvê-lo em uma classe que estende Ens.BusinessProcess e incluí-la em nossa produção, depois conectá-la ao Business Service encarregado de recuperar o arquivo CSV e pronto!

Vamos dar uma olhada em como esse código ficará em nossa produção:

Como você pode ver, temos nosso Business Service com o adaptador EnsLib.File.InboundAdapter, que nos permitirá coletar o arquivo de códigos e redirecioná-lo para nosso Business Process, no qual realizaremos todas as operações de vetorização e armazenamento, fornecendo-nos um conjunto de registros como o seguinte

Agora nosso aplicativo estaria pronto para começar a procurar possíveis correspondências com os textos que enviamos a ele!

No próximo artigo...

No próximo artigo, mostraremos como o front-end do aplicativo desenvolvido em Angular 17 é integrado à nossa produção no IRIS for Health e como o IRIS recebe os textos a serem analisados, os vetoriza e busca similaridades na tabela de códigos CID-10.

Não perca!

Artigo

Mikhail Khomenko · Nov. 19, 2021

[Da última vez](https://community.intersystems.com/post/deploying-intersystems-iris-solution-gcp-kubernetes-cluster-gke-using-circleci), lançamos uma aplicação IRIS no Google Cloud usando seu serviço GKE.

E, embora criar um cluster manualmente (ou por meio do [gcloud](https://cloud.google.com/kubernetes-engine/docs/how-to/creating-a-cluster)) seja fácil, a [abordagem de Infraestrutura como Código (IaC)](https://martinfowler.com/bliki/InfrastructureAsCode.html) moderna recomenda que a descrição do cluster Kubernetes também seja armazenada no repositório como código. Como escrever este código é determinado pela ferramenta que é usada para IaC.

No caso do Google Cloud, existem várias opções, entre elas o Deployment Manager e o Terraform. As opiniões estão divididas quanto o que é melhor: se você quiser saber mais, leia este tópico no Reddit Opiniões sobre Terraform vs. Deployment Manager? e o artigo no Medium Comparando o GCP Deployment Manager e o Terraform.

Para este artigo, escolheremos o Terraform, já que ele está menos vinculado a um fornecedor específico e você pode usar seu IaC com diferentes provedores em nuvem.

Suporemos que você leu o artigo anterior e já tem uma conta do Google, e que criou um projeto chamado “Desenvolvimento”, como no artigo anterior. Neste artigo, seu ID é mostrado como . Nos exemplos abaixo, altere-o para o ID de seu próprio projeto.

Lembre-se de que o Google não é gratuito, embora tenha um nível gratuito. Certifique-se de controlar suas despesas.

Também presumiremos que você já bifurcou o repositório original. Chamaremos essa bifurcação (fork) de “my-objectscript-rest-docker-template” e nos referiremos ao seu diretório raiz como"" ao longo deste artigo.

Todos os exemplos de código são armazenados neste repositório para simplificar a cópia e a colagem.

O diagrama a seguir descreve todo o processo de implantação em uma imagem:

Então, vamos instalar a versão mais recente do Terraform no momento desta postagem:

$ terraform versionTerraform v0.12.17

A versão é importante aqui, pois muitos exemplos na Internet usam versões anteriores, e a 0.12 trouxe muitas mudanças.

Queremos que o Terraform execute certas ações (use certas APIs) em nossa conta do GCP. Para ativar isso, crie uma conta de serviço com o nome 'terraform' e ative a API do Kubernetes Engine. Não se preocupe sobre como vamos conseguir isso — basta continuar lendo e suas perguntas serão respondidas.

Vamos tentar um exemplo com o utilitário gcloud, embora também possamos usar o console web.

Usaremos alguns comandos diferentes nos exemplos a seguir. Consulte os tópicos da documentação a seguir para obter mais detalhes sobre esses comandos e recursos.

Como criar contas de serviço IAM no gcloud

Como atribuir papéis a uma conta de serviço para recursos específicos

Como criar chaves de conta de serviço IAM no gcloud

Como ativar uma API no projeto do Google Cloud

Agora vamos analisar o exemplo.

$ gcloud init

Como trabalhamos com o gcloud no artigo anterior, não discutiremos todos os detalhes de configuração aqui. Para este exemplo, execute os seguintes comandos:

$ cd $ mkdir terraform; cd terraform$ gcloud iam service-accounts create terraform --description "Terraform" --display-name "terraform"

Agora, vamos adicionar alguns papéis à conta de serviço do terraform além de “Administrador do Kubernetes Engine” (container.admin). Essas funções serão úteis para nós no futuro.

$ gcloud projects add-iam-policy-binding \ --member serviceAccount:terraform@.iam.gserviceaccount.com \ --role roles/container.admin

$ gcloud projects add-iam-policy-binding \ --member serviceAccount:terraform@.iam.gserviceaccount.com \ --role roles/iam.serviceAccountUser

$ gcloud projects add-iam-policy-binding \ --member serviceAccount:terraform@.iam.gserviceaccount.com \ --role roles/compute.viewer

$ gcloud projects add-iam-policy-binding \ --member serviceAccount:terraform@.iam.gserviceaccount.com \ --role roles/storage.admin

$ gcloud iam service-accounts keys create account.json \--iam-account terraform@.iam.gserviceaccount.com

Observe que a última entrada cria o seu arquivo account.json. Certifique-se de manter este arquivo em segredo.

$ gcloud projects list$ gcloud config set project $ gcloud services list --available | grep 'Kubernetes Engine'$ gcloud services enable container.googleapis.com$ gcloud services list --enabled | grep 'Kubernetes Engine'container.googleapis.com Kubernetes Engine API

A seguir, vamos descrever o cluster GKE na linguagem HCL do Terraform. Observe que usamos vários placeholders aqui; substitua-os por seus valores:

Placeholder

Significado

Exemplo

ID do projeto do GCP

possible-symbol-254507

Armazenamento para estado/bloqueio do Terraform - deve ser único

circleci-gke-terraform-demo

Região onde os recursos serão criados

europe-west1

Zona onde os recursos serão criados

europe-west1-b

Nome do cluster GKE

dev-cluster

Nome do pool de nós de trabalho do GKE

dev-cluster-node-pool

Aqui está a configuração HCL para o cluster na prática:

$ cat main.tfterraform { required_version = "~> 0.12" backend "gcs" { bucket = "" prefix = "terraform/state" credentials = "account.json" }}

provider "google" { credentials = file("account.json") project = "" region = ""}

resource "google_container_cluster" "gke-cluster" { name = "" location = "" remove_default_node_pool = true # No cluster regional (localização é região, não zona) # este é um número de nós por zona initial_node_count = 1}

resource "google_container_node_pool" "preemptible_node_pool" { name = "" location = "" cluster = google_container_cluster.gke-cluster.name # No cluster regional (localização é região, não zona) # este é um número de nós por zona node_count = 1

node_config { preemptible = true machine_type = "n1-standard-1" oauth_scopes = [ "storage-ro", "logging-write", "monitoring" ] }}

Para garantir que o código HCL esteja no formato adequado, o Terraform fornece um comando de formatação útil que você pode usar:

$ terraform fmt

O fragmento de código (snippet) mostrado acima indica que os recursos criados serão fornecidos pelo Google e os próprios recursos são google_container_cluster e google_container_node_pool, que designamos como preemptivos para economia de custos. Também optamos por criar nosso próprio pool em vez de usar o padrão.

Vamos nos concentrar brevemente na seguinte configuração:

terraform { required_version = "~> 0.12" backend "gcs" { Bucket = "" Prefix = "terraform/state" credentials = "account.json" }}

O Terraform grava tudo o que é feito no arquivo de status e usa esse arquivo para outro trabalho. Para um compartilhamento conveniente, é melhor armazenar este arquivo em algum lugar remoto. Um lugar típico é um Google Bucket.

Vamos criar este bucket. Use o nome do seu bucket em vez do placeholder . Antes da criação do bucket, vamos verificar se está disponível, pois deve ser único em todo o GCP:

$ gsutil acl get gs://

Boa resposta:

BucketNotFoundException: 404 gs:// bucket does not exist

A resposta ocupado "Busy" significa que você deve escolher outro nome:

AccessDeniedException: 403 does not have storage.buckets.get access to

Também vamos habilitar o controle de versão, como o Terraform recomenda.

$ gsutil mb -l EU gs://

$ gsutil versioning get gs://gs://: Suspended

$ gsutil versioning set on gs://

$ gsutil versioning get gs://gs://: Enabled

O Terraform é modular e precisa adicionar um plugin de provedor do Google para criar algo no GCP. Usamos o seguinte comando para fazer isso:

$ terraform init

Vejamos o que o Terraform fará para criar um cluster do GKE:

$ terraform plan -out dev-cluster.plan

A saída do comando inclui detalhes do plano. Se você não tem objeções, vamos implementar este plano:

$ terraform apply dev-cluster.plan

A propósito, para excluir os recursos criados pelo Terraform, execute este comando a partir do diretório /terraform/:

$ terraform destroy -auto-approve

Vamos deixar o cluster como está por um tempo e seguir em frente. Mas primeiro observe que não queremos colocar tudo no repositório, então vamos adicionar vários arquivos às exceções:

$ cat /.gitignore.DS_Storeterraform/.terraform/terraform/*.planterraform/*.json

Usando Helm

No artigo anterior, armazenamos os manifestos do Kubernetes como arquivos YAML no diretório /k8s/, que enviamos ao cluster usando o comando "kubectl apply".

Desta vez, tentaremos uma abordagem diferente: usando o gerenciador de pacotes Helm do Kubernetes, que foi atualizado recentemente para a versão 3. Use a versão 3 ou posterior porque a versão 2 tinha problemas de segurança do lado do Kubernetes (veja Executando o Helm na produção: melhores práticas de Segurança para mais detalhes). Primeiro, empacotaremos os manifestos Kubernetes de nosso diretório k8s/ em um pacote Helm, que é conhecido como chart. Um chart Helm instalado no Kubernetes é chamado de release. Em uma configuração mínima, um chart consistirá em vários arquivos:

$ mkdir /helm; cd /helm$ tree /helm/helm/├── Chart.yaml├── templates│ ├── deployment.yaml│ ├── _helpers.tpl│ └── service.yaml└── values.yaml

Seu propósito está bem descrito no site oficial. As práticas recomendadas para criar seus próprios charts são descritas no Guia de Melhores Práticas do Chart na documentação do Helm.

Esta é a aparência do conteúdo de nossos arquivos:

$ cat Chart.yamlapiVersion: v2name: iris-restversion: 0.1.0appVersion: 1.0.3description: Helm for ObjectScript-REST-Docker-template applicationsources:- https://github.com/intersystems-community/objectscript-rest-docker-template- https://github.com/intersystems-community/gke-terraform-circleci-objectscript-rest-docker-template

$ cat templates/deployment.yamlapiVersion: apps/v1kind: Deploymentmetadata: name: {{ template "iris-rest.name" . }} labels: app: {{ template "iris-rest.name" . }} chart: {{ template "iris-rest.chart" . }} release: {{ .Release.Name }} heritage: {{ .Release.Service }}spec: replicas: {{ .Values.replicaCount }} strategy: {{- .Values.strategy | nindent 4 }} selector: matchLabels: app: {{ template "iris-rest.name" . }} release: {{ .Release.Name }} template: metadata: labels: app: {{ template "iris-rest.name" . }} release: {{ .Release.Name }} spec: containers: - image: {{ .Values.image.repository }}:{{ .Values.image.tag }} name: {{ template "iris-rest.name" . }} ports: - containerPort: {{ .Values.webPort.value }} name: {{ .Values.webPort.name }}

$ cat templates/service.yaml{{- if .Values.service.enabled }}apiVersion: v1kind: Servicemetadata: name: {{ .Values.service.name }} labels: app: {{ template "iris-rest.name" . }} chart: {{ template "iris-rest.chart" . }} release: {{ .Release.Name }} heritage: {{ .Release.Service }}spec: selector: app: {{ template "iris-rest.name" . }} release: {{ .Release.Name }} ports: {{- range $key, $value := .Values.service.ports }} - name: {{ $key }}{{ toYaml $value | indent 6 }} {{- end }} type: {{ .Values.service.type }} {{- if ne .Values.service.loadBalancerIP "" }} loadBalancerIP: {{ .Values.service.loadBalancerIP }} {{- end }}{{- end }}

$ cat templates/_helpers.tpl{{/* vim: set filetype=mustache: */}}{{/*Expande o nome do chart.*/}}

{{- define "iris-rest.name" -}}{{- default .Chart.Name .Values.nameOverride | trunc 63 | trimSuffix "-" -}}{{- end -}}

{{/*Cria o nome e a versão do chart conforme usado pelo rótulo do chart.*/}}{{- define "iris-rest.chart" -}}{{- printf "%s-%s" .Chart.Name .Chart.Version | replace "+" "_" | trunc 63 | trimSuffix "-" -}}{{- end -}}

$ cat values.yamlnamespaceOverride: iris-rest

replicaCount: 1

strategy: | type: Recreate

image: repository: eu.gcr.io/iris-rest tag: v1

webPort: name: web value: 52773

service: enabled: true name: iris-rest type: LoadBalancer loadBalancerIP: "" ports: web: port: 52773 targetPort: 52773 protocol: TCP

Para criar os charts do Helm, instale o cliente Helm e o utilitário de linha de comando kubectl.

$ helm versionversion.BuildInfo{Version:"v3.0.1", GitCommit:"7c22ef9ce89e0ebeb7125ba2ebf7d421f3e82ffa", GitTreeState:"clean", GoVersion:"go1.13.4"}

Crie um namespace chamado iris. Seria bom se isso fosse criado durante a implantação, mas até agora não é o caso.

Primeiro, adicione credenciais para o cluster criado pelo Terraform ao kube-config:

$ gcloud container clusters get-credentials --zone --project $ kubectl create ns iris

Confirme (sem iniciar uma implantação real) se o Helm criará o seguinte no Kubernetes:

$ cd /helm$ helm upgrade iris-rest \ --install \ . \ --namespace iris \ --debug \ --dry-run

A saída — os manifestos do Kubernetes — foi omitida por causa do espaço aqui. Se tudo estiver certo, vamos implantar:

$ helm upgrade iris-rest --install . --namespace iris$ helm list -n iris --allIris-rest iris 1 2019-12-14 15:24:19.292227564 +0200 EET deployed iris-rest-0.1.0 1.0.3

Vemos que o Helm implantou nossa aplicação, mas como ainda não criamos a imagem Docker eu.gcr.io/iris-rest:v1, o Kubernetes não pode extraí-la (ImagePullBackOff):

$ kubectl -n iris get poNAME READY STATUS RESTARTS AGEiris-rest-59b748c577-6cnrt 0/1 ImagePullBackOff 0 10m

Vamos terminar com isso por agora:

$ helm delete iris-rest -n iris

O Lado do CircleCI

Agora que experimentamos o Terraform e o cliente Helm, vamos colocá-los em uso durante o processo de implantação no lado do CircleCI.

$ cat /.circleci/config.ymlversion: 2.1

orbs: gcp-gcr: circleci/gcp-gcr@0.6.1

jobs: terraform: docker: # A versão da imagem do Terraform deve ser a mesma de quando # você executa o terraform antes da máquina local - image: hashicorp/terraform:0.12.17 steps: - checkout - run: name: Create Service Account key file from environment variable working_directory: terraform command: echo ${TF_SERVICE_ACCOUNT_KEY} > account.json - run: name: Show Terraform version command: terraform version - run: name: Download required Terraform plugins working_directory: terraform command: terraform init - run: name: Validate Terraform configuration working_directory: terraform command: terraform validate - run: name: Create Terraform plan working_directory: terraform command: terraform plan -out /tmp/tf.plan - run: name: Run Terraform plan working_directory: terraform command: terraform apply /tmp/tf.plan k8s_deploy: docker: - image: kiwigrid/gcloud-kubectl-helm:3.0.1-272.0.0-218 steps: - checkout - run: name: Authorize gcloud on GKE working_directory: helm command: | echo ${GCLOUD_SERVICE_KEY} > gcloud-service-key.json gcloud auth activate-service-account --key-file=gcloud-service-key.json gcloud container clusters get-credentials ${GKE_CLUSTER_NAME} --zone ${GOOGLE_COMPUTE_ZONE} --project ${GOOGLE_PROJECT_ID} - run: name: Wait a little until k8s worker nodes up command: sleep 30 # It’s a place for improvement - run: name: Create IRIS namespace if it doesn't exist command: kubectl get ns iris || kubectl create ns iris - run: name: Run Helm release deployment working_directory: helm command: | helm upgrade iris-rest \ --install \ . \ --namespace iris \ --wait \ --timeout 300s \ --atomic \ --set image.repository=eu.gcr.io/${GOOGLE_PROJECT_ID}/iris-rest \ --set image.tag=${CIRCLE_SHA1} - run: name: Check Helm release status command: helm list --all-namespaces --all - run: name: Check Kubernetes resources status command: | kubectl -n iris get pods echo kubectl -n iris get servicesworkflows: main: jobs: - terraform - gcp-gcr/build-and-push-image: dockerfile: Dockerfile gcloud-service-key: GCLOUD_SERVICE_KEY google-compute-zone: GOOGLE_COMPUTE_ZONE google-project-id: GOOGLE_PROJECT_ID registry-url: eu.gcr.io image: iris-rest path: . tag: ${CIRCLE_SHA1} - k8s_deploy: requires: - terraform - gcp-gcr/build-and-push-image

Você precisará adicionar várias variáveis de ambiente ao seu projeto no lado do CircleCI:

O GCLOUD\_SERVICE\_KEY é a chave da conta de serviço CircleCI e o TF\_SERVICE\_ACCOUNT_KEY é a chave da conta de serviço Terraform. Lembre-se de que a chave da conta de serviço é todo o conteúdo do arquivo _account.json_.

A seguir, vamos enviar nossas alterações para um repositório:

$ cd $ git add .circleci/ helm/ terraform/ .gitignore$ git commit -m "Add Terraform and Helm"$ git push

O painel da IU do CircleCI deve mostrar que tudo está bem:

Terraform é uma ferramenta idempotente e se o cluster GKE estiver presente, o trabalho "terraform" não fará nada. Se o cluster não existir, ele será criado antes da implantação do Kubernetes.Por fim, vamos verificar a disponibilidade de IRIS:

$ gcloud container clusters get-credentials --zone --project

$ kubectl -n iris get svcNAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGEIris-rest LoadBalancer 10.23.249.42 34.76.130.11 52773:31603/TCP 53s

$ curl -XPOST -H "Content-Type: application/json" -u _system:SYS 34.76.130.11:52773/person/ -d '{"Name":"John Dou"}'

$ curl -XGET -u _system:SYS 34.76.130.11:52773/person/all[{"Name":"John Dou"},]

Conclusão

Terraform e Helm são ferramentas DevOps padrão e devem ser perfeitamente integrados à implantação do IRIS.

Eles exigem algum aprendizado, mas depois de alguma prática, eles podem realmente economizar seu tempo e esforço.

Artigo

Henry Pereira · Ago. 10, 2021

Calma, calma, não estou incentivando uma guerra contra as máquinas no melhor estilo sci-fi para impedir ao dominação mundial do Ultron ou da Skynet.

Ainda não... ainda não 🤔

Convido você para desafiarmos as máquinas através da criação de um jogo bem simples utilizando ObjectScript com Python embarcado.

Tenho que dizer que fiquei super empolgado com a feature do Embedded Python no InterSystems IRIS, é incrível o leque de possibilidades que se abre para criar aplicações fantásticas.

Vamos construir um jogo da velha, as regras são bem simples e acredito que todos sabem como jogar.

Era o que me salvava do tédio na minha infância durante viagens longas de carro com a família, antes de crianças terem celulares ou tablets, nada como desafiar meus irmãos a jogar algumas partidas no vidro embaçado.

Então apertem o cinto e vamos lá!

## Regras

Como comentado, as regras são muito simples:

- apenas 2 jogadores por partida

- é jogado em turnos em um grid de 3x3

- o jogador humano sempre será a letra X e o computador a letra O

- os jogadores só poderão colocar as letras nos espaços vazios

- o primeiro que completar uma sequência de 3 letras iguais na horizontal, ou na vertical ou na diagonal, é o vencedor

- quando os 9 espaços estiverem ocupados será empate e o fim da partida

Todo o mecanismo e as regras escreveremos em ObjectScript, o mecanismo do jogador do computador será escrito em Python.

## Vamos colocar as mãos na massa

Controlaremos o tabuleiro em uma global, sendo que cada linha estará em um nó e cada coluna em um piece.

Nosso primeiro método é para iniciar o tabuleiro, para facilitar irei iniciar a global já com os nós (linhas A, B e C) e com os 3 pieces:

```

/// Iniciate a New Game

ClassMethod NewGame() As %Status

{

Set sc = $$$OK

Kill ^TicTacToe

Set ^TicTacToe("A") = "^^"

Set ^TicTacToe("B") = "^^"

Set ^TicTacToe("C") = "^^"

Return sc

}

```

neste momento iremos criar o método para adicionar as letras nos espaços vazios, para isto cada jogador irá passar a localização do espaço do tabuleiro.

Cada linha uma letra e coluna um número, para colocar o X no meio, por exemplo, passamos B2 e a letra X para o método.

```

ClassMethod MakeMove(move As %String, player As %String) As %Boolean

{

Set $Piece(^TicTacToe($Extract(move,1,1)),"^",$Extract(move,2,2)) = player

}

```

Vamos validar se a coordenada passada é válida, a maneira mais simples que vejo é utilizando uma expressão regular:

```

ClassMethod CheckMoveIsValid(move As %String) As %Boolean

{

Set regex = ##class(%Regex.Matcher).%New("(A|B|C){1}[0-9]{1}")

Set regex.Text = $ZCONVERT(move,"U")

Return regex.Locate()

}

```

precisamos garantir que o espaço selecionado esteja vazio

```

ClassMethod IsSpaceFree(move As %String) As %Boolean

{

Quit ($Piece(^TicTacToe($Extract(move,1,1)),"^",$Extract(move,2,2)) = "")

}

```

Nooice!

Agora vamos verificar se algum jogador venceu a partida ou se o jogo já terminou, para isto vamos criar o método CheckGameResult.

Primeiro verificamos se teve algum vencedor completando pela horizontal, usaremos uma list com as linhas e um simples $Find resolve

```

Set lines = $ListBuild("A","B","C")

// Check Horizontal

For i = 1:1:3 {

Set line = ^TicTacToe($List(lines, i))

If (($Find(line,"X^X^X")>0)||($Find(line,"O^O^O")>0)) {

Return $Piece(^TicTacToe($List(lines, i)),"^", 1)_" won"

}

}

```

Com outro for verificamos a vertical

```

For j = 1:1:3 {

If (($Piece(^TicTacToe($List(lines, 1)),"^",j)'="") &&

($Piece(^TicTacToe($List(lines, 1)),"^",j)=$Piece(^TicTacToe($List(lines, 2)),"^",j)) &&

($Piece(^TicTacToe($List(lines, 2)),"^",j)=$Piece(^TicTacToe($List(lines, 3)),"^",j))) {

Return $Piece(^TicTacToe($List(lines, 1)),"^",j)_" won"

}

}

```

para verificar a diagonal:

```

If (($Piece(^TicTacToe($List(lines, 2)),"^",2)'="") &&

(

(($Piece(^TicTacToe($List(lines, 1)),"^",1)=$Piece(^TicTacToe($List(lines, 2)),"^",2)) &&

($Piece(^TicTacToe($List(lines, 2)),"^",2)=$Piece(^TicTacToe($List(lines, 3)),"^",3)))||

(($Piece(^TicTacToe($List(lines, 1)),"^",3)=$Piece(^TicTacToe($List(lines, 2)),"^",2)) &&

($Piece(^TicTacToe($List(lines, 2)),"^",2)=$Piece(^TicTacToe($List(lines, 3)),"^",1)))

)) {

Return ..WhoWon($Piece(^TicTacToe($List(lines, 2)),"^",2))

}

```

por último, verificamos se teve um empate

```

Set gameStatus = ""

For i = 1:1:3 {

For j = 1:1:3 {

Set:($Piece(^TicTacToe($List(lines, i)),"^",j)="") gameStatus = "Not Done"

}

}

Set:(gameStatus = "") gameStatus = "Draw"

```

Great!

## É hora de criarmos a máquina!

Vamos criar o nosso adversário, precisamos criar um algoritmo capaz de calcular todos os movimentos disponíveis e usar uma métrica para saber qual é o melhor movimento.

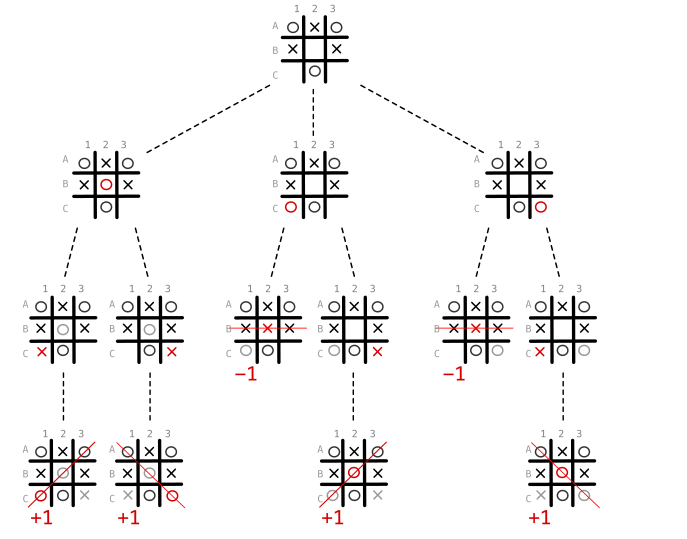

O ideal é utilizar um algoritmo de decisão chamado de MiniMax ([Wikipedia: MiniMax](https://en.wikipedia.org/wiki/Minimax#Minimax_algorithm_with_alternate_moves))

O algoritmo MiniMax é uma regra de decisão utilizado em teoria dos jogos, teoria de decisão e inteligência artificial.

Basicamente, precisamos saber como jogar assumindo quais serão os possíveis movimentos do oponente e pegar o melhor cenário possível.

Em detalhes, pegamos o cenário atual e recursivamente verificamos o resultado do movimento de cada jogador, caso o computador ganhar a partida pontuamos com +1, caso perder então pontuamos como -1 e 0 como um empate.

Caso não for o final do jogo, abrimos outra árvore a partir do estado atual. Feito isto encontramos a jogada com o valor máximo para o computador e a mínima para o adversário.

Veja o diagrama abaixo, existem 3 movimentos disponíveis: B2, C1 e C3.

Escolhendo C1 ou C3, o oponente tem uma chance de ganhar no próximo turno, já escolhendo B2 independente do movimento do adversário ganhamos a partida.

É como ter a joia do tempo em suas mãos para encontrar a melhor linha do tempo.

Convertendo para python

```python

ClassMethod ComputerMove() As %String [ Language = python ]

{

import iris

from math import inf as infinity

computerLetter = "O"

playerLetter = "X"

def isBoardFull(board):

for i in range(0, 8):

if isSpaceFree(board, i):

return False

return True

def makeMove(board, letter, move):

board[move] = letter

def isWinner(brd, let):

# check horizontals

if ((brd[0] == brd[1] == brd[2] == let) or \

(brd[3] == brd[4] == brd[5] == let) or \

(brd[6] == brd[7] == brd[8] == let)):

return True

# check verticals

if ((brd[0] == brd[3] == brd[6] == let) or \

(brd[1] == brd[4] == brd[7] == let) or \

(brd[2] == brd[5] == brd[8] == let)):

return True

# check diagonals

if ((brd[0] == brd[4] == brd[8] == let) or \

(brd[2] == brd[4] == brd[6] == let)):

return True

return False

def isSpaceFree(board, move):

#Retorna true se o espaco solicitado esta livre no quadro

if(board[move] == ''):

return True

else:

return False

def copyGameState(board):

dupeBoard = []

for i in board:

dupeBoard.append(i)

return dupeBoard

def getBestMove(state, player):

done = "Done" if isBoardFull(state) else ""

if done == "Done" and isWinner(state, computerLetter): # If Computer won

return 1

elif done == "Done" and isWinner(state, playerLetter): # If Human won

return -1

elif done == "Done": # Draw condition

return 0

# Minimax Algorithm

moves = []

empty_cells = []

for i in range(0,9):

if state[i] == '':

empty_cells.append(i)

for empty_cell in empty_cells:

move = {}

move['index'] = empty_cell

new_state = copyGameState(state)

makeMove(new_state, player, empty_cell)

if player == computerLetter:

result = getBestMove(new_state, playerLetter)

move['score'] = result

else:

result = getBestMove(new_state, computerLetter)

move['score'] = result

moves.append(move)

# Find best move

best_move = None

if player == computerLetter:

best = -infinity

for move in moves:

if move['score'] > best:

best = move['score']

best_move = move['index']

else:

best = infinity

for move in moves:

if move['score'] < best:

best = move['score']

best_move = move['index']

return best_move

lines = ['A', 'B', 'C']

game = []

current_game_state = iris.gref("^TicTacToe")

for line in lines:

for cell in current_game_state[line].split("^"):

game.append(cell)

cellNumber = getBestMove(game, computerLetter)

next_move = lines[int(cellNumber/3)]+ str(int(cellNumber%3)+1)

return next_move

}

```

Primeiro converto a global em um array simples, ignorando colunas e linhas deixando flat para facilitar.

A cada movimento analisado chamamos o método copyGameState, que como o nome diz, copia o estado do jogo naquele momento, onde aplicamos o MinMax.

O método getBestMove que será chamado recursivamente até finalizar o jogo encontrando um vencedor ou o empate.

Primeiro os espaços vazios são mapeados e verificamos o resultado de cada movimento alternando entre os jogadores.

Os resultados são armazenados em move['score'] para depois de verificar todas as possibilidades encontrar o melhor movimento.

Espero que você tenha se divertido, é possível melhorar a inteligência utilizando algoritmos como Alpha-Beta Pruning ([Wikipedia: AlphaBeta Pruning](https://en.wikipedia.org/wiki/Alpha%E2%80%93beta_pruning)) ou redes neurais, só cuidado para não dar vida a Skynet.

Fique livre para deixar comentários ou perguntas

That's all folks

Código completo:

[InterSystems Iris versão 2021.1.0PYTHON](https://www.notion.so/5be7e2147955bec0f623b718cfd83a9d)

Artigo

Henrique Dias · Nov. 25, 2020

Fala galera! Tudo bem?

Quando @Evgeny.Shvarov anunciou o primeiro InterSystems IRIS Programming Contest, Comecei a pensar em algumas ideias.

Coloquei tudo junto nesse aplicativo e o isc-utils é sobre isso:

Conversões

Temperatura

Distância

Câmbio de Moedas

Clima

Conversão de Escala de Temperatura

IRISAPP>write ##class(diashenrique.Utils.Temperature).CelsiusToFahrenheit(28)

82.4

IRISAPP>write ##class(diashenrique.Utils.Temperature).CelsiusToKelvin(28)

301.15

IRISAPP>write ##class(diashenrique.Utils.Temperature).FahrenheitToCelsius(82.4)

28

IRISAPP>write ##class(diashenrique.Utils.Temperature).FahrenheitToKelvin(82.4)

301.15

IRISAPP>write ##class(diashenrique.Utils.Temperature).KelvinToCelsius(301.15)

28

IRISAPP>write ##class(diashenrique.Utils.Temperature).KelvinToFahrenheit(301.15)

82.37

Conversão de Escala de Distância

IRISAPP>write ##class(diashenrique.Utils.Length).KmToMiles(120)

74.58

IRISAPP>write ##class(diashenrique.Utils.Length).MilesToKm(74.58)

120

Taxa de Câmbio

IRISAPP>do ##class(diashenrique.Utils.ExchangeRate).Latest(1,"USD","ALL")

Date: 2020-03-18

Conversion of 1 USD

GBP Pound sterling 0.843

HKD Hong Kong dollar 7.766

IDR Indonesian rupiah 15449.552

ILS Israeli shekel 3.810

DKK Danish krone 6.835

INR Indian rupee 74.205

CHF Swiss franc 0.965

MXN Mexican peso 23.963

CZK Czech koruna 24.834

SGD Singapore dollar 1.441

THB Thai baht 32.420

HRK Croatian kuna 6.945

EUR Euro 0.915

MYR Malaysian ringgit 4.371

NOK Norwegian krone 10.701

CNY Chinese yuan renminbi 7.035

BGN Bulgarian lev 1.789

PHP Philippine peso 51.620

PLN Polish zloty 4.117

ZAR South African rand 16.977

CAD Canadian dollar 1.440

ISK Icelandic krona 139.656

BRL Brazilian real 5.134

RON Romanian leu 4.431

NZD New Zealand dollar 1.713

TRY Turkish lira 6.447

JPY Japanese yen 107.719

RUB Russian rouble 79.656

KRW South Korean won 1260.106

USD US dollar 1.000

AUD Australian dollar 1.698

HUF Hungarian forint 321.365

SEK Swedish krona 10.081

Parâmetros:

Quantia

Moeda base. Ex.: JPY

Taxas de Câmbio

ALL - para todas as moedas disponíveis na API

Taxas de câmbio de moedas específicas. Ex.: "BRL,AUD,CAD,RUB"

Por data

IRISAPP>do ##class(diashenrique.Utils.ExchangeRate).ByDate("2020-01-01",1,"USD","BRL,JPY,AUD,CAD")

Date: 2020-01-01

Conversion of 1 USD

JPY Japanese yen 108.545

AUD Australian dollar 1.424

CAD Canadian dollar 1.299

BRL Brazilian real 4.020

Parâmetros:

Data = YYYY-MM-DD

Quantia

Moeda base. Ex.: BRL

Taxas de Câmbio

ALL - para todas as moedas disponíveis na API

Taxas de câmbio de moedas específicas. Ex.: "BRL,AUD,CAD,RUB"

Existe uma global ^defaultCurrency, que mantém suas opções de moedas preferidas.

Sendo assim, você pode chamar o ClassMethod Latest, sem nenhum parâmetro

IRISAPP>do ##class(diashenrique.Utils.ExchangeRate).Latest()

Default Base Currency:

Apenas informe a moeda base de sua preferência:

IRISAPP>do ##class(diashenrique.Utils.ExchangeRate).Latest()

Default Base Currency: USD

Date: 2020-03-18

Conversion of 1 USD

GBP Pound sterling 0.843

HKD Hong Kong dollar 7.766

IDR Indonesian rupiah 15449.552

ILS Israeli shekel 3.810

DKK Danish krone 6.835

INR Indian rupee 74.205

CHF Swiss franc 0.965

MXN Mexican peso 23.963

CZK Czech koruna 24.834

SGD Singapore dollar 1.441

THB Thai baht 32.420

HRK Croatian kuna 6.945

EUR Euro 0.915

MYR Malaysian ringgit 4.371

NOK Norwegian krone 10.701

CNY Chinese yuan renminbi 7.035

BGN Bulgarian lev 1.789

PHP Philippine peso 51.620

PLN Polish zloty 4.117

ZAR South African rand 16.977

CAD Canadian dollar 1.440

ISK Icelandic krona 139.656

BRL Brazilian real 5.134

RON Romanian leu 4.431

NZD New Zealand dollar 1.713

TRY Turkish lira 6.447

JPY Japanese yen 107.719

RUB Russian rouble 79.656

KRW South Korean won 1260.106

USD US dollar 1.000

AUD Australian dollar 1.698

HUF Hungarian forint 321.365

SEK Swedish krona 10.081

Clima

IRISAPP>do ##class(diashenrique.Utils.Weather).GetWeather()

Default City:

Default Country:

Default Termo Scale(C,F,K):

O ClassMethod GetWeather, tem opções de preferência também. Para possibilidades padrão, temos:

Cidade

País

Escala de Temperatura (Celsius, Fahrenheit ou Kelvin)

IRISAPP>do ##class(diashenrique.Utils.Weather).GetWeather()

Default City: Boston

Default Country: USA

Default Termo Scale(C,F,K): F

City: Boston | Country: USA

Temperature: 53.46 °F

Real Feel: 46.02 °F

Condition: Clear

Mas, você pode consultar qualquer outra cidade apenas passando os parâmetros:

IRISAPP>do ##class(diashenrique.Utils.Weather).GetWeather("Sao Paulo","Brazil","C")

City: Sao Paulo | Country: Brazil

Temperature: 27.55 °C

Real Feel: 28.4 °C

Condition: Rain

Depois de definir seus parâmetros padrão, eles se tornam opcionais:

IRISAPP>do ##class(diashenrique.Utils.Weather).GetWeather("Sao Paulo","Brazil")

City: Sao Paulo | Country: Brazil

Temperature: 82.17 °F

Real Feel: 83.95 °F

Condition: Rain

Artigo

Cristiano Silva · Jun. 7, 2023

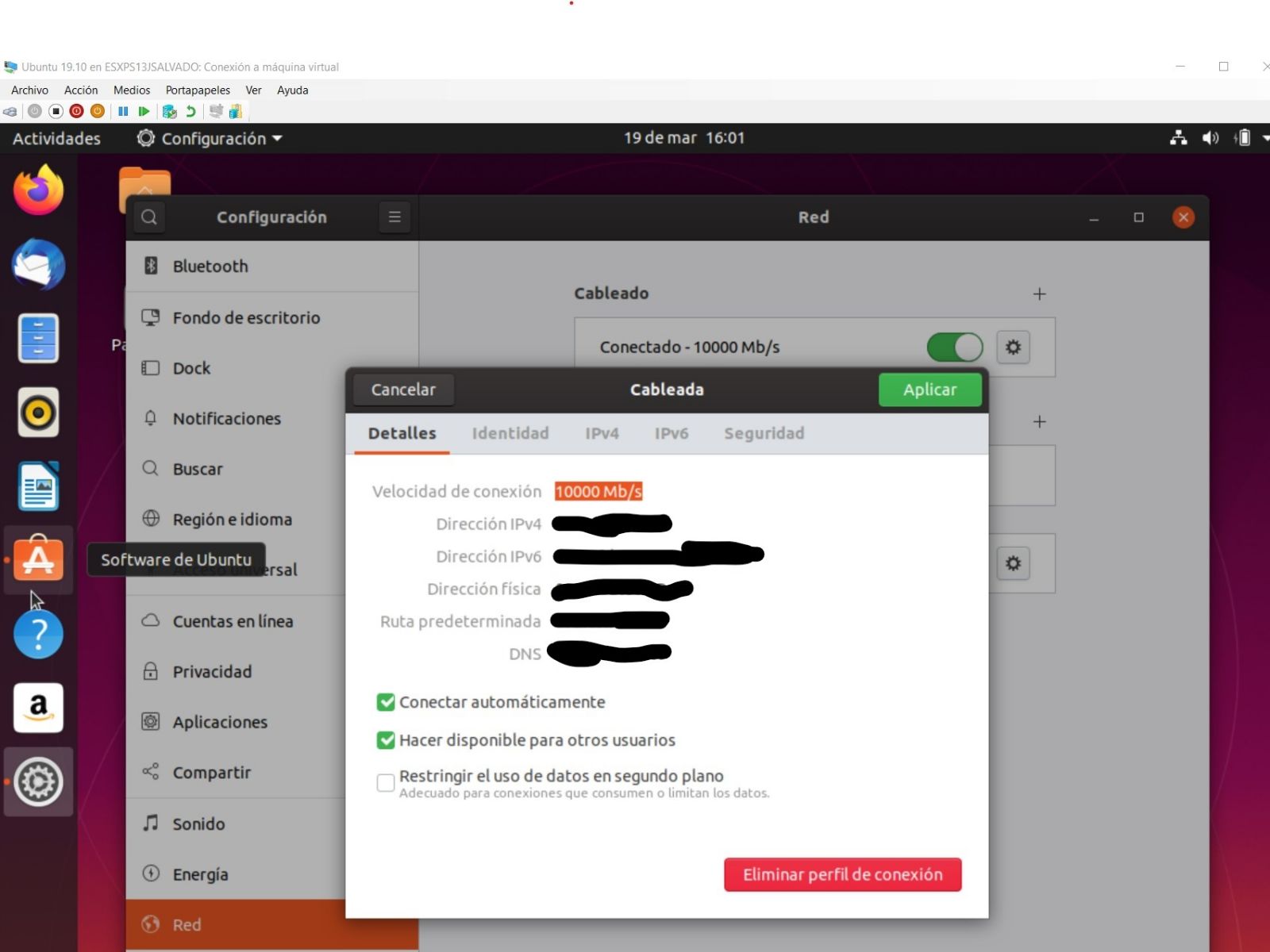

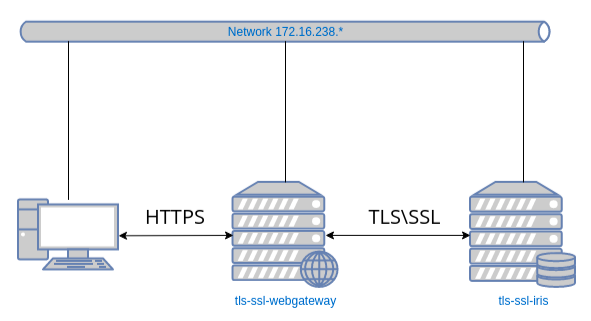

Você já deve ter ouvido falar que, a partir das versões IRIS e HealthShare HealthConnect 2023.2, o Apache Server interno será removido da instalação padrão, então será necessário ter um servidor de aplicativos externo como Apache Server ou NGINX.

Neste artigo, procederei à instalação de um HealthShare HealthConnect 2023.1 para que funcione com um servidor Apache pré-instalado. Para isso usarei uma máquina virtual na qual instalei um Ubuntu 22.04.

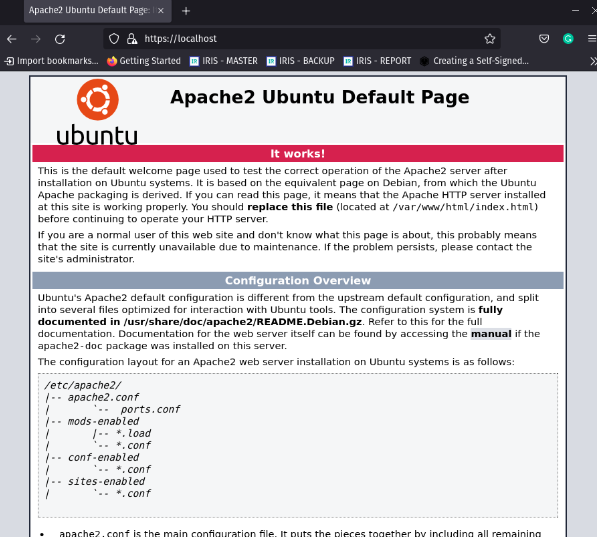

Instalando Apache Server

Como indicamos, devemos instalar previamente nosso servidor Apache e o faremos seguindo as etapas indicadas em seu próprio site.

sudo apt update

sudo apt install apache2

Com o servidor Apache instalado, vamos prosseguir com a instalação do HealthConnect.

Instalando HealthConnect

Vamos revisar o que a documentação oficial da InterSystems nos diz. Se você consultar a documentação, ela nos informa como descompactar o arquivo que baixamos do WRC. No meu caso, terei que fazer alguns ajustes, pois tenho o instalador do HealthConnect em uma pasta compartilhada com minha máquina virtual.

mkdir /tmp/iriskit

chmod og+rx /tmp/iriskit

umask 022

gunzip -c /mnt/hgfs/shared/HealthConnect-2023.1.0.229.0-lnxubuntu2204x64.tar.gz | ( cd /tmp/iriskit ; tar xf - )

Vamos revisar o que estamos fazendo com esses comandos:

Criamos o diretório onde vamos descompactar nossa fonte HealthConnect.

Damos permissões de leitura e execução do diretório criado tanto ao proprietário do arquivo quanto a todos os usuários do grupo do proprietário para poder descompactar o arquivo no diretório indicado.

Damos permissões de leitura, gravação e execução em todos os arquivos e diretórios que serão criados.

Descompactamos o arquivo gz e acessando o caminho onde o descompactamos, descompactamos o arquivo tar.

Vamos ver como ficou nosso diretório temporário.

Perfeito, aqui temos o código do nosso HealthShare HealthConnect. Próximo passo, crie um usuário que será o dono da instalação do HealthConnect, vamos chamá-lo de irisusr e a partir do nosso diretório temporário executaremos o comando de instalação:

sudo useradd irisusr

sudo sh irisinstall

Ao executar a instalação, veremos uma série de opções que teremos que configurar com os valores que desejamos. Neste caso vamos realizar uma instalação PERSONALIZADA para poder configurar o WebGateway com o servidor web Apache

Continuando...

Neste ponto devemos indicar que queremos configurar o Web Gateway com o Apache Web Server já implantado em nosso servidor e continuar definindo seu caminho de instalação.

Configuração do Apache Server

A instalação configurará automaticamente o Web Gateway para funcionar com o servidor Apache e nossa instância APACHETEST do HealthConnect. Neste exemplo, sendo Ubuntu 22.0.4, o arquivo de configuração do Apache está localizado no caminho /etc/apache2/apache2.conf , para outras distribuições Linux você pode consultar a documentação.

Se abrirmos o arquivo apache2.conf e rolar até o final dele, podemos verificar as alterações introduzidas pela instalação do Web Gateway:

Esta configuración está redirigiendo todas las llamadas que reciba el puerto 80 (puerto en el que Apache Server escucha por defecto) con la ruta /csp a nuestro Web Gateway, el cual a su vez enviará la llamada a nuestra instancia de HealthConnect. Por defecto el parámetro CSPFileTypes está configurada únicamente para redireccionar los archivos de tipo "csp cls zen cxw", para poder trabajar con el portal de gestión sin inconveniente lo hemos modificado para aceptar todos los tipos "*". El cambio de CSPFileTypes exige reiniciar Apache Server.

Esta configuração está redirecionando todas as chamadas recebidas pela porta 80 (a porta padrão do Apache Server) com a rota /csp para nosso Web Gateway, que por sua vez enviará a chamada para nossa instância HealthConnect. Por padrão, o parâmetro CSPFileTypes é configurado apenas para redirecionar arquivos do tipo "csp cls zen cxw", para trabalhar com o portal de gerenciamento sem nenhum problema, modificaremos para aceitar todos os tipos "*". Alterar os CSPFileTypes requer uma reinicialização do Servidor Apache.

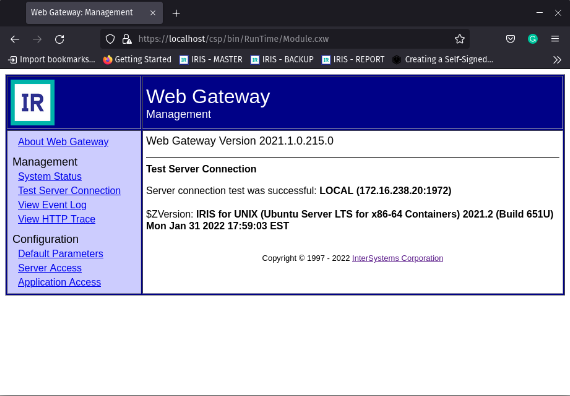

Acceso ao Portal de Gerenciamento do Sistema

Muito bem, temos nosso Apache escutando na porta 80, nosso Web Gateway configurado e a instância HealthConnect iniciada. Vamos testar o acesso ao Portal de Derenciamento do Sistema usando a porta 80 do Apache.

No meu caso, a URL de acesso será http://192.168.31.214/csp/sys/%25CSP.Portal.Home.zen, como a porta 80 é a porta padrão, não será necessário incluí-la na URL.

Aquí tenemos nuestro portal de gestión plenamente operativo. Introduzcamos el usuario y la contraseña que definimos durante la instalación y abramos la configuración del Web Gateway desde la opción System Administrator --> Configuration --> Web Gateway Management. Esta vez el usuario de acceso será CSPSystem. Recordemos que el Web Gateway está configurado para funcionar con el Apache Web Server que hemos instalado previamente.

Aqui temos nosso portal de gestão totalmente operacional. Vamos inserir o nome de usuário e a senha que definimos durante a instalação e abrir a configuração do Web Gateway na opção System Administrator --> Configuration --> Web Gateway Management. Desta vez o usuário de acesso será o CSPSystem. Lembre-se de que o Web Gateway está configurado para funcionar com o Apache Web Server que instalamos anteriormente.

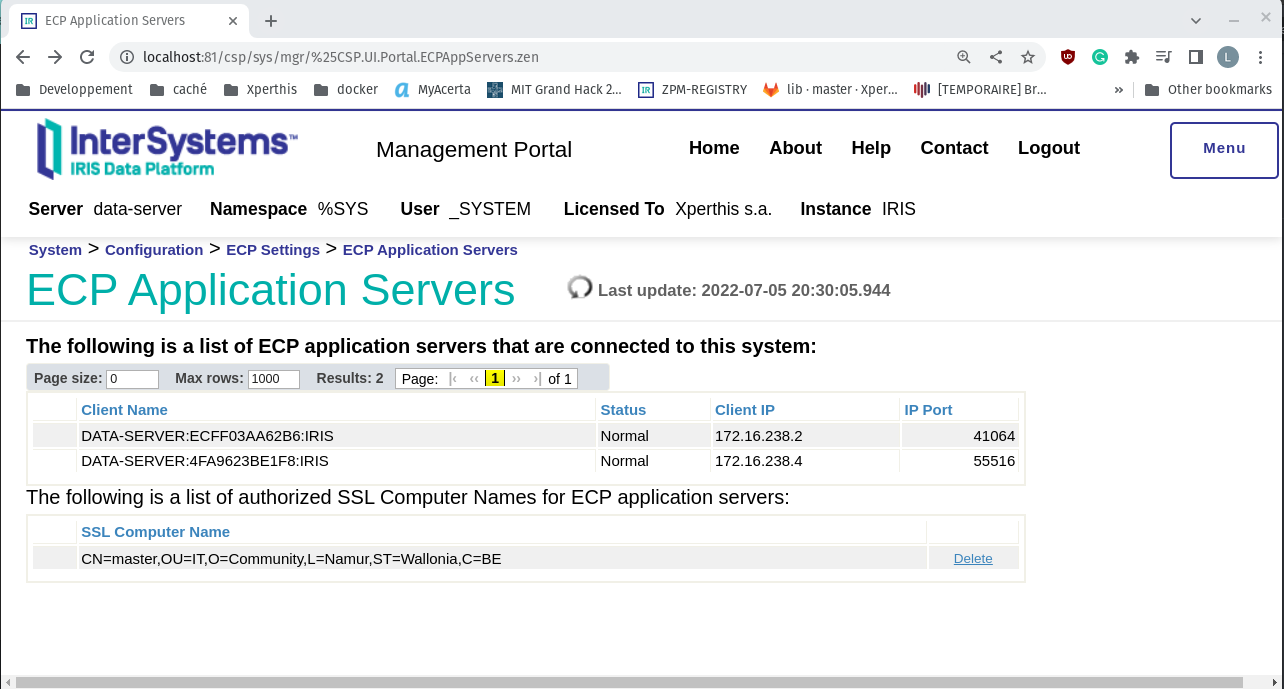

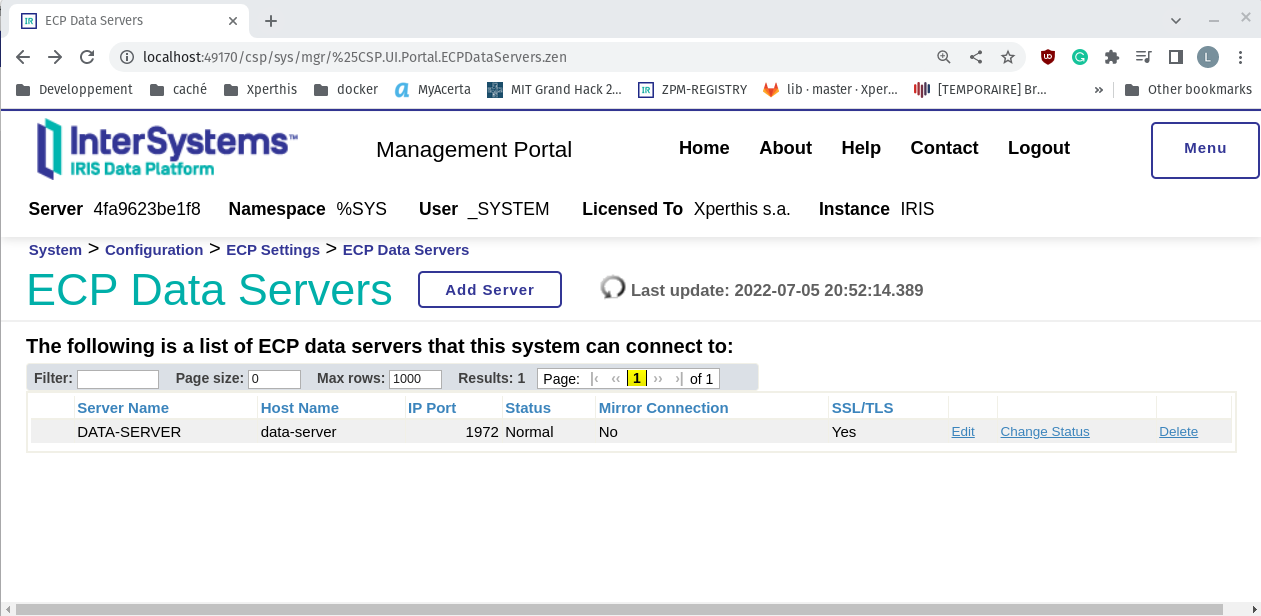

Vamos acessar a opção Server Access para verificar a configuração da nossa instância HealthConnect no Web Gateway:

Temos nossa instância. Vamos verificar como o Web Gateway gerencia as chamadas recebidas do servidor Apache abrindo a opção Application Access.

Vamos ver o que ele faz com URLs começando com /csp

Aí está nossa instância configurada por padrão para receber as chamadas que chegam ao nosso Servidor Apache.

Já temos nossa instância do HealthShare HealthConnect configurada para funcionar com um servidor Apache externo e o Web Gateway. Se você tiver alguma dúvida ou sugestão, sinta-se à vontade para nos enviar um comentário.

Artigo

Heloisa Paiva · Abr. 1

Frequentemente, clientes, fornecedores ou equipes internas me pedem para explicar o planejamento de capacidade de CPU para _para grandes bancos de dados de produção_ rodando no VMware vSphere.

Em resumo, existem algumas práticas recomendadas simples a seguir para dimensionar a CPU para grandes bancos de dados de produção:

- Planeje um vCPU por núcleo de CPU físico.

- Considere o NUMA e, idealmente, dimensione as VMs para manter a CPU e a memória locais para um nó NUMA.

- Dimensione as máquinas virtuais corretamente. Adicione vCPUs apenas quando necessário.

Geralmente, isso leva a algumas perguntas comuns:

- Devido ao hyper-threading, o VMware me permite criar VMs com o dobro do número de CPUs físicas. Isso não dobra a capacidade? Não devo criar VMs com o máximo de CPUs possível?

- O que é um nó NUMA? Devo me preocupar com o NUMA?

- As VMs devem ser dimensionadas corretamente, mas como sei quando estão?

Respondo a estas perguntas com exemplos abaixo. Mas também lembre-se, as melhores práticas não são imutáveis. Às vezes, você precisa fazer concessões. Por exemplo, é provável que grandes VMs de banco de dados de produção NÃO caibam em um nó NUMA e, como veremos, isso está OK. As melhores práticas são diretrizes que você terá que avaliar e validar para seus aplicativos e ambiente.~

Embora eu esteja escrevendo isso com exemplos para bancos de dados rodando em plataformas de dados InterSystems, os conceitos e regras se aplicam geralmente ao planejamento de capacidade e desempenho para qualquer VM grande (Monstro).

Para melhores práticas de virtualização e mais posts sobre planejamento de desempenho e capacidade;

[Uma lista de outros posts na série de Plataformas de Dados InterSystems e desempenho está aqui.](https://community.intersystems.com/post/capacity-planning-and-performance-series-index)

#VMs Monstruosas

Este post é principalmente sobre a implantação de _VMs Monstruosas _, às vezes chamadas de _VMs Largas_. Os requisitos de recursos de CPU de bancos de dados de alta transação significam que eles são frequentemente implantados em VMs Monstruosas.

> Uma VM monstruosa é uma VM com mais CPUs virtuais ou memória do que um nó NUMA físico.

# Arquitetura de CPU e NUMA

A arquitetura de processador Intel atual possui arquitetura de Memória de Acesso Não Uniforme (NUMA). Por exemplo, os servidores que estou usando para executar testes para este post têm:

- Dois sockets de CPU, cada um com um processador de 12 núcleos (Intel E5-2680 v3).

- 256 GB de memória (16 x 16GB RDIMM)

Cada processador de 12 núcleos tem sua própria memória local (128 GB de RDIMMs e cache local) e também pode acessar a memória em outros processadores no mesmo host. Os pacotes de 12 núcleos de CPU, cache de CPU e 128 GB de memória RDIMM são um nó NUMA. Para acessar a memória em outro processador, os nós NUMA são conectados por uma interconexão rápida.

Processos em execução em um processador que acessam a memória RDIMM e Cache local têm menor latência do que atravessar a interconexão para acessar a memória remota em outro processador. O acesso através da interconexão aumenta a latência, então o desempenho não é uniforme. O mesmo design se aplica a servidores com mais de dois sockets. Um servidor Intel de quatro sockets tem quatro nós NUMA.

O ESXi entende o NUMA físico e o agendador de CPU do ESXi é projetado para otimizar o desempenho em sistemas NUMA. Uma das maneiras pelas quais o ESXi maximiza o desempenho é criar localidade de dados em um nó NUMA físico. Em nosso exemplo, se você tiver uma VM com 12 vCPUs e menos de 128 GB de memória, o ESXi atribuirá essa VM para ser executada em um dos nós NUMA físicos. O que leva à regra;

> Se possível, dimensione as VMs para manter a CPU e a memória locais em um nó NUMA.

Se você precisar de uma VM Monstruosa maior que um nó NUMA, está OK, o ESXi faz um trabalho muito bom calculando e gerenciando automaticamente os requisitos. Por exemplo, o ESXi criará nós NUMA virtuais (vNUMA) que agendam de forma inteligente nos nós NUMA físicos para um desempenho ideal. A estrutura vNUMA é exposta ao sistema operacional. Por exemplo, se você tiver um servidor host com dois processadores de 12 núcleos e uma VM com 16 vCPUs, o ESXi pode usar oito núcleos físicos em cada um dos dois processadores para agendar vCPUs da VM, o sistema operacional (Linux ou Windows) verá dois nós NUMA.

Também é importante dimensionar corretamente suas VMs e não alocar mais recursos do que o necessário, pois isso pode levar a recursos desperdiçados e perda de desempenho. Além de ajudar a dimensionar para NUMA, é mais eficiente e resultará em melhor desempenho ter uma VM de 12 vCPUs com alta (mas segura) utilização de CPU do que uma VM de 24 vCPUs com utilização de CPU de VM baixa ou mediana, especialmente se houver outras VMs neste host precisando ser agendadas e competindo por recursos. Isso também reforça a regra;

> Dimensione as máquinas virtuais corretamente.

__Nota:__ Existem diferenças entre as implementações NUMA da Intel e da AMD. A AMD tem múltiplos nós NUMA por processador. Já faz um tempo desde que vi processadores AMD em um servidor de cliente, mas se você os tiver, revise o layout NUMA como parte do seu planejamento.

## VMs Largas e Licenciamento

Para o melhor agendamento NUMA, configure VMs largas;

Correção Junho de 2017: Configure VMs com 1 vCPU por socket.

Por exemplo, por padrão, uma VM com 24 vCPUs deve ser configurada como 24 sockets de CPU, cada um com um núcleo.

>Siga as regras de melhores práticas do VMware..

Consulte [este post nos blogs do VMware para exemplos. ](https://blogs.vmware.com/performance/2017/03/virtual-machine-vcpu-and-vnuma-rightsizing-rules-of-thumb.html)

O post do blog do VMware entra em detalhes, mas o autor, Mark Achtemichuk, recomenda as seguintes regras práticas:

- Embora existam muitas configurações avançadas de vNUMA, apenas em casos raros elas precisam ser alteradas dos padrões.

- Sempre configure a contagem de vCPU da máquina virtual para ser refletida como Núcleos por Socket, até que você exceda a contagem de núcleos físicos de um único nó NUMA físico.

- Quando você precisar configurar mais vCPUs do que há núcleos físicos no nó NUMA, divida uniformemente a contagem de vCPU pelo número mínimo de nós NUMA.

- Não atribua um número ímpar de vCPUs quando o tamanho da sua máquina virtual exceder um nó NUMA físico.

- Não habilite o Hot Add de vCPU a menos que você esteja OK com o vNUMA sendo desabilitado.

- Não crie uma VM maior que o número total de núcleos físicos do seu host.t.

O licenciamento do Caché conta núcleos, então isso não é um problema, no entanto, para software ou bancos de dados diferentes do Caché, especificar que uma VM tem 24 sockets pode fazer diferença para o licenciamento de software, então você deve verificar com os fornecedores.

# Hyper-threading e o agendador de CPU

Hyper-threading (HT) frequentemente surge em discussões, e ouço: "hyper-threading dobra o número de núcleos de CPU". O que, obviamente, no nível físico, não pode acontecer — você tem tantos núcleos físicos quanto possui. O Hyper-threading deve ser habilitado e aumentará o desempenho do sistema. A expectativa é talvez um aumento de 20% ou mais no desempenho do aplicativo, mas a quantidade real depende do aplicativo e da carga de trabalho. Mas certamente não o dobro.

Como postei no [post de melhores práticas do VMware](https://community.intersystems.com/post/intersystems-data-platforms-and-performance-%E2%80%93-part-9-cach%C3%A9-vmware-best-practice-guide), um bom ponto de partida para dimensionar _grandes VMs de banco de dados de produção_ ié assumir que o vCPU tem dedicação total de núcleo físico no servidor — basicamente ignore o hyper-threading ao planejar a capacidade. Por exemplo;

> Para um servidor host de 24 núcleos, planeje um total de até 24 vCPUs para VMs de banco de dados de produção, sabendo que pode haver folga disponível.

Após dedicar tempo monitorando o desempenho da aplicação, do sistema operacional e do VMware durante os horários de pico de processamento, você pode decidir se uma consolidação de VMs mais alta é possível. Na postagem de melhores práticas, eu estabeleci a regra como;

> Um CPU físico (inclui hyper-threading) = Um vCPU (inclui hyper-threading).

## Por que o Hyper-threading não dobra o CPU

O HT em processadores Intel Xeon é uma forma de criar dois CPUs _lógicos _ CPUsem um núcleo físico. O sistema operacional pode agendar eficientemente nos dois processadores lógicos — se um processo ou thread em um processador lógico estiver esperando, por exemplo, por E/S, os recursos do CPU físico podem ser usados pelo outro processador lógico Apenas um processador lógico pode estar progredindo em qualquer ponto no tempo, então, embora o núcleo físico seja utilizado de forma mais eficiente, _o desempenho não é dobrado_.

Com o HT habilitado na BIOS do host, ao criar uma VM, você pode configurar um vCPU por processador lógico HT. Por exemplo, em um servidor de 24 núcleos físicos com HT habilitado, você pode criar uma VM com até 48 vCPUs. O agendador de CPU do ESXi otimizará o processamento executando os processos das VMs em núcleos físicos separados primeiro (enquanto ainda considera o NUMA). Eu exploro mais adiante na postagem se alocar mais vCPUs do que núcleos físicos em uma VM de banco de dados "Monster" ajuda no escalonamento.

### Co-stop e agendamento de CPU

Após monitorar o desempenho do host e da aplicação, você pode decidir que algum sobrecomprometimento dos recursos de CPU do host é possível. Se esta é uma boa ideia dependerá muito das aplicações e cargas de trabalho. Uma compreensão do agendador e uma métrica chave para monitorar podem ajudá-lo a ter certeza de que você não está sobrecomprometendo os recursos do host.

Às vezes ouço; para que uma VM progrida, deve haver o mesmo número de CPUs lógicos livres que vCPUs na VM. Por exemplo, uma VM de 12 vCPUs deve 'esperar' que 12 CPUs lógicos estejam 'disponíveis' antes que a execução progrida. No entanto, deve-se notar que, no ESXi após a versão 3, este não é o caso. O ESXi usa co-agendamento relaxado para CPU para melhor desempenho da aplicação.

Como múltiplos threads ou processos cooperativos frequentemente se sincronizam uns com os outros, não agendá-los juntos pode aumentar a latência em suas operações. Por exemplo, um thread esperando para ser agendado por outro thread em um loop de espera ocupada (spin loop). Para melhor desempenho, o ESXi tenta agendar o máximo possível de vCPUs irmãs juntas. Mas o agendador de CPU pode agendar vCPUs de forma flexível quando há múltiplas VMs competindo por recursos de CPU em um ambiente consolidado. Se houver muita diferença de tempo, enquanto algumas vCPUs progridem e outras irmãs não (a diferença de tempo é chamada de skew), então a vCPU líder decidirá se interrompe a si mesma (co-stop). Observe que são as vCPUs que fazem co-stop (ou co-start), não a VM inteira. Isso funciona muito bem mesmo quando há algum sobrecomprometimento de recursos, no entanto, como você esperaria; muito sobrecomprometimento de recursos de CPU inevitavelmente impactará o desempenho. Mostro um exemplo de sobrecomprometimento e co-stop mais adiante no Exemplo 2.