Limpar filtro

Artigo

Claudio Devecchi · Fev. 8, 2021

### HealthShare Patient Index

Enterprise Master Patient Index - Este é o nome dado ao processo que faz com que os inúmeros cadastros e registros coletados dos vários sistemas das instituições e redes de saúde sejam identificados univocamente e interligados através de um identificador único por indivíduo.

Isto viabiliza uma infinidade de benefícios para as instituições ou redes de saúde, pois permite, além da gestão das duplicidades em um mesmo sistema de prontuário eletrônico, que todos os dados segregados por número de cadastro sejam visualizados de forma consolidada por indivíduo. Cada vez mais, as instituições estão buscando uma abordagem holística do cuidado contínuo, da prevenção e da experiência centrada no paciente.

Falando sobre o produto [Healthshare Patient Index](https://learning.intersystems.com/course/view.php?id=632) da InterSystems, podemos dividi-lo em 6 grandes grupos de funcionalidades.

### 1 - Integração das informações cadastrais dos pacientes

Esta etapa engloba todos os mecanismos de coleta das informações nos sistemas de origem, seja através de API’s com protocolos específicos de saúde como o HL7, seja através de processos específicos ou customizados.

Neste ponto, é importante que a plataforma de integração ofereça uma série de requisitos de interoperabilidade que assegure flexibilidade, governança e segurança.

É muito comum sistemas de prontuário eletrônico internacionais fornecerem nativamente exportações de dados usando o protocolo HL7, que neste caso também é nativo nos produtos da Intersystems. Os sistemas nacionais geralmente demandam processos menos padronizados, e é por isso que é necessário que a plataforma seja de fácil e rápida implementação.

Geralmente as informações são enviadas ou disponibilizadas no momento em que o paciente é admitido nos estabelecimentos de saúde.

A arquitetura deste processo é definida conforme as necessidades de cada organização e disponibilidade dos recursos computacionais.

### 2 - Análise Qualitativa e Normalização

Normalizar significa trazer para um mesmo plano de comparação informações demográficas que foram cadastradas de formas completamente diferentes. É também nesta etapa que todo o “lixo” é removido. Isto não quer dizer que a informação seja ruim, mas que não serve para o processo do MPI.

Se os dados fossem comparados sem esta etapa, provavelmente cadastros de um mesmo indivíduo nunca seriam comparados, dada à discrepância de sistema para sistema.

Se observarmos o processo de cadastro de cada estabelecimento e sistema de origem, veremos uma infinidade de formas de entrada dos dados e diversas maneiras de armazenamento das informações. Isso depende de como cada sistema foi concebido e como cada processo foi implementado em cada setor da organização.

Um exemplo típico é o processo de admissão em alas emergenciais. Muitas vezes o paciente precisa ser atendido antes mesmo de ser identificado. Isso gera uma série de especificidades que precisam ser tratadas em uma análise qualitativa antes mesmo da implementação do processo de captura dos dados.

O outro exemplo muito comum é o cadastramento de recém nascidos. Cada caso é um caso. Em alguns sistemas os nomes são cadastrados com um prefixo “RN DE” seguido pelo nome da mãe. Isso porque os pais não sabem o nome dos bebês antes do parto e eles já precisam constar nos sistemas de prontuário eletrônico. Como todos os sistemas geralmente exigem o CPF, eles podem ser cadastrados com o mesmo CPF da mãe. É claro que este é só um exemplo de uma situação pontual, mas cada caso deve ser estudado e endereçado da forma mais adequada possível.

Além das especificidades de processo, há as que são de armazenamento dos dados. Documentos como CPF, RG e carteirinhas de seguro são armazenados com pontos e traços em alguns sistemas. Em outros são armazenados sem. O mesmo ocorre com datas. Nomes geralmente são armazenados em um único campo, uns com caixa baixa, outros com alta. Alguns são abreviados pela limitação de caracteres.

Endereços são os vilões na normalização. Os sistemas mais modernos são baseados no CEP, outros não. Os que não são sofrem muitas abreviações devidos aos sufixos, títulos ou até mesmo pela limitação dos caracteres.

Enfim, mesmo que em instituições mais modernas tecnologicamente, há sempre os sistemas legados. Estes também são incorporados ao processo de MPI porque trazem informações históricas valiosas para todo o processo assistencial.

Culturalmente e diferentemente dos sistemas norte americanos, os sistemas brasileiros possuem um único campo para capturar os nomes. Para melhorar a eficácia do processo de vinculação é importante que os sistemas tenham a capacidade de separar os nomes, considerando também os primeiros nomes compostos.

Outra capacidade não menos importante é a capacidade de trabalhar com as abreviações nos endereços. Isto requer um dicionário específico de abreviações para o nosso país.

### 3 - Indexação ou formação dos pares de comparação

Nesta etapa é que se decide quais serão os cadastros que serão comparados entre si, formando assim os chamados pares de comparação.

A decisão de se comparar registros não se baseia apenas nos documentos do paciente, assim como o CPF. Isso acontece porque há casos que não se tem o CPF do paciente ou casos que os filhos recebem o CPF dos pais. Para isto é necessário que o processo utilize os dados probabilísticos, assim como o nome, a data de nascimento, o sexo, os dados de contato e o endereço.

É preciso que este processo tenha algoritmos sofisticados para que os sistemas não gerem um número excessivo de comparações indevidas, assim como não deixem de fora comparações necessárias.

Por exemplo: A comparação de todos os “Josés” com todos os outros “Josés” não seria tão eficaz, pois poderia acarretar numa sobrecarga de processamento.

Outro ponto não menos importante nesta fase é a capacidade de se trabalhar com algoritmos fonéticos para o mercado brasileiro, que são completamente diferentes dos algoritmos americanos.

Isso significa que nomes escritos de maneiras diferentes ou equivocadas também serão considerados no processo. Exemplo: Dois cadastros de um determinado paciente com os nomes Walter Xavier e Valter Chavier podem se referir ao mesmo indivíduo.

O Healthshare MPI utiliza um processo extremamente eficiente de análise combinatória que evita este tipo de problema, utilizando tanto informações demográficas determinísticas quanto probabilísticas.

### 4 - Pontuação dos pares

Para cada par de comparação gerado, todas as variáveis demográficas são pontuadas separadamente: Primeiros nomes, nomes do meio, sobrenomes, documentos, sexo, cep, telefones, e-mails e endereços.

Antes de iniciar a comparação, é determinado um peso com uma pontuação máxima e mínima para cada variável, considerando a singularidade de cada uma. Por exemplo, o sexo possui um peso menor que a data de nascimento, que possui peso menor que o nome, que possui um peso menor que o CPF. E assim por diante.

Cada variável possui um algoritmo específico não binário de comparação que vai atribuir uma pontuação entre a mínima e a máxima para cada variável demográfica.

Exemplo: Se o sexo for o mesmo, serão atribuídos 2 pontos. Se não for o mesmo será atribuída a pontuação mínima, -4 pontos. Se o CPF for o mesmo, serão atribuídos 14 pontos,

Primeiros nomes e sobrenomes comuns também recebem pontuações menores que nomes mais comuns, assim como Silva e Souza.

Nomes de casada e solteira também devem ser considerados aqui no Brasil.

### 5 - Avaliação e determinação do identificador unívoco dos pares

Antes desta etapa, é necessário configurar as faixas de pontuação ou limiares que serão utilizados para vincular (mesmo indivíduo) ou não vincular (indivíduos diferentes) os pares de cadastro.

Neste ponto, pode-se definir também a faixa de pontuação dos pares que irão para uma lista de trabalho, passíveis de uma avaliação ou revisão humana.

Limiares a serem configurados:

**Vínculo Automático** – Acima de quantos pontos os pares serão automaticamente vinculados. Exemplo: Se o total de pontos dos pares estiver acima de 35 os mesmos serão automaticamente vinculados e não necessitarão de revisão humana.

**Vínculo com posterior avaliação na Lista de Trabalho** – Entre quantos pontos os pares irão para a lista de trabalho como vinculados (mesmos indivíduos) para avaliação humana. Exemplo: Os pares entre 30 e 35 pontos serão vinculados, mas poderão sofrer revisão de um profissional ou equipe designados para esta tarefa.

**Não vínculo** – Abaixo de quantos pontos os pares não serão vinculados. Exemplo: Se o total de pontos dos pares for abaixo de 30 eles não serão vinculados (indivíduos diferentes).

**Não vínculo com revisão posterior na Lista de Trabalho** – Entre quantos pontos os pares irão para a lista de trabalho como não vinculado (indivíduos diferentes) para uma revisão humana. Exemplo: Os pares entre 25 e 30 pontos não serão vinculados, mas poderão sofrer revisão de um profissional ou equipe designados para esta tarefa.

Há várias situações de exceções, onde mesmo pares com pontuação elevada podem não se referir ao mesmo indivíduo. Um exemplo típico são os gêmeos, que moram na mesma residência. Para isso é necessário que o produto disponibilize de artifícios para identificar estes casos.

Há outras situações que pares com baixa pontuação podem sofrer revisões se determinadas situações ocorrerem. Exemplo: pares com o mesmo CPF e data de nascimento e baixa pontuação. Este caso é no mínimo curioso, pois pode apontar um problema na baixa qualidade dos dados.

No HealthShare Patient Index, estes dispositivos são chamados de regras de vinculação (rules), que prevalecem sobre a regra de pontuação.

O produto já possui nativamente uma série de regras de exceção e elas são fundamentais para a segurança e confiabilidade de todo o processo.

Após esta etapa, todos os cadastros recebem um identificador universal denominado MPIID - Master Patient Index Identification. Os cadastros que possuírem o mesmo MPIID são referentes ao mesmo indivíduo.

### 6 – Serviços e API’s ###

Concluindo todo o processo de vinculação (Matching), é essencial que a plataforma ofereça maneiras passivas ou ativas de se comunicarem ou interoperarem com os sistemas de origem ou outros sistemas. Neste momento entram novamente todos os requisitos de interoperabilidade do produto, que já estão presentes na plataforma HealthShare da Intersystems.

As API’s de consumo do MPI são disponibilizadas neste momento através de protocolos conhecidos (HTTP Soap ou Rest) para que sistemas consigam obter as informações desejadas para diversos casos de uso.

Estes são alguns exemplos comuns de consumo de API’s do HealthShare MPI:

• Obter identificadores de outros sistemas partindo do identificador do sistema consumidor. Este tipo de consulta é denominada pelo IHE como PIX. Exemplo: Antes de enviar a prescrição para o laboratório o sistema de origem envia o seu identificador do cadastro e recebe uma resposta da API com o número do identificador do mesmo paciente no laboratório.

• Realizar pesquisas probabilísticas por dados demográficos. Exemplo: Consultar se existem cadastros demográficos para o paciente de nome Claudio Devecchi Junior. Este tipo de consulta é denominada pelo IHE como PDQ).

• Obter o melhor dado demográfico (Golden Record ou Composite Record) de um determinado paciente para enriquecer os cadastros demográficos ou para aproveitar os seus dados no momento de um determinado cadastro.

Existem também mecanismos ativos, onde o MPI se comunica com os sistemas para enviar informações úteis. Estes mecanismos também podem ser acionados de forma passiva através da chamada das Api’s.

Alguns exemplos são:

• No momento que um cadastro está sendo incluído ou atualizado o MPI pode fazer uma chamada retornando o identificador universal - MPIID. Desta forma o sistema de origem sempre ficará atualizado com este identificador. Quaisquer mudanças nas Listas de Trabalho são gatilhos para este tipo de chamada (callback)

• Quando algum cadastro for incluído e o MPI identificar que já existe esta mesma pessoa no mesmo sistema de origem, já é possível enviar uma notificação de duplicidade. Para os casos de resolução das duplicidades, é importante que exista um serviço específico para receber as mensagens de fusão de pacientes (PIX merge).

### Conclusão

Todo o processo descrito anteriormente demonstra um pouco de como o produto HealthShare Patient Index trata dos desafios na área com relação aos cadastros e identificação dos pacientes e como é importante tratar das especificidades não somente do país, mas de organização para organização.

No próximo artigo, falaremos um pouco de como funciona o Healthshare Unified Care Record (UCR) e de como ele é fundamental para ajudar as instituições na abordagem holística do cuidado contínuo, da prevenção e da experiência centrada no paciente.

Artigo

Heloisa Paiva · Abr. 28

Tenho um novo projeto para armazenar informações de respostas REST em um banco de dados IRIS. Precisarei sincronizar informações de pelo menos duas dúzias de endpoints REST separados, o que significa criar quase essa quantidade de classes ObjectScript para armazenar os resultados desses endpoints.

Poderia usar o ChatGPT para ter uma vantagem inicial na criação dessas classes? A resposta é "Sim", o que é ótimo, já que esta é minha primeira tentativa de usar IA generativa para algo útil. Gerar fotos de girafas tomando sopa estava ficando meio batido...

Aqui está o que eu fiz:

Obter alguma saída de chamada REST JSON de amostra usando "curl" para consultar o endpoint.

Visitar o ChatGPT (a InterSystems fornece uma licença para toda a empresa para os funcionários)

Tenha o seguinte diálogo com o ChatGPT.

Coloquei o seguinte pedido no prompt "Message ChatGPT":

Eu: Gere uma classe ObjectScript que armazenará dados do seguinte JSON:

Apertei "Enter" antes de inserir o JSON, então o ChatGPT me direcionou da seguinte forma:

ChatGPT: Por favor, forneça a estrutura JSON para a qual você gostaria que eu gerasse a classe ObjectScript. Se você tiver um objeto JSON de exemplo, cole-o aqui e eu criarei a classe InterSystems ObjectScript correspondente para você.

Eu inseri o seguinte no prompt:

{

"id": 335818632,

"appId": 113,

"appName": "Batch",

"contentId": 182455380233,

"subject": "Test Subject",

"name": "Test email campaign name",

"counters": {

"processed": 3910,

"deferred": 86,

"unsubscribed": 17,

"statuschange": 17,

"bounce": 153,

"mta_dropped": 8,

"dropped": 299,

"delivered": 3749,

"sent": 3903,

"click": 16,

"open": 323

},

"lastProcessingFinishedAt": 1733232499000,

"lastProcessingStartedAt": 1733232303000,

"lastProcessingStateChangeAt": 1733232499000,

"numIncluded": 4201,

"processingState": "DONE",

"scheduledAt": 1733232300000,

"type": "BATCH_EMAIL"

}

Resposta do ChatGPT:

Aqui está a classe InterSystems ObjectScript que mapeia a estrutura JSON fornecida:

Class MyNamespace.MyJSONData Extends (%Persistent, %JSON.Adaptor)

{

Property id As %Integer;

Property appId As %Integer;

Property appName As %String;

Property contentId As %Integer;

Property subject As %String;

Property name As %String;

Property counters As MyNamespace.Counters;

Property lastProcessingFinishedAt As %BigInt;

Property lastProcessingStartedAt As %BigInt;

Property lastProcessingStateChangeAt As %BigInt;

Property numIncluded As %Integer;

Property processingState As %String;

Property scheduledAt As %BigInt;

Property type As %String;

ClassMethod %OnJSONImport(jsonObject As %Object, instance As MyNamespace.MyJSONData) As %Status

{

Quit ..%JSONImport(jsonObject, .instance)

}

}

Class MyNamespace.Counters Extends (%SerialObject, %JSON.Adaptor)

{

Property processed As %Integer;

Property deferred As %Integer;

Property unsubscribed As %Integer;

Property statuschange As %Integer;

Property bounce As %Integer;

Property mta_dropped As %Integer;

Property dropped As %Integer;

Property delivered As %Integer;

Property sent As %Integer;

Property click As %Integer;

Property open As %Integer;

}

Junto com uma explicação:

Explicação:

Mynamespace.MyJSONData: A principal classe representando o objeto JSON.

As propriedades mapeiam diretamente para os campos no JSON.

Ela estende tanto %Persistent quanto %JSON.Adaptor para persistência e compatibilidade com JSON.

Mynamespace.Counters: Uma classe aninhada para representar o objeto counters no JSON.

Esta classe é definida como um %SerialObject, pois faz parte do objeto principal e não precisa de persistência independente.

Manipulação de JSON:

O %JSON.Adaptor lida automaticamente com a serialização e desserialização de/para o formato JSON.

O método %OnJSONImport permite a personalização da importação JSON, embora o método padrão %JSONImport seja suficiente para esse mapeamento direto.

Você pode salvar esse código em um arquivo de classe e usá-lo para analisar ou armazenar dados JSON. Avise se quiser recursos adicionais ou mais personalizações!

Este código é um ótimo começo, mas eu gostaria que ele se encaixasse no meu pacote chamado“MyPkg”e desse o nome "EmailCampaign" para a classe. Além disso, usando um pouco de NI (Network Intelligence), sei que os valores que geraram as propriedades "%BigInt" são, na verdade, tempos Linux e as propriedades deveriam ser "%Library.PosixTime".

Faço o seguinte pedido (não tenho certeza por que estou dizendo "por favor" para uma máquina; acho que meus pais fizeram um bom trabalho):

Eu: Podemos recriar a classe novamente, renomeando o pacote para "MyPkg" e a Classe como "EmailCampaign"? Além disso, por favor, altere os tipos das propriedades de %BigInt para %Library.PosixTime.

Resposta do ChatGPT:

Aqui está a classe ObjectScript atualizada com o nome do pacote e o nome da classe especificados, e as propriedades de timestamp atualizadas para usar %Library.PosixTime:

Class MyPkg.EmailCampaign Extends (%Persistent, %JSON.Adaptor)

{

Property id As %Integer;

Property appId As %Integer;

Property appName As %String;

Property contentId As %Integer;

Property subject As %String;

Property name As %String;

Property counters As MyPkg.Counters;

Property lastProcessingFinishedAt As %Library.PosixTime;

Property lastProcessingStartedAt As %Library.PosixTime;

Property lastProcessingStateChangeAt As %Library.PosixTime;

Property numIncluded As %Integer;

Property processingState As %String;

Property scheduledAt As %Library.PosixTime;

Property type As %String;

ClassMethod %OnJSONImport(jsonObject As %Object, instance As MyPkg.EmailCampaign) As %Status

{

Quit ..%JSONImport(jsonObject, .instance)

}

}

Class MyPkg.Counters Extends (%SerialObject, %JSON.Adaptor)

{

Property processed As %Integer;

Property deferred As %Integer;

Property unsubscribed As %Integer;

Property statuschange As %Integer;

Property bounce As %Integer;

Property mta_dropped As %Integer;

Property dropped As %Integer;

Property delivered As %Integer;

Property sent As %Integer;

Property click As %Integer;

Property open As %Integer;

}

Junto com esta explicação:

Alterações Feitas:

Nome do Pacote e da Classe:

O pacote agora é CRMBI.

A classe principal foi renomeada para EmailCampaign.

Propriedades de Timestamp:

lastProcessingFinishedAt, lastProcessingStartedAt, lastProcessingStateChangeAt e scheduledAt agora utilizam %Library.PosixTime.

%Library.PosixTime é apropriado para propriedades que armazenam timestamps no formato UNIX.

Outras Propriedades:

Todos os outros campos permanecem inalterados e seguem a estrutura original do JSON.

Esta classe está pronta para lidar com a serialização/desserialização JSON e fornece o mapeamento correto para o objeto aninhado counters. Me avise se precisar de mais ajustes ou tiver novos requisitos!

Depois de copiar o código "como está" para o VSCode, problemas de sintaxe com as chaves foram destacados. Classes ObjectScript não habilitam definições de classe internas.

Pedir ao ChatGPT para corrigir o problema das "chaves" movendo a classe interna MyPkg.Counters para uma classe separada é uma "não-operação"; um humano precisará mover essa classe para outro arquivo. O ChatGPT renomeou essa classe após o seguinte pedido:

Eu: A classe como está escrita não compila. Podemos mover a classe interna chamada MyPkg.Counters para fora da classe principal para sua própria classe e renomeá-la para MyPkg.CampaignCounters?

Resposta do ChatGPT:

Aqui está o código ObjectScript atualizado com a classe MyPkg.CampaignCounters movida para fora como sua própria classe:

Class MyPkg.EmailCampaign Extends (%Persistent, %JSON.Adaptor)

{

Property id As %Integer;

Property appId As %Integer;

Property appName As %String;

Property contentId As %Integer;

Property subject As %String;

Property name As %String;

Property counters As MyPkg.CampaignCounters;

Property lastProcessingFinishedAt As %Library.PosixTime;

Property lastProcessingStartedAt As %Library.PosixTime;

Property lastProcessingStateChangeAt As %Library.PosixTime;

Property numIncluded As %Integer;

Property processingState As %String;

Property scheduledAt As %Library.PosixTime;

Property type As %String;

ClassMethod %OnJSONImport(jsonObject As %Object, instance As MyPkg.EmailCampaign) As %Status

{

Quit ..%JSONImport(jsonObject, .instance)

}

}

Class MyPkg.CampaignCounters Extends (%SerialObject, %JSON.Adaptor)

{

Property processed As %Integer;

Property deferred As %Integer;

Property unsubscribed As %Integer;

Property statuschange As %Integer;

Property bounce As %Integer;

Property mta_dropped As %Integer;

Property dropped As %Integer;

Property delivered As %Integer;

Property sent As %Integer;

Property click As %Integer;

Property open As %Integer;

}

Depois de colar o código acima no VSCode e compilá-lo, o compilador relatou que o tipo chamado "%Object" não existe em ObjectScript. De acordo com a documentação do IRIS, a propriedade para o primeiro parâmetro do método %JSONImport() de %JSON.Adaptor é flexível:

“O argumento de entrada é JSON como uma string ou stream, ou uma subclasse de %DynamicAbstractObject.”

Depois de remover a propriedade "As %Object" para o primeiro parâmetro de %OnJSONImport() na primeira classe e separar as duas classes em arquivos separados, a classe MyPkg.EmailCampaign compilou com sucesso. No entanto, a MyPkg.CampaignCounters não compilou; o ChatGPT não sabe (ainda?) que o sublinhado é um caractere especial em ObjectScript (o operador de concatenação de strings)

Vamos tentar ensiná-lo.

Eu: O caractere sublinhado "_" é um caractere especial em ObjectScript. Por favor, altere as propriedades com um sublinhado em seus nomes para nomes em camel case e remova o sublinhado.

Resposta do ChatGPT:

Aqui está o código atualizado com as propriedades que tinham sublinhados em seus nomes convertidas para camel case:

Class MyPkg.EmailCampaign Extends (%Persistent, %JSON.Adaptor)

{

Property id As %Integer;

Property appId As %Integer;

Property appName As %String;

Property contentId As %Integer;

Property subject As %String;

Property name As %String;

Property counters As MyPkg.CampaignCounters;

Property lastProcessingFinishedAt As %Library.PosixTime;

Property lastProcessingStartedAt As %Library.PosixTime;

Property lastProcessingStateChangeAt As %Library.PosixTime;

Property numIncluded As %Integer;

Property processingState As %String;

Property scheduledAt As %Library.PosixTime;

Property type As %String;

ClassMethod %OnJSONImport(jsonObject As %Object, instance As MyPkg.EmailCampaign) As %Status

{

Quit ..%JSONImport(jsonObject, .instance)

}

}

Class MyPkg.CampaignCounters Extends (%SerialObject, %JSON.Adaptor)

{

Property processed As %Integer;

Property deferred As %Integer;

Property unsubscribed As %Integer;

Property statusChange As %Integer;

Property bounce As %Integer;

Property mtaDropped As %Integer;

Property dropped As %Integer;

Property delivered As %Integer;

Property sent As %Integer;

Property click As %Integer;

Property open As %Integer;

}

Junto com esta explicação:

Mudanças Realizadas:

1. Conversão para Camel Case:

Propriedades em CampaignCounters com underscores agora são escritas em camel case:

statuschange → statusChange

mta_dropped → mtaDropped

2. Nomes de Propriedades em JSON:

ObjectScript irá mapear automaticamente nomes de propriedades em camel case para seus correspondentes com underscore no JSON usando o %JSON.Adaptor.

Este código atualizado compila corretamente e preserva a funcionalidade para serialização/desserialização JSON! Avise-me se precisar de mais ajustes!

O ChatGPT foi além e alterou outra propriedade, uma nomeada com duas palavras separadas, para camel case também (statuschange); estou mantendo essa alteração, já que outras propriedades com nomes semelhantes na classe principal estão todas em camel case.

Com o código gerado mais recente em dois arquivos separados (e removendo a definição "As %Object" na definição do método %OnJSONImport()), todo o código compila com sucesso.

Essas classes geradas são um excelente ponto de partida para o que preciso e repetirei o processo para as outras fontes de dados REST para este projeto, me poupando muita digitação desnecessária.

Artigo

Danusa Calixto · Jul. 27, 2022

**Histórico**

| Versão| Data | Atualizações|

| :----- | :-- | :----- |

| V1 | 2022-02-08 | Início |

| V1.1 | 2022-04-06 | Geração de certificados com arquivo sh em vez de pki-scriptUsando variáveis de ambiente em arquivos de configuração|

Olá Comunidade,

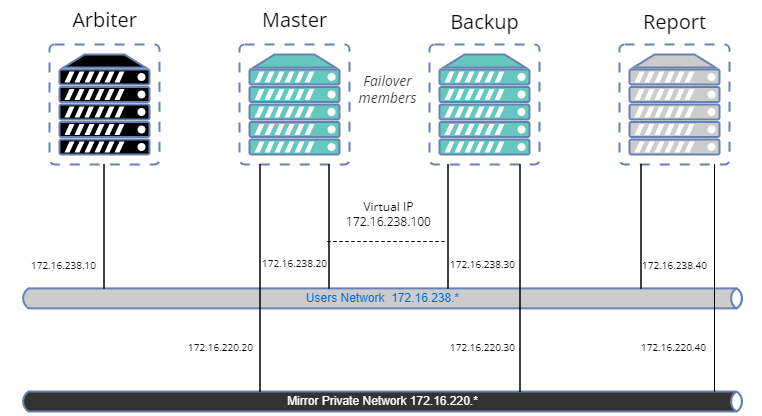

Vocês já configuraram um ambiente espelhado? Tem rede privada, IP virtual, e configuração SSL?

Após fazer isso algumas vezes, eu me dei conta que isso é longo, e há várias ações manuais obrigatórias para gerar os certificados e configurar cada instancia IRIS.

É uma dor no pescoço para quem tem que fazer isso muitas vezes.

Por exemplo, um time de Quality Assurance pode precisar criar um novo ambiente para cada nova versão da aplicação para testar. O time de suporte pode exigir a criação de um ambiente para reproduzir um problema complexo.

Nós definitivamente precisamos de ferramentas para criá-los rapidamente.

Neste artigo iremos criar um exemplo para configurar um Mirror com:

- Arbitro

- Primário

- Membro de backup

- Membro assíncrono de relatorio (leitura e escrita)

- Configuração SSL para transferencia de Journal entre os nós

- Rede privada para o Mirror

- Endereço IP virtual

- Um banco de dados espelhado

À primeira vista, parece um pouco complexo e parece que precisa de muito código, mas não se preocupe.

Existem bibliotecas hospedadas no OpenExchange para realizar facilmente a maioria das operações.

O objetivo deste artigo é fornecer um exemplo de como adaptar o processo às suas necessidades, mas não é um guia de práticas recomendadas em termos de segurança.

Então, vamos criar nossa amostra.

### Ferramentas e bibliotecas

- [config-api](https://openexchange.intersystems.com/package/Config-API): Esta biblioteca será utilizada para configurar o IRIS. Ela suporta configuração de espelhamento desde a versão 1.1.0. Não iremos dar uma descrição detalhada de como usar esta biblioteca. Já existe uma série de artigos. [here](https://community.intersystems.com/post/environment-setup-config-api). Resumindo, config-api será usada para criar um modelo de arquivos de configuração IRIS (formato JSON) e carregá-los facilmente.

- [ZPM](https://openexchange.intersystems.com/package/ObjectScript-Package-Manager).

- Docker.

- OpenSSL.

### Github

Você pode encontrar todos os arquivos necessários em [iris-mirroring-samples repository](https://github.com/lscalese/iris-mirroring-samples/).

### Prepare o seu sistema

Clone o repositorio existente:

```bash

git clone https://github.com/lscalese/iris-mirroring-samples

cd iris-mirroring-samples

```

Se você preferir criar uma amostra do zero, ao invés de clonar o repositório, basta criar um novo diretório com subdiretórios: `backup` e `config-files`. Baixe

[irissession.sh](https://raw.githubusercontent.com/lscalese/iris-mirroring-samples/master/session.sh) :

```

mkdir -p iris-mirroring-samples/backup iris-mirroring-samples/config-files

cd iris-mirroring-samples

wget -O session.sh https://raw.githubusercontent.com/lscalese/iris-mirroring-samples/master/session.sh

```

Para evitar o problema de "permissão negada" posteriormente, precisamos criar o grupo 'irisowner', o usuário 'irisowner', e alterar o grupo do diretório de backup para 'irisowner'

```bash

sudo useradd --uid 51773 --user-group irisowner

sudo groupmod --gid 51773 irisowner

sudo chgrp irisowner ./backup

```

Este diretório será utilizado como volume para compartilhar um backup do banco de dados após configurar o primeiro membro espelho com os outros nós.

### Obtenha uma licença IRIS

O espelhamento não está disponível com a edição da comunidade IRIS.

Se você ainda não tiver uma licença de contêiner IRIS válida, conecte-se ao [Worldwide Response Center (WRC)](https://wrc.intersystems.com) com suas credenciais.

Clique em "Ações" --> "Distribuição online", depois no botão "Avaliações" e selecione "Licença de avaliação"; Preencha o formulário.

Copie seu arquivo de licença `iris.key` para este diretório.

### Login no Intersystems Containers Registry

Por motivos de conveniência, usamos o Intersystems Containers Registry (ICR) para extrair imagens do docker. Se você não souber seu login\\password do docker, basta conectar-se a [SSO.UI.User.ApplicationTokens.cls](https://login.intersystems.com/login/SSO.UI.User.ApplicationTokens.cls) com suas credenciais WRC, e você pode recuperar seu Token ICR.

```bash

docker login -u="YourWRCLogin" -p="YourICRToken" containers.intersystems.com

```

### Crie o banco de dados `myappdata` e o mapeamento de global

Nós não criamos realmente o banco de dados `myappdata` agora, mas preparamos uma configuração para criá-lo no momento da compilação do docker.

Para isso, basta criar um arquivo simples usando o formato JSON;

A biblioteca config-api será usada para carregá-la nas instâncias IRIS.

Crie o arquivo [config-files/simple-config.json](https://github.com/lscalese/iris-mirroring-samples/blob/master/config-files/simple-config.json)

```json

{

"Defaults":{

"DBDATADIR" : "${MGRDIR}myappdata/",

"DBDATANAME" : "MYAPPDATA"

},

"SYS.Databases":{

"${DBDATADIR}" : {}

},

"Databases":{

"${DBDATANAME}" : {

"Directory" : "${DBDATADIR}"

}

},

"MapGlobals":{

"USER": [{

"Name" : "demo.*",

"Database" : "${DBDATANAME}"

}]

},

"Security.Services" : {

"%Service_Mirror" : { /* Habilita o serviço de espelhamento nesta instancia */

"Enabled" : true

}

}

}

```

Este arquivo de configuração permite que você crie um novo banco de dados com configurações padrão e faça o mapeamento global `demo.*` no namespace USER.

Para obter mais informações sobre os recursos do arquivo de configuração [config-api](https://openexchange.intersystems.com/package/config-api), consulte o [artigo](https://community.intersystems.com/post/environment -setup-config-api) ou a [página do github](https://community.intersystems.com/post/environment-setup-config-api)

### O arquivo Docker

O arquivo docker é baseado no [modelo docker] existente (https://github.com/intersystems-community/objectscript-docker-template), mas precisamos fazer algumas alterações para criar um diretório de trabalho, instalar ferramentas para usar IP, instalar ZPM, etc…

Nossa imagem IRIS é a mesma para cada membro do espelho. O espelhamento será configurado no contêiner começando com a configuração correta dependendo de sua função (primeiro membro, backup ou relatório de leitura/gravação). Veja os comentários sobre o Dockerfile abaixo:

```Dockerfile

ARG IMAGE=containers.intersystems.com/intersystems/iris:2021.1.0.215.0

# Não precisa baixar a imagem do WRC. Ele será retirado do ICR no momento da construção.

FROM $IMAGE

USER root

COPY session.sh /

COPY iris.key /usr/irissys/mgr/iris.key

# /opt/demo será nosso diretório de trabalho usado para armazenar nossos arquivos de configuração e outros arquivos de instalação.

# Instale o iputils-arping para ter um comando arping. É necessário configurar o IP virtual.

# Baixe a versão mais recente do ZPM (o ZPM está incluído apenas na edição da comunidade).

RUN mkdir /opt/demo && \

chown ${ISC_PACKAGE_MGRUSER}:${ISC_PACKAGE_IRISGROUP} /opt/demo && \

chmod 666 /usr/irissys/mgr/iris.key && \

apt-get update && apt-get install iputils-arping gettext-base && \

wget -O /opt/demo/zpm.xml https://pm.community.intersystems.com/packages/zpm/latest/installer

USER ${ISC_PACKAGE_MGRUSER}

WORKDIR /opt/demo

# Defina a função de espelho padrão como mestre.

# Ele será substituído no arquivo docker-compose em tempo de execução (mestre para a primeira instância, backup e relatório)

ARG IRIS_MIRROR_ROLE=master

# Copie o conteúdo do diretório config-files em /opt/demo.

# Atualmente criamos apenas uma configuração simples para configurar nosso banco de dados e mapeamento de global.

# Mais adiante neste artigo adicionaremos outros arquivos de configuração para configurar o espelho.

ADD config-files .

SHELL [ "/session.sh" ]

# Instale o ZPM

# Use ZPM para instalar config-api

# Carregue o arquivo simple-config.json com config-api para:

# - criar o banco de dados "myappdata" ,

# - adicionar o mapeamento de global no namespace "USER" para a global "demo.*" no banco de dados "myappdata" .

# Basicamente, o ponto de entrada para instalar seu aplicativo ObjectScript é aqui.

# Para este exemplo, carregaremos o simple-config.json para criar um banco de dados simples e um mapeamento de global.

RUN \

Do $SYSTEM.OBJ.Load("/opt/demo/zpm.xml", "ck") \

zpm "install config-api" \

Set sc = ##class(Api.Config.Services.Loader).Load("/opt/demo/simple-config.json")

# Copie o script de instalação do espelho

COPY init_mirror.sh /

```

### Construa a imagem IRIS

O Dockerfile está pronto; podemos construir a imagem:

```

docker build --no-cache --tag mirror-demo:latest .

```

Essa imagem será usada para executar nós primários, de backup e de relatório.

### O arquivo .env

Os arquivos de configuração JSON e a composição do docker usam variáveis de ambiente.

Seus valores são armazenados em um arquivo chamado `.env`, para este exemplo nosso arquivo env é:

```

APP_NET_SUBNET=172.16.238.0/24

MIRROR_NET_SUBNET=172.16.220.0/24

IRIS_HOST=172.16.238.100

IRIS_PORT=1972

IRIS_VIRTUAL_IP=172.16.238.100

ARBITER_IP=172.16.238.10

MASTER_APP_NET_IP=172.16.238.20

MASTER_MIRROR_NET_IP=172.16.220.20

BACKUP_APP_NET_IP=172.16.238.30

BACKUP_MIRROR_NET_IP=172.16.220.30

REPORT_APP_NET_IP=172.16.238.40

REPORT_MIRROR_NET_IP=172.16.220.40

```

### Prepare o primeiro arquivo de configuração do membro espelho

A biblioteca config-api permite configurar um espelho, então temos que criar um arquivo de configuração dedicado ao primeiro membro do espelho `config-files/mirror-master.json`

Por conveniência, os comentários estão localizados diretamente no JSON. Você pode baixar o [mirror-master.json sem comentários aqui](https://raw.githubusercontent.com/lscalese/iris-mirroring-samples/master/config-files/mirror-master.json).

```json

{

"Security.Services" : {

"%Service_Mirror" : {

"Enabled" : true

}

},

"SYS.MirrorMaster" : {

"Demo" : {

"Config" : {

"Name" : "Demo", /* O nome do nosso espelho */

"SystemName" : "master", /* O nome da instancia no espelhamento */

"UseSSL" : true,

"ArbiterNode" : "${ARBITER_IP}|2188", /* Endereço IP e Porta do nó do Arbitro */

"VirtualAddress" : "${IRIS_VIRTUAL_IP}/24", /* Endereço IP virtual */

"VirtualAddressInterface" : "eth0", /* Interface de rede usada para o endereço de IP virtual */

"MirrorAddress": "${MASTER_MIRROR_NET_IP}", /* Endereço IP deste nó na rede privada do espelho */

"AgentAddress": "${MASTER_APP_NET_IP}" /* Endereço IP deste nó (o Agente é istalado na mesma máquina) */

},

"Databases" : [{ /* Lista de banco de dados para adicionar ao espelhamento */

"Directory" : "/usr/irissys/mgr/myappdata/",

"MirrorDBName" : "MYAPPDATA"

}],

"SSLInfo" : { /* SSL Configuration */

"CAFile" : "/certificates/CA_Server.cer",

"CertificateFile" : "/certificates/master_server.cer",

"PrivateKeyFile" : "/certificates/master_server.key",

"PrivateKeyPassword" : "",

"PrivateKeyType" : "2"

}

}

}

}

```

### Prepare o arquivo de configuração do membro de failover

Crie um arquivo de configuração do membro de backup de failover `config-files/mirror-backup.json`.

Parece o primeiro membro:

```json

{

"Security.Services" : {

"%Service_Mirror" : {

"Enabled" : true

}

},

"SYS.MirrorFailOver" : {

"Demo" : { /* Espelho para juntar */

"Config": {

"Name" : "Demo",

"SystemName" : "backup", /* Este nome de instância no espelho */

"InstanceName" : "IRIS", /* Nome da instancia IRIS do primeiro membro do espelho */

"AgentAddress" : "${MASTER_APP_NET_IP}", /* Endereço IP do agente do primeiro membro espelho */

"AgentPort" : "2188",

"AsyncMember" : false,

"AsyncMemberType" : ""

},

"Databases" : [{ /* DB no espelho */

"Directory" : "/usr/irissys/mgr/myappdata/"

}],

"LocalInfo" : {

"VirtualAddressInterface" : "eth0", /* Interface de rede usada para o endereço IP virtual. */

"MirrorAddress": "${BACKUP_MIRROR_NET_IP}" /* Endereço IP deste nó na rede espelho privada*/

},

"SSLInfo" : {

"CAFile" : "/certificates/CA_Server.cer",

"CertificateFile" : "/certificates/backup_server.cer",

"PrivateKeyFile" : "/certificates/backup_server.key",

"PrivateKeyPassword" : "",

"PrivateKeyType" : "2"

}

}

}

}

```

### Prepare o arquivo de configuração do membro assíncrono de leitura e gravação

É bastante semelhante ao arquivo de configuração de failover. As diferenças são os valores de `AsyncMember`, `AsyncMemberType` e `MirrorAddress`.

Crie o arquivo `./config-files/mirror-report.json`:

```json

{

"Security.Services" : {

"%Service_Mirror" : {

"Enabled" : true

}

},

"SYS.MirrorFailOver" : {

"Demo" : {

"Config": {

"Name" : "Demo",

"SystemName" : "report",

"InstanceName" : "IRIS",

"AgentAddress" : "${MASTER_APP_NET_IP}",

"AgentPort" : "2188",

"AsyncMember" : true,

"AsyncMemberType" : "rw"

},

"Databases" : [{

"Directory" : "/usr/irissys/mgr/myappdata/"

}],

"LocalInfo" : {

"VirtualAddressInterface" : "eth0",

"MirrorAddress": "${REPORT_MIRROR_NET_IP}"

},

"SSLInfo" : {

"CAFile" : "/certificates/CA_Server.cer",

"CertificateFile" : "/certificates/report_server.cer",

"PrivateKeyFile" : "/certificates/report_server.key",

"PrivateKeyPassword" : "",

"PrivateKeyType" : "2"

}

}

}

}

```

### Gere os certificados e configure os nós IRIS

Todos os arquivos de configuração estão prontos!

Agora temos que adicionar script para gerar certificados para comunicação segura entre cada nós. Um script pronto para uso está disponível no repositório [gen-certificates.sh](https://raw.githubusercontent.com/lscalese/iris-mirroring-samples/master/gen-certificates.sh)

```

# sudo é necessário devido ao uso de chown, chgrp chmod.

sudo ./gen-certificates.sh

```

Para configurar cada nó o `init_mirror.sh` será executado no início dos containers. Ele será configurado posteriormente em `docker-compose.yml` na seção de comando `command: ["-a","/init_mirror.sh"]` :

```bash

#!/bin/bash

# Banco de dados usado para testar o espelho.

DATABASE=/usr/irissys/mgr/myappdata

# O diretório contém myappdata com backup feito pelo mestre para restaurar em outros nós e fazer o espelho.

BACKUP_FOLDER=/opt/backup

# Espelhar arquivo de configuração no formato json config-api para o nó mestre.

MASTER_CONFIG=/opt/demo/mirror-master.json

# Espelhar arquivo de configuração no formato json config-api para o nó de backup.

BACKUP_CONFIG=/opt/demo/mirror-backup.json

# Espelhar arquivo de configuração no formato json config-api para o nó assíncrono do relatório.

REPORT_CONFIG=/opt/demo/mirror-report.json

# O nome do espelho

MIRROR_NAME=DEMO

# Lista de membros do espelho .

MIRROR_MEMBERS=BACKUP,REPORT

# Realizado no mestre.

# Carregue a configuração do espelho usando config-api com o arquivo /opt/demo/simple-config.json.

# Inicie um Job para aceitar automaticamente outros membros chamados "backup" e "report" para ingressar no espelho (evite validação de manual no gerenciamento do portal).

mestre() {

rm -rf $BACKUP_FOLDER/IRIS.DAT

envsubst < ${MASTER_CONFIG} > ${MASTER_CONFIG}.resolved

iris session $ISC_PACKAGE_INSTANCENAME -U %SYS

Artigo

Alessandro Marin · Nov. 26, 2020

Estou planejando implementar a Inteligência de Negócio (BI) com base nos dados de minhas instâncias. Qual é a melhor maneira de configurar meus bancos de dados e ambiente para usar o DeepSee?

Este tutorial aborda essa questão mostrando três exemplos de arquitetura para DeepSee. Começaremos com um modelo de arquitetura básico e destacaremos suas limitações. O modelo subsequente é recomendado para aplicações de Inteligência de Negócio (BI) de complexidade intermediária e deve ser suficiente para a maioria dos casos de uso. Terminaremos este tutorial descrevendo como aumentar a flexibilidade da arquitetura para gerenciar implementações avançadas.

Cada exemplo neste tutorial apresenta novos bancos de dados e mapeamentos globais, junto com uma discussão sobre por que e quando eles devem ser configurados. Ao construir a arquitetura, os benefícios fornecidos pelos exemplos mais flexíveis serão destacados.

Antes de começar

Servidores primários e analíticos

Para tornar os dados altamente disponíveis, a InterSystems geralmente recomenda usar as soluções de espelhamento ou sombreamento e então basear a implementação DeepSee no servidor espelho/sombra. A máquina que hospeda a cópia original dos dados é chamada de servidor Primário, enquanto as máquinas que hospedam cópias dos dados e as aplicações de Inteligência de Negócio (BI) costumam ser chamados de servidores Analíticos (ou, às vezes, de Relatórios)

Ter servidores primários e analíticos é muito importante, o principal motivo é evitar problemas de desempenho em qualquer um dos servidores. Verifique a documentação sobre a Arquitetura Recomendada.

Dados e código da aplicação

Armazenar dados de origem e código no mesmo banco de dados geralmente funciona bem apenas para aplicações de pequena escala. Para aplicações mais extensas, é recomendado armazenar os dados de origem e código em dois bancos de dados dedicados, o que permite compartilhar o código com todos os namespaces onde o DeepSee é executado, mantendo os dados separados. O banco de dados de dados de origem deve ser espelhado no servidor de produção. Este banco de dados pode ser somente leitura ou leitura-gravação. É recomendável manter o registro do diário habilitado para este banco de dados.

As classes de origem e as aplicações personalizados devem ser armazenados em um banco de dados dedicado nos servidores de produção e analítico. Observe que esses dois bancos de dados para o código-fonte não precisam estar sincronizados ou mesmo rodar a mesma versão do Caché. Normalmente, o registro no diário não é necessário, desde que o backup do código seja feito regularmente em outro lugar.

Neste tutorial teremos a seguinte configuração. O namespace do APP no servidor analítico tem o APP-DATA e o APP-CODE como bancos de dados padrão. O banco de dados APP-DATA tem acesso aos dados (a classe da tabela de origem e seus fatos) no banco de dados de dados de origem no Primário. O banco de dados APP-CODE armazena o código Caché (arquivos .cls e .INT) e outros códigos personalizados. Essa separação de dados e código é uma arquitetura típica e permite ao usuário, por exemplo, implantar com eficiência o código DeepSee e a aplicação personalizada.

Executar DeepSee em diferentes namespaces

As implementações de Inteligência de Negócio (BI) usando DeepSee geralmente são executadas a partir de namespaces diferentes. Nesta postagem, mostraremos como configurar um único namespace de APP, mas o mesmo procedimento se aplica a todos os namespaces onde a aplicação de inteligência de negócio é executada.

Documentação

Recomenda-se familiarizar-se com a página de documentação Executando a Configuração Inicial. Esta página inclui a configuração de aplicações web, como colocar DeepSee globais em bancos de dados separados e uma lista de mapeamentos alternativos para DeepSee globais.

* * *

Na segunda parte desta série mostraremos com a implementação de um modelo básico de arquitetura Excelente artigo!

Ansioso pela série completa

Pergunta

Henrique Dias · Dez. 16, 2020

Fala pessoal, tudo bem?

Criei uma tabela com 100k registros. No SELECT, retorna tudo belezinha. No entanto, quando tento criar um cubo utilizando essa tabela como base, o cubo é compilado com sucesso. No entanto, quando faço o BUILD, ele gera apenas 1 fato.

Alguém já se deparou com alguma situação similar?

Alguns detalhes:

Class diashenrique.olist.data.order Extends %Persistent

{

Property customerID As diashenrique.olist.data.customer;

Property orderStatus As %String;

Property purchaseTimeStamp As %TimeStamp;

Property approvedTimeStamp As %TimeStamp;

Property deliveredCarrierDate As %TimeStamp;

Property deliveredCustomerDate As %TimeStamp;

Property estimatedDelivery As %TimeStamp;

Index OrderStatusIndex On orderStatus;

Index customerIndex On customerID;

Index purchaseIndex On purchaseTimeStamp;

Storage Default

{

<Data name="orderDefaultData">

<Value name="1">

<Value>%%CLASSNAME</Value>

</Value>

<Value name="2">

<Value>customerID</Value>

</Value>

<Value name="3">

<Value>orderStatus</Value>

</Value>

<Value name="4">

<Value>purchaseTimeStamp</Value>

</Value>

<Value name="5">

<Value>approvedTimeStamp</Value>

</Value>

<Value name="6">

<Value>deliveredCarrierDate</Value>

</Value>

<Value name="7">

<Value>deliveredCustomerDate</Value>

</Value>

<Value name="8">

<Value>estimatedDelivery</Value>

</Value>

</Data>

<DataLocation>^orderD</DataLocation>

<DefaultData>orderDefaultData</DefaultData>

<IdLocation>^orderD</IdLocation>

<IndexLocation>^orderI</IndexLocation>

<StreamLocation>^orderS</StreamLocation>

<Type>%Storage.Persistent</Type>

}

}

IRISAPP>d ##class(%DeepSee.Utils).%PrintBuildErrors("OrderCube")

0 build error(s) for 'OrderCube'

IRISAPP>Do ##class(%DeepSee.Utils).%BuildCube("OrderCube")

Building cube [OrderCube]

Existing cube deleted.

Fact table built: 1 fact(s) (1 worker(s) used)

Fact indices built: 1 fact(s) (1 worker(s) used)

Complete

Elapsed time: 0.209013s

Source expression time: 0.000003s

Abraços,

Henrique Caso alguém se depare com esse mesmo cenário no futuro, a causa do problema estava no tipo de indice.

@Eduard.Lebedyuk respondeu na Community em inglês e deixarei o link para quem quiser maiores detalhes.

https://community.intersystems.com/post/fact-table-1-x-sql-select-100k#comment-140541 Segue a resposta em português do @Eduard.Lebedyuk :

Os cubos dependem muito de índices de bitmap para serem executados rapidamente.

Principalmente, cada fato na tabela de fatos deve ser acessível por meio do índice de bitmap.

No passado, os índices de bitmap funcionavam apenas com inteiros positivos, mas agora parece haver uma abordagem %BID - essencialmente uma chave substituta.

Eu acho que o InterSystems BI deveria gerar um erro ou gerar um %BID ou oferecer para gerar um %BID se a propriedade id da classe do fato não for um inteiro positivo.

Artigo

Heloisa Paiva · Mar. 10, 2023

Introdução

Esse artigo tem a intenção de ser um simples tutorial sobre como criar conexões ODBC e trabalhar com elas, já que eu achei o assunto um pouco confuso quando estava começando, mas tive pessoas incríveis que pegaram minha mão e me guiaram para conseguir, e eu acredito que todos merecem esse tipo de ajuda também.

Vou dividir cada pequena parte em seções, então sinta-se à vontade para pular para a que sentir necessidade, apesar de eu recomendar ler o texto na íntegra.

Vou usar os dados de exemplo criados num artigo anterior, Tutorial - forma mais rápida de criar uma base de dados de exemplo: Samples.PersistentData, com as propriedades Name e Age.

Criando a conexão

Abra a Fonte de Dados ODBC - procure por ODBC na barra de pesquisa do seu computador e vai encontrar facilmente.

Selecione a aba DNS de sistema

Clique em Adicionar

Selecione o driver apropriado - para esse exemplo vou utilizar InterSystems IRIS ODBC35

Escolha um nome para a conexão

Digite o servidor, porta e namespace que quer conectar (ex.: IP 12.0.0.1, porta 1972 e namespace SAMPLE)

Digite o Usuário e a Senha que vai usar para se conectar

Clique em "Testar conexão" para ver se tudo está funcionando corretamente - se não for bem sucedida, cheque novamente usuário, senha, servidor, porta e namespace, e também cheque se o IRIS está ligado (para esse exemplo), ou se precisa de uma VPN para esse conexão.

OBS.: Eu não sei dizer se esses passos são similares para Linux ou iOS, perdão!

Usando sua conexão numa Business Operation numa produção

Esse é apenas um exemplo de como pode colocar essa conexão em prática, mas é um muito utilizado.

Com um Business Operation com adaptador "EnsLib.SQL.OutboundAdapter" em uma produção, abra a aba de configurações e expanda a parte de Parâmetros Básicos.

Você verá um input de DSN como esse:

Expanda o input e ache a conexão que acabamos de criar. Se não estiver ali, garanta que a conexão foi criada na Fonte de Dados ODBC correta (32-bit ou 64-bit). Se não aparecer, simplesmente siga os passos novamente na outra opção e cheque o input de DSN outra vez.

Credenciais

O IRIS pode precisar de um usuário e senha para poder acessar essa conexão, então você deve fornecê-los.

Logo abaixo do input de DSN, você vai encontrar um input de Credenciais com uma lupa ao lado.

Clique na lupa e você vai se encontrar no menu de credenciais.

Na aba à sua direita, clique em "Novo", digite um ID que facilitará que você identifique a credencial, o usuário e a senha necessários e salve.

Muito bem! Agora que você tem as credenciais, pode voltar para a produção e selecioná-las pelo ID que escolheu.

PS.: um exemplo para você testar

Para esse simples tutorial, eu criei a seguinte classe num namespace diferente do que tem a tabela "Sample.PersistentData":

Class Sample.ODBC.Operation Extends Ens.BusinessOperation

{

Parameter ADAPTER = "EnsLib.SQL.OutboundAdapter";

Property Adapter As EnsLib.SQL.OutboundAdapter;

Parameter INVOCATION = "Queue";

Method LegalAge(Request As Sample.request, Response As Sample.response) As %Status

{

// instanciate the response

Do Request.NewResponse(.Response)

// Execute the query and select the first result

Do ..Adapter.ExecuteQuery(.result, "SELECT Name, Age from Sample.PersistentData where Age > 20")

Do result.%Next()

// just for visualizing, sets the first result in the response

Set Response.result = result.%Get("Name")_" "_result.%Get("Age")

Quit 1

}

XData MessageMap

{

<MapItems>

<MapItem MessageType="Sample.request">

<Method>LegalAge</Method>

</MapItem>

</MapItems>

}

}

Conclusão

Obrigada por ler e eu espero que tenha sido útil!

Sinta-se à vontade para me contatar sobre qualquer dúvida.

Artigo

Anton Umnikov · jan 11, 2021

IRIS External Table é um projeto de código aberto da comunidade InterSystems, que permite usar arquivos armazenados no sistema de arquivos local e armazenamento de objetos em nuvem, como o AWS S3, como tabelas SQL.

Ele pode ser encontrado no GitHub , Open Exchange e está incluído no InterSystems Package Manager, ZPM.

Para instalar o External Table a partir do GitHub, use:

git clone https://github.com/antonum/IRIS-ExternalTable.git

iris session iris

USER>set sc = ##class(%SYSTEM.OBJ).LoadDir("/IRIS-ExternalTable/src", "ck",,1)

Para instalar usando o ZPM Package Manager:

USER>zpm "install external-table"

## Trabalhando com arquivos locais

Vamos criar um arquivo simples parecido com este:

a1,b1

a2,b2

Abra seu editor favorito e crie o arquivo ou apenas use uma linha de comando no linux/mac:

echo $'a1,b1\na2,b2' > /tmp/test.txt

No IRIS SQL, crie uma tabela para representar este arquivo:

create table test (col1 char(10),col2 char(10))

Converta a tabela para usar o armazenamento externo:

CALL EXT.ConvertToExternal(

'test',

'{

"adapter":"EXT.LocalFile",

"location":"/tmp/test.txt",

"delimiter": ","

}')

E finalmente, consulte a tabela:

select * from test

Se tudo funcionar conforme o esperado, você verá uma saída como esta:

col1 col2

a1 b1

a2 b2

Agora volte ao editor, altere o conteúdo do arquivo e execute novamente a consulta SQL. Uau!!! Você está lendo os novos valores de seu arquivo local no SQL.

col1 col2

a1 b1

a2 b99

## Lendo dados a partir do S3

Em você pode obter acesso a dados atualizados constantemente sobre o COVID, armazenados pela AWS no data lake público.

Vamos tentar acessar uma das fontes de dados neste data lake: `s3://covid19-lake/rearc-covid-19-nyt-data-in-usa/csv/us-states`

Se você tiver a ferramenta de linha de comando AWS instalada, pode repetir as etapas abaixo. Caso contrário, vá direto para a parte SQL. Você não precisa de usar um AWS específico instalado em sua máquina para acompanhar a parte SQL.

$ aws s3 ls s3://covid19-lake/rearc-covid-19-nyt-data-in-usa/csv/us-states/

2020-12-04 17:19:10 510572 us-states.csv

$ aws s3 cp s3://covid19-lake/rearc-covid-19-nyt-data-in-usa/csv/us-states/us-states.csv .

download: s3://covid19-lake/rearc-covid-19-nyt-data-in-usa/csv/us-states/us-states.csv to ./us-states.csv

$ head us-states.csv

date,state,fips,cases,deaths

2020-01-21,Washington,53,1,0

2020-01-22,Washington,53,1,0

2020-01-23,Washington,53,1,0

2020-01-24,Illinois,17,1,0

2020-01-24,Washington,53,1,0

2020-01-25,California,06,1,0

2020-01-25,Illinois,17,1,0

2020-01-25,Washington,53,1,0

2020-01-26,Arizona,04,1,0

Portanto, temos um arquivo com uma estrutura bastante simples. Com cinco campos delimitados.

Para expor esta pasta S3 como um External Table, primeiro, precisamos criar uma tabela "regular" com a estrutura desejada:

-- create external table

create table covid_by_state (

"date" DATE,

"state" VARCHAR(20),

fips INT,

cases INT,

deaths INT

)

Observe que alguns nomes de campo como “Date” são palavras reservadas no IRIS SQL e precisam ser colocados entre aspas duplas. Em seguida, precisamos converter esta tabela “regular” para a tabela “externa”, com base no bucket AWS S3 e tipo CSV.

-- convert table to external storage

call EXT.ConvertToExternal(

'covid_by_state',

'{

"adapter":"EXT.AWSS3",

"location":"s3://covid19-lake/rearc-covid-19-nyt-data-in-usa/csv/us-states/",

"type": "csv",

"delimiter": ",",

"skipHeaders": 1

}'

)

Se você observar com atenção, os argumentos dos procedimentos EXT.ExternalTable são o nome da tabela e a string JSON, contendo vários parâmetros, como localização para procurar por arquivos, adaptador, delimitador, etc. Além da AWS S3, o External Table oferece suporte ao armazenamento BLOB do Azure, Cloud Buckets e o sistema de arquivos local. O GitHub Repo contém referências para a sintaxe e as opções suportadas em todos os formatos.

E finalmente, consulte a tabela:

-- query the table

select top 10 * from covid_by_state order by "date" desc

[SQL]USER>>select top 10 * from covid_by_state order by "date" desc

2. select top 10 * from covid_by_state order by "date" desc

date state fips cases deaths

2020-12-06 Alabama 01 269877 3889

2020-12-06 Alaska 02 36847 136

2020-12-06 Arizona 04 364276 6950

2020-12-06 Arkansas 05 170924 2660

2020-12-06 California 06 1371940 19937

2020-12-06 Colorado 08 262460 3437

2020-12-06 Connecticut 09 127715 5146

2020-12-06 Delaware 10 39912 793

2020-12-06 District of Columbia 11 23136 697

2020-12-06 Florida 12 1058066 19176

Compreensivelmente, leva mais tempo para consultar dados da tabela remota, do que na tabela "IRIS nativa" ou com base global, porém, ela é completamente armazenada e atualizada em nuvem e está sendo puxada para o IRIS "nos bastidores".

Vamos explorar mais alguns recursos do External Table.

## %PATH e tabelas, com base em vários arquivos

Em nossa pasta de exemplo, o bucket contém apenas um arquivo. Mais frequentemente, ele teria vários arquivos com a mesma estrutura, onde nome do arquivo identifica o carimbo de data/hora ou deviceid de algum outro atributo que desejaremos usar em nossas consultas.

O campo %PATH é adicionado automaticamente a cada External Table e contém o caminho completo para o arquivo de onde a linha foi recuperada.

select top 5 %PATH,* from covid_by_state

%PATH date state fips cases deaths

s3://covid19-lake/rearc-covid-19-nyt-data-in-usa/csv/us-states/us-states.csv 2020-01-21 Washington 53 1 0

s3://covid19-lake/rearc-covid-19-nyt-data-in-usa/csv/us-states/us-states.csv 2020-01-22 Washington 53 1 0

s3://covid19-lake/rearc-covid-19-nyt-data-in-usa/csv/us-states/us-states.csv 2020-01-23 Washington 53 1 0

s3://covid19-lake/rearc-covid-19-nyt-data-in-usa/csv/us-states/us-states.csv 2020-01-24 Illinois 17 1 0

s3://covid19-lake/rearc-covid-19-nyt-data-in-usa/csv/us-states/us-states.csv 2020-01-24 Washington 53 1 0

Você pode usar este campo %PATH em suas consultas SQL como em qualquer outro campo.

## Dados ETL para "Tabelas Regulares"

Se sua tarefa é carregar dados do S3 em uma tabela IRIS, você pode usar o External Table como uma ferramenta ETL. Apenas faça:

INSERT INTO internal_table SELECT * FROM external_table

No nosso caso, se quisermos copiar os dados sobre COVID do S3 para a tabela local:

--create local table

create table covid_by_state_local (

"date" DATE,

"state" VARCHAR(100),

fips INT,

cases INT,

deaths INT

)

--ETL from External to Local table

INSERT INTO covid_by_state_local SELECT TO_DATE("date",'YYYY-MM-DD'),state,fips,cases,deaths FROM covid_by_state

## JOIN entre IRIS - tabela nativa e externa. Consultas federadas

External Table é uma tabela SQL. Ele pode ser unido a outras tabelas, usado em subseleções e UNIONs. Você pode até combinar a tabela IRIS “Regular” e duas ou mais tabelas externas de fontes diferentes na mesma consulta SQL.

Tente criar uma tabela regular, como os nomes de estado correspondendo com códigos de estado, como por exemplo, Washington – WA. E junte-a com nossa tabela baseada em S3.

create table state_codes (name varchar(100), code char(2))

insert into state_codes values ('Washington','WA')

insert into state_codes values ('Illinois','IL')

select top 10 "date", state, code, cases from covid_by_state join state_codes on state=name

Altere 'join' para 'left join' para incluir linhas para as quais o código de estado não foi definido. Como você pode ver, o resultado é uma combinação de dados do S3 e sua tabela IRIS nativa.

## Acesso seguro aos dados

A AWS Covid Data Lake é público. Qualquer pessoa pode ler dados dele sem qualquer autenticação ou autorização. Na vida real, você desejará acessar seus dados de forma segura, evitando que estranhos espiem seus arquivos. Os detalhes completos da AWS Identity and Access Management (IAM) estão fora do escopo deste artigo. Mas o mínimo que você precisa saber é que você precisa de pelo menos a chave de acesso e a chave secreta da conta da AWS para acessar dados privados em sua conta.

AWS usa autenticação de chave/segredo de conta para assinar solicitações. https://docs.aws.amazon.com/general/latest/gr/aws-sec-cred-types.html#access-keys-and-secret-access-keys

Se você estiver executando o IRIS External Table na instância EC2, a maneira recomendada de lidar com a autenticação é usar as funções da instância EC2 https://docs.aws.amazon.com/AWSEC2/latest/UserGuide/iam-roles-for-amazon-ec2.html. O IRIS External Table será capaz de usar as permissões dessa função. Nenhuma configuração extra é necessária.

Em uma instância local/não EC2, você precisa especificar o AWS_ACCESS_KEY_ID e AWS_SECRET_ACCESS_KEY, especificando variáveis de ambiente ou instalando e configurando o cliente AWS CLI.

export AWS_ACCESS_KEY_ID=AKIAEXAMPLEKEY

export AWS_SECRET_ACCESS_KEY=111222333abcdefghigklmnopqrst

Certifique-se de que a variável de ambiente esteja visível em seu processo IRIS. Você pode verificá-lo executando:

USER>write $system.Util.GetEnviron("AWS_ACCESS_KEY_ID")

Ela deve retornar o valor da chave.

ou instale o AWS CLI, seguindo as instruções aqui https://docs.aws.amazon.com/cli/latest/userguide/install-cliv2-linux.html e execute:

aws configure

O External Table poderá, então, ler as credenciais dos arquivos de configuração do aws cli. Seu shell interativo e o processo IRIS podem estar sendo executados em contas diferentes. Certifique-se de executar `aws configure` na mesma conta do seu processo IRIS.

Artigo

Henrique Dias · Mar. 6, 2021

@José.Pereira e eu criamos um bom projeto e gostaríamos de falar um pouco deste projeto para vocês.

O que é IRIS RAD Studio?

IRIS RAD Studio é a nossa ideia de low-code para mostrar o que é possível, oferecendo mais facilidade e flexibilidade aos desenvolvedores.

Por que?

Porque não!? Aplicações low-code tem ganho grande destaque no mercado nos últimos anos e a imagem abaixo mostra o "Magic Quadrant" atual fornecido pela Gartner para plataformas empresariais de aplicação low-code. O que mostra o quão interessante é esse mercado.

RESTForms2

RESTForms2 é uma das peças-chave para nosso projeto. Como descrito por @Eduard.Lebedyuk neste artigo, RESTForms é um backend REST API para aplicações web modernas

https://community.intersystems.com/post/restforms-rest-api-your-classes

Funcionalidades

Com a utilização de RESTForms2, classes persistentes herdadas de dc.irisrad.FormAdaptor, ganham automaticamente um formulário CRUD (Create, Read, Update, Delete). Os formulários disponíveis são exibidos na página inicial.

Cada formulário, além das funcionalidades básicas de CRUD, também possui:

Pesquisa geral

Pesquisa avançada de um campo em específico

Criação de filtros combinados

Agrupamento

Exportação do Datagrid para Excel

Além da geração automática dos formulários baseado no JSON fornecido pelo RESTForms2, uma coisa que queremos oferecer aos usuários é o nosso Import Wizard.

Import Wizard

A funcionalidade apresentada anteriormente com o projeto iris-analytics-package, permite a qualquer usuário:

Importar um arquivo CSV

Criar uma classe persistente de acordo com o arquivo importado

Criar um cubo para ser utilizado pelo InterSystems Analytics

Gerar um dashboard de exemplo com base nos dados

E se além disso, você também pudesse editar esse arquivo? Se você tivesse a possibilidade de criar novas informações, editar as informações providas pelo CSV ou até mesmo deletar linhas desnecessárias?

Com IRIS RAD Studio você pode! 😃

Criando novas classes

Se você possui classes existentes que herdam dc.irisrad.FormAdaptor, já pode tirar proveito dos recursos oferecidos pelo RAD Studio.

Para novas classes, criamos um endpoint onde você fornece a classe desejada no formato JSON e voilà

Exemplo:

{ "name": "My.ClassName", "displayFormName": "My tasks", "displayProperty": "text", "fields": [{ "name":"text", "displayName":"Task name", "type":"%Library.String", "required": false },{ "name":"taskDate", "displayName":"Task date", "type":"%Library.TimeStamp" },{ "name":"important", "displayName":"Important", "type":"%Library.Boolean" },{ "name":"completed", "displayName":"Completed", "type":"%Library.Boolean" }]}

Facinho, né?!

Hmmm... mas você deve estar se perguntando "E se eu não tenho essa familiaridade toda com JSON, ou se não entendo nada da parte técnica?"

Calma... IRIS RAD Studio também oferece uma interface gráfica para a criação de novas classes!

Criando novas classes - Wizard

A ideia do low-code é justamente evitar que código seja escrito pelo seu usuário. E isso inclui descrever uma classe e suas propriedade no formato JSON!

A interface criada permite que você crie o nome da sua classe, forneça a descrição que o seu formulário terá.

Clicando no botão Save, ela abrirá um datagrid onde você pode definir as propriedades da sua classe, ou se preferir chamar assim, as colunas da sua tabela.

Assim que terminar de definir, basta clicar em Compile e está pronto para utilizar seu novo formulário!

Roadmap

Acreditamos que esse projeto tem muito potencial para ser explorado. Caso bem recebido pela comunidade, gostaria de explorar essas possibilidades e criar um roadmap com todos.

Assim, cada vez mais teremos um produto que atenda a necessidade geral.

Demo

Disponibilizamos a aplicação no link abaixo:https://irisrad.contest.community.intersystems.com/csp/irisapp/login.html

Se você quer saber o usuário e senha, primeiro, precisa votar no nosso projeto! Sacanagem hehehe nós informamos o usuário/senha na nossa página no OpenExchange

https://openexchange.intersystems.com/package/iris-rad-studio

Hora da votação

Se você gostou da nossa ideia, e acredita que merecemos seu voto, corre lá e nos ajude 😃 Seu voto é muito importante para nós

iris-rad-studio

https://openexchange.intersystems.com/contest/12

Artigo

ROBSON SERPA DA ROSA · Jun. 28, 2021

Uma VIEW em SQL é basicamente uma instrução SQL preparada.Deve ser executado e montado como qualquer outra consulta SQL.VIEW MATERIALIZADA significa que o conteúdo é coletado antes das mãos e pode ser recuperado com bastante rapidez.Eu vi o conceito primeiro com meu concorrente favorito chamado O * e eles fizeram muito barulho sobre isso. { favorite: because I could win every benchmark against them }

Dependendo da construção individual dessas views materializadas, atualizações e manutenção podem ser necessárias.No Caché / IRIS isso existe quase desde sempre e consideramos isso normal e um fato dado.A maioria dos desenvolvedores simplesmente não está ciente disso e, com um pouco de polimento, pode ser apresentado como um excelente recurso.Além disso, qualquer atualização e manutenção acontecem como uma funcionalidade integrada sem nenhum esforço extra.

Veja este exemplo:Em nossa famosa classe Sample.Person no namespace SAMPLES, estendi e reconstruí seu índice.

/// Define an index for <property>Name</property>.Index NameIDX On Name [ Data = (Name, Home.State, SSN) ];

E sendo experiente e confortável com o gerador de consultas, você sabe que

SELECT ID, Name, Home_State, SSN from Sample.Person

será executado rapidamente usando apenas o índice global ^ Sample.PersonI ("NameIDX")e nunca toque em seus dados globais.Essa é basicamente a funcionalidade de uma View materializada e a atualização está implícita.

Definido como VIEW (de MgmtPortal, já que Studio não é tão prático) você obtém esta classe.

Class Sample.Person.NameView [ ClassType = view , CompileAfter = Sample.Person , DdlAllowed , Not ProcedureBlock , SqlTableName = NameView , ViewQuery = { SELECT ID , Name , Home_State , SSN from Sample.Person } ] { Parameter READONLY = 1; }

Mas se você quiser um pouco mais de conforto, como um backlink para seus dados, pode mapear o próprio índice global.Portanto, você pode aplicar a sintaxe JOIN implícita e ter uma tabela totalmente funcional como aqui

SELECT Name, BaseClass->DOB, HomeState, SSN,"%CLASSNAME",BaseClass FROM Sample_Person.NameIDX

e aqui está a definição da classe e você deve projetá-la manualmente

/// mapped index /// Index NameIDX On Name [ Data = (Name, Home.State, SSN) ];Class Sample.Person.NameIDX Extends %Persistent [ Final ]{Property IndexName As %String [ InitialExpression = "NameIDX", ReadOnly ];Property SQLUPPERname As %String [ ReadOnly ];Property BaseClass As Sample.Person [ ReadOnly ];Index min On (IndexName, SQLUPPERname, BaseClass) [ IdKey ];/// Classname of Index SourceProperty %CLASSNAME As %String [ ReadOnly ];/// Person's name.Property Name As %String [ ReadOnly ];/// Person's home address. This uses an embedded object.Property HomeState As %String [ ReadOnly ];/// Person's Social Security number. This is validated using pattern match.Property SSN As %String(PATTERN = "3N1""-""2N1""-""4N") [ ReadOnly ];Parameter READONLY = 1;Parameter MANAGEDEXTENT As INTEGER = 0;Storage Default{ <Data name="NameIDXDefaultData"> <Value name="1"> <Value>%CLASSNAME</Value> </Value> <Value name="2"> <Value>Name</Value> </Value> <Value name="3"> <Value>HomeState</Value> </Value> <Value name="4"> <Value>SSN</Value> </Value> </Data> <DataLocation>^Sample.PersonI</DataLocation> <DefaultData>NameIDXDefaultData</DefaultData> <IdLocation>^Sample.Person.NameIDXD</IdLocation> <IndexLocation>^Sample.Person.NameIDXI</IndexLocation> <StreamLocation>^Sample.Person.NameIDXS</StreamLocation> <Type>%Library.CacheStorage</Type>} }

Este é um exemplo de codificação funcionando no Caché 2018.1.3 e IRIS 2020.2

Não será sincronizado com as novas versões

Também NÃO é atendido pelo Suporte da InterSystems!

Artigo

Danusa Calixto · Out. 27, 2022

Por que eu amo ObjectScript e por que eu acho que poderia amar Python ainda mais

Eu estava olhando o tópico de mensagens sobre o assunto "Desempenho ao construir uma string separada por vírgulas" e comecei a escrever uma resposta. No entanto, me distraí, a página foi atualizada e perdi meu texto. Não podia gastar tempo reescrevendo minha resposta, então comecei a escrever este documento em vez disso.

Comecei a escrever na linguagem MUMPS no início da minha carreira. Eu escrevia blocos de código bastante concisos e densos em que exercícios como o exemplo da string eram verdadeiros desafios. O desempenho dos servidores VAX ou Digital DEC eram aproveitados até a última gota. Planejávamos onde globais importantes ficariam em um disco. Quando o Caché foi lançado, ainda estávamos trabalhando com M/SQL. Durante um período, estive envolvido em diversas comparações de desempenho entre o Caché e o Oracle, Sybase e SQL Server. Criávamos um esquema de algumas tabelas, preenchidas com milhões de registros, e executávamos várias pesquisas no banco de dados resultante. Eu costumava escrever duas versões de declaração SQL. Uma era uma declaração SQL pura, e a outra era uma consulta personalizada que eu escrevia na definição de classe. A maior parte da lógica está no "Fetch", e eu elaborava esse método para maximizar os indíces definidos e usar ^CachéTemp para qualquer junção complexa de resultados provisórios. Às vezes, eu criava jobs de uma ou mais subconsultas que gerariam os globais temporários e resolvia as junções após a conclusão de todos os processos de jobs. O resultado poderia ser resumido da seguinte maneira:

Inserir dados no banco de dados usando SQL ou Caché Objects sempre foi mais rápido do que qualquer outro DB. Usar COS puro e conjuntos globais diretos era uma ordem de grandeza mais rápida do que SQL, Objects e qualquer outro banco de dados. O banco de dados resultante teria aproximadamente metade do tamanho de um criado por qualquer banco de dados relacional.

Ao comparar o código que escrevi no meu método "Fetch" com o código gerado pelo Caché SQL Engine, vi que usei menos variáveis, 25% menos linhas e o código ficou mais legível.

O número de leituras de blocos de dados físicos seria praticamente o mesmo que o código gerado pelo M/SQL. No entanto, o número de leituras lógicas do pool de buffers globais seria 20% menor que o M/SQL.

Recorri a todos os truques possíveis de desenvolvedores MUMPS. Usei comandos como "execute", "job" (criando threads para lidar com subconsultas em paralelo de forma eficaz), indireção e pós-condições. Recomendamos aos desenvolvedores que não usem esses recursos de linguagem para escrever código legível e capaz de ser mantido por outros desenvolvedores.

Eu inicializaria variáveis desta forma:

set (a,b,c,d)="",(x,y,z)=0,p1=+$h,p2=...,pN=99

Espremi o máximo de expressões possível em uma linha de código. Acreditávamos que a leitura de cada linha de código no "buffer de execução" resultava em um custo. Portanto, o número de linhas de código executadas sempre teve um efeito direto e inverso no desempenho.

Quando trabalho com código escrito por outro desenvolvedor e noto blocos de código que consistem em um comando definido por cada linha, fico um pouco agitado e sempre condenso essas 30 linhas em uma. Me apaixonei por Caché Objects. Vinte e cinco anos depois, esse caso durou mais que dois relacionamentos sérios e um casamento. Definições de classe, com nomes de propriedade precisos e bastante legíveis, indexação de bitmap em tudo, a menos que a indexação de busca possa fazer melhor. Quando possível, relacionamentos pais-filhos em vez de um-muitos. Uso uma chave primária personalizada em tabelas de código quando a indexação de bitmap não é necessária porque set record=$g(^global(code)) sempre será mais rápido que

set record="",rowId=$o(^IndexGlobal("IndexName",code,"")) set:$l(rowId) record=^Global(rowId)

Havia algumas formas de declarações SQL select com que o M/SQL não era compatível ou executava mal. Em geral, o Caché era 2 a 3 vezes mais rápido do que qualquer outro banco de dados.

Ao longo dos anos, o mecanismo SQL melhorou significativamente. A indexação de bitmap e iFind foi lançada. Usamos a indexação iFind nos nomes e endereços de pacientes em um banco de dados de 15 milhões de pessoas. Todos os outros campos são indexados por bitmap. Quando recebemos uma Pesquisa de Paciente de FHIR com vários parâmetros, oferecemos suporte a todos os qualificadores e operadores de especificação FHIR. Construímos uma declaração SQL que começa com uma junção em todas as entidades do paciente de FHIR, que armazenamos em classes persistentes. Estou reivindicando o uso do repositório IRIS for Health para nossa próxima fase de desenvolvimento. O IRIS teve dois lançamentos e amadureceu desde a primeira vez que trabalhei com ele na versão 2019.1. A junção é seguida por qualquer cláusula iFind em Nomes e Endereços, se especificada nos critérios de pesquisa. As cláusulas AND/OR são adicionadas para os campos nos critérios de pesquisa que sabemos serem compatíveis com índices bitmap. As pesquisas determinísticas ou probabilísticas que realizamos são tão rápidas e precisas que ainda me fazem pular de animação (na minha idade!!!).

Preciso confessar que nunca gostei do SQL quando fazia parte de um grupo cada vez menor de desenvolvedores que escreviam código MUMPS no final dos anos 80. Meus colegas foram rápidos em aderir ao Oracle ou SQL Server. Às vezes, era difícil não entrar em um estado de desespero quando ouvia opositores gritando: "O MUMPS está morto".