Limpar filtro

Artigo

Daniel Noronha da Silva · Jun. 9, 2023

Pesquisando sobre InterSystems IRIS e como ela pode transformar o negócio de uma organização me deparei com uma possibilidade: Como uma grande empresa pode melhorar sua eficiência operacional e oferecer uma experiência de compra mais personalizada para seus clientes?

Digamos que uma grande empresa do setor de varejo possui uma grande quantidade de dados de vendas, estoque e preferências de clientes que precisam ser analisados para identificar padrões e esse grande volume de dados precisa ser gerenciado e processado em tempo real para criar uma experiência de compra mais personalizada para cada cliente. Nesse aspecto a tecnologia InterSystems IRIS cai como uma luva para atender aos requisitos dessa empresa.

O InterSystems IRIS foi projetado para trabalhar com cargas de trabalho em tempo real, o que é essencial para análise de dados em grande volumes em ambientes de rápidas mudanças. Com capacidade de processar transações em alta velocidade e em tempo real, a plataforma IRIS pode lidar com esse tipo de dados sem nenhum problema. Principalmente nos tempos de hoje com o advento de microserviços e infraestrutura inteligente, a plataforma InterSystems IRIS é altamente escalável e pode lidar com grandes volumes de transações em tempo real, isso significa que, a empresa pode expandir sua infraestrutura de TI para atender às suas necessidades crescentes sem comprometer o desempenho ou a disponibilidade do sistema.

Segurança e integridade dos dados, a InterSystems IRIS permite que a empresa integre facilmente dados de várias fontes, incluindo bancos de dados relacionais e não relacionais, arquivos de texto e dados estruturados e não estruturados, com isso a empresa pode acessar e analisar facilmente todos os seus dados independente de onde estejam armazenados. Também podemos aplicar machine learning, a plataforma IRIS possui recursos avançados de aprendizado de máquina permitindo que a empresa treine modelos de machine learning para análise preditiva e recomendações personalizadas. Com essas capacidades a empresa pode analisar os dados dos clientes para identificar padrões de comportamento e oferecer recomendações de produtos personalizados com base em seus históricos de compras e preferências.

A InterSystems IRIS pode ser aplicada e utilizadas pelas mais diversas áreas do mercado, mas nesse caso em específico, para uma grande varejista é uma solução perfeita para obter insights, coletando os dados de vendas e estoque em tempo real em suas lojas físicas e online, esses dados são enviados para a IRIS processar em real time. Também, a IRIS integra dados de várias fontes, com isso podemos ajustar a produção, o estoque e a oferta de produtos para atender à demanda dos clientes.

Artigo

Claudio Devecchi · Jun. 20, 2023

Neste artigo, vou compartilhar o tema que apresentamos no Global Summit 2023, na sessão Tech Exchange. Eu e @Rochael.Ribeiro.

Nesta oportunidade, abordamos os seguintes tópicos, os quais iremos explorar neste artigo:

Ferramentas Open Exchange para o desenvolvimento rápido de APIs

Open Api Specification (OAS)

Maneira Tradicional versus Desenvolvimento Rápido

API Composta (Interoperabilidade)

Abordagens Spec-First ou Api-First

Governança e Monitoramento de Api's

Demonstração (vídeo)

Ferramentas Open Exchange para o Desenvolvimento Rápido de APIs Rest

Como estamos falando de desenvolvimento rápido de APIs modernas (Rest / json) vamos utilizar duas ferramentas do Intersystems Open Exchange:

A primeira é um framework para desenvolvimento rápido de APIs a qual iremos detalhar neste artigo.

https://openexchange.intersystems.com/package/IRIS-apiPub

A segunda é para utilizarmos o Swagger como interface de visualização da especificação e documentação das APIs Rest desenvolvidas na plataforma IRIS, bem como a sua utilização/execução. A base para o seu funcionamento é o padrão Open Api specification (OAS), descrito a seguir:

https://openexchange.intersystems.com/package/iris-web-swagger-ui

O que é Open API Specification (OAS)?

É um padrão utilizado mundialmente para definir, documentar e consumir APIs. Na maioria dos casos, as APIs são desenhadas antes mesmo da sua implementação. Vamos falar mais sobre isso nos próximos tópicos.

Mas este padrão também serve para agilizar testes e chamadas das APIs em ferramentas (Rest Apis Clients) de mercado, como o Swagger, Postman, Insomnia, etc…

Forma tradicional de publicação de uma API usando o Intersystems IRIS

Imagine que queremos publicar uma API com base em um método IRIS já existente (figura abaixo).

No método tradicional:

1: Temos que pensar em como os consumidores irão chamá-la. Por exemplo: Qual path e verbo iremos utilizar e como iremos responder. Se em um objeto JSON ou como um plain/text.

2: Vamos ter que construir um novo método em uma classe %CSP.REST que irá manipular a chamada http e irá fazer uma chamada para este método.

3: Vamos manipular a resposta do método para a resposta http planejada para o usuário final.

4: Teremos que pensar em como iremos prover o código de sucesso e como iremos tratar as exceções.

5: Vamos mapear a rota para o nosso novo método.

6: Temos que pensar em como iremos prover a documentação da API para o usuário final. Iremos usar o Open Api Specification?

7: E se por exemplo tivermos um método com um payload de requisição ou resposta, o tempo de implementação de tudo irá aumentar, porque o payload também deverá ser documentado.

E como podemos ser mais rápidos?

Simplesmente marcando o método IRIS com o atributo [WebMethod], seja ele qual for, que o framework irá cuidar da sua publicação, utilizando-se do padrão OAS 3.x.

E por quê o padrão 3.x é tão importante?

Porque ele também documenta detalhadamente todas as propriedades dos payloads na entrada e saída.

Desta maneira, quaisquer ferramentas Rest Client de mercado podem instantaneamente se acoplar às APIs, como o Insomnia, Postman, Swagger, etc...

Utilizando o Swagger já iremos visualizar a nossa API (acima) e já podemos chamá-la.

Customização da API

Mas e se eu precisar customizar a minha API?

Por exemplo: Ao invés do nome do método eu quero que o path seja outro. E quero que os parâmetros de entrada estejam no path, não somente como um query param.

Definimos uma notação específica acima do método, onde podemos complementar as meta-informações que o método por si só não provê.

Neste exemplo estamos definindo um outro path para a nossa api e complementando as informações para o usuário final ter uma api mais amigável.

Mapa de projeção de método IRIS para API Rest

Este framework suporta inúmeros tipos de parâmetros.

Neste mapa podemos destacar os tipos complexos de parâmetros, ou seja, os objetos. Eles serão expostos automaticamente como um payload JSON e cada propriedade será devidamente documentada para o usuário final.

Interoperabilidade (Apis Compostas)

Suportando tipos complexos, é possível também expor métodos construídos para a Interoperabilidade.

É um cenário propício para a construção de APIs compostas, que se utilizam de orquestração de múltiplos componentes externos (outbounds).

Isso significa que os objetos ou mensagens utilizadas como request ou response serão automaticamente publicadas e interpretadas por ferramentas como o swagger.

E é uma forma excelente para testar componentes da interoperabilidade, pois geralmente um template do payload já é carregado para que o usuário saiba quais propriedades a API se utiliza.

Primeiro o desenvolvedor pode focar no teste, depois pode fazer o refinamento e customizar a exposição da API Rest.

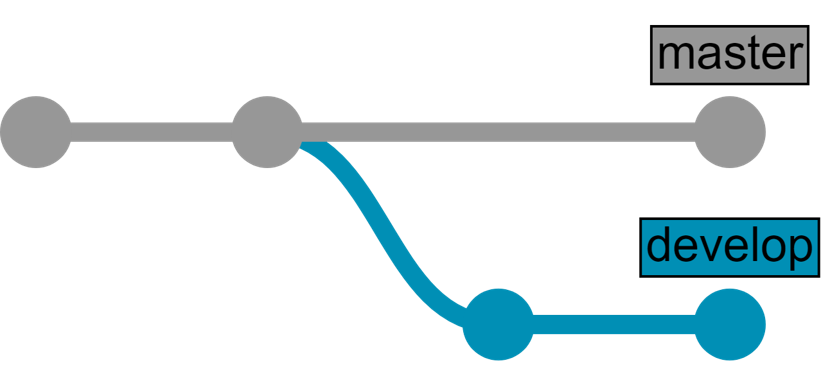

Abordagem Spec-first ou Api-first

Outro conceito amplamente utilizado atualmente é ter a definição da API antes mesmo de sua implementação.

Com este framework é possível fazer a importação de uma especificação (OAS) para uma classe com a estrutura (spec) dos métodos já definidos, faltando apenas a sua implementação.

Governança e Monitoramento de Apis

Para a governança das APIs, é igualmente recomendada a utilização do IAM em conjunto com o apiPub.

Além de ter múltiplos plugins, o IAM pode se acoplar rapidamente às APIs através do padrão OAS.

O apiPub oferece um tracing adicional para as APIs que será demonstrado a seguir.

Demonstração

Download & Documentação

Intersystems Open Exchange: https://openexchange.intersystems.com/?search=apiPub

Documentação Completa: https://github.com/devecchijr/apiPub Muito bom Claudio! Esse é um recurso que com certeza facilita em muito a vida do desenvolvedor!

Parabéns. Obrigado Djeniffer! Fala @Claudio.Devecchi

O aplicativo é excelente e o artigo está muito bem detalhado! Isso facilita demais a vida de quem desenvolve e busca novas formas de criação. abracos Valeu pelo feedback meu caro @Henrique.GonçalvesDias !

Abraços

Anúncio

Danusa Calixto · Jun. 26, 2023

Olá Comunidade!

Os artigos publicados como tradução para ganhar a bonificação durante o período do concurso foram listados junto com os artigos concorrente. Porém, quero informá-los, de que eles não foram avalizados como artigos participantes e não participaram da votação. Eles foram apurados somente para o efeito da bonificação.

As publicações de traduções correspondentes ao informado acima foram:

Alterar o trace do Visualizador de Mensagens para JSON em vez de XML publicado por @Heloisa.Paiva

API para importar/exportar rotinas publicado por @Heloisa.Paiva

Melhores Templates publicado por @Heloisa.Paiva

Instalando Apache Server e HealthShare HealthConnect no Ubuntu Linux publicado por @Cristiano.Silva

Como obter informações de erro de resultados de compilação em massa de rotina/classe publicado por @Miqueias.Santos

Enviando mensagens para Kafka publicado por @Miqueias.Santos

Exemplo do FHIR e IntegratedML publicado por @Luana.Machado

Agradecemos a todos pela contribuição com as traduções publicadas. Continuem a avaliar e traduzir os artigos de outras comunidades para a comunidade em Português. Isso nos ajuda a manter a comunidade ativa e sempre atualizada.

Ótimo trabalho de vocês 😉

Anúncio

Danusa Calixto · Abr. 2

Olá Comunidade!

Animados com as novidades disponibilizadas na versão mais recente dos produtos InterSystems IRIS, InterSystems IRIS for Health, and HealthShare Health Connect ?

A versão 2025.1 dos produtos está cheia de novidades incluindo melhorias na tela de Configuração da Produção e no Editor DTL.

Saiba mais sobre a experiência aprimorada do usuário para a construção de integrações com os produtos InterSystems®. Aya Heshmat, Product Manager do HealthShare® Health Connect, explica como esses fluxos de trabalho são projetados para melhorar a navegação, fornecer filtragem mais inteligente, otimizar a edição avançada e permitir a integração perfeita do controle de origem.

Assista ao vídeo Building Integrations: A New User Experience e fique por dentro!

Compartilhe conosco nos comentários suas impressões e feedback! 😉

Artigo

Mark Bolinsky · Nov. 23, 2020

## Introdução

Recentemente, a InterSystems concluiu uma comparação de desempenho e escalabilidade da IRIS for Health 2020.1, cujo foco foi a interoperabilidade do HL7 versão 2. Este artigo descreve a taxa de transferência observada para diversas cargas de trabalho e também apresenta diretrizes de configuração geral e dimensionamento para sistemas nos quais a IRIS for Health é usada como um mecanismo de interoperabilidade para as mensagens do HL7v2.

A comparação simula cargas de trabalho parecidas com as de ambientes em produção. Os detalhes da simulação são descritos na seção Descrição e metodologia das cargas de trabalho. As cargas de trabalho testadas consistiram de cargas de Patient Administration (ADT) e Observation Result (ORU) do HL7v2 e incluíram transformações e novo roteamento.

A versão 2020.1 da IRIS for Health demonstrou uma taxa de transferência sustentada de mais de 2,3 bilhões de mensagens (entrada e saída) por dia com um servidor simples com processadores escaláveis Intel® Xeon® de 2ª geração e armazenamento Intel® Optane™ SSD DC P4800X Series. Os resultados mais que dobraram a escalabilidade em relação à comparação de taxa de transferência anterior do Ensemble 2017.1 HL7v2.

Durante os testes, a IRIS for Health foi configurada para preservar a ordem PEPS (primeiro a entrar, primeiro a sair) e para fazer a persistência completa das mensagens e filas para cada mensagem de entrada e saída. Ao fazer a persistência das filas e mensagens, a IRIS for Health proporciona proteção dos dados caso haja travamento do sistema, além de recursos completos de procura e reenvio de mensagens passadas.

Além disso, as diretrizes de configuração são abordadas nas seções abaixo, que ajudarão a escolher uma configuração e implantação adequadas para atender às exigências de desempenho e escalabilidade de suas cargas de trabalho.

Os resultados mostram que a IRIS for Health consegue atender a altíssimas taxas de transferência de mensagens em hardware de prateleira e, na maioria dos casos, permite que um único servidor pequeno forneça interoperabilidade de HL7 para toda a organização.

* * *

## Visão geral dos resultados

Foram usadas três cargas de trabalho para representar diferentes aspectos da atividade de interoperabilidade do HL7:

* **Carga de trabalho T1:** usa passagem simples de mensagens HL7, com uma mensagem de saída para cada mensagem de entrada. As mensagens são passadas diretamente do serviço empresarial do Ensemble (Ensemble Business Service) para a operação de negócios do Ensemble (Ensemble Business Operation), sem um mecanismo de roteamento. Nenhuma regra de roteamento foi usada, e nenhuma transformação foi executada. Foi criada uma instância de mensagens HL7 no banco de dados por mensagem de entrada.

* **Carga de trabalho T2:** usa um mecanismo de roteamento para alterar uma média de 4 segmentos da mensagem de entrada e roteá-la para uma única interface de saída (1 para 1 com uma transformação). Para cada mensagem de entrada, foi executada uma transformação de dados, e foram criados dois objetos de mensagem HL7 no banco de dados.

* **Carga de trabalho T4:** usa um mecanismo de roteamento para rotear separadamente mensagens modificadas para cada uma das quatro interfaces de saída. Em média, 4 segmentos da mensagem de entrada foram modificadas em cada transformação (1 entrada para 4 saídas com 4 transformações). Para cada mensagem de entrada, foram executadas quatro transformações de dados, foram enviadas quatro mensagens de saída, e foram criados cinco objetos de mensagem HL7 no banco de dados.

As três cargas de trabalha foram executadas em um sistema físico de 48 núcleos com dois processadores escaláveis Intel® Xeon® Gold 6252, com das unidades Intel® Optane™ SSD DC P4800X de 750 GB, com o Red Hat Enterprise Linux 8. Os dados são apresentados como o número de mensagens por segundo (e por hora) de entrada, o número por segundo (e por hora) de saída, bem como o total de mensagens (de entrada e de saída) em 10 horas por dia. Além disso, o uso de CPU é apresentado como medida dos recursos de sistema disponíveis para determinado nível de taxa de transferência.

### Resultados de escalabilidade

_Tabela 1: Resumo da taxa de transferência das quatro cargas de trabalho nesta configuração de hardware testada: _

*Carga de trabalho combinada, com 25% de T1, 25% de T2 e 50% de T4

* * *

## Descrição e metodologia das cargas de trabalho

As cargas de trabalho testadas incluíram mensagens de Patient Administration (ADT) e Observation Result (ORU) do HL7v2, com um tamanho médio de 1,2 KB e uma média de 14 segmentos. Cerca de 4 segmentos foram modificados pelas transformações (para cargas de trabalho T2 e T4). Os testes representam 48 a 128 interfaces de entrada de 48 a 128 interfaces de saída enviando e recebendo mensagens por TCP/IP.

Na carga de trabalho T1, foram usados quatro namespaces separados, cada um com 16 interfaces; na carga de trabalho T2, foram usados três namespaces, cada um com 16 interfaces; na carga de trabalho T4, foram usados quatro namespaces, cada um com 32 interfaces; e, na última "carga de trabalho combinada", foram usados três namespaces, com 16 interfaces para carga de trabalho T1, 16 para carga de trabalho T2 e 32 para carga de trabalho T4.

A escalabilidade foi mensurada aumentando-se gradualmente o tráfego em cada interface para descobrir a taxa de transferência mais alta com critérios de desempenho aceitável. Para que o desempenho seja aceitável, as mensagens devem ser processadas a uma taxa sustentada, sem filas, sem atrasos mensuráveis na entrada das mensagens, e o uso médio de CPU deve ficar abaixo de 80%.

Testes anteriores demonstraram que o tipo de mensagem HL7 usado não é significativo para o desempenho e a escalabilidade do Ensemble. Os fatores significativos são o número de mensagens de entrada, o tamanho das mensagens de entrada e saída, o número de novas mensagens criadas no mecanismo de roteamento e o número de segmentos modificados.

Além disso, testes anteriores demonstraram que o processamento de campos específicos de uma mensagem HL7 em uma transformação de dados não costuma impactar o desempenho de forma significativa. As transformações feitas nesses testes usaram atribuições bem simples para criar novas mensagens. É importante salientar que processamentos complexos (como o uso de consultas SQL extensivas em uma transformação de dados) podem fazer os resultados variarem.

Testes anteriores também indicaram que o processamento de regras não costuma ser significativo. Os conjuntos de regras de roteamento usados nos testes tiveram uma média de 32 regras, e todas eram simples. É importante salientar que conjuntos de regras extremamente grandes ou complexos podem fazer os resultados variarem.

### Hardware

#### Configuração do servidor

Os testes utilizaram um servidor com processadores escaláveis Intel® Xeon® Gold 6252 "_Cascade Lake_" de 2ª geração, com 48 núcleos de 2,1 GHz em um sistema com 2 soquetes, 24 núcleos por soquete com 192 GB de DR4-2933 DRAM e interface de rede Ethernet de 10 Gbits. Foi usado o sistema operacional Red Hat Enterprise Linux Server 8 para esse teste, com a IRIS for Health 2020.1

#### Configuração do disco

É feita a persistência completa no disco das mensagens que passam pela IRIS for Health. Nesse teste, duas unidades Intel® Optane™ SSD DC P4800X de 750 GB internas do sistema foram usadas, dividindo-se os bancos de dados em una unidade e os registros de log em outro. Além disso, para garantir uma comparação real, foi ativado o commit síncrono nos registros de log para forçar a durabilidade dos dados. Para a carga de trabalho T4 descrita anteriormente neste documento, cada mensagem HL7 de entrada gera aproximadamente 50 KB de dados, que podem ser divididos conforme indicado na tabela 2. Os diários de transações geralmente são mantidos na linha por menos tempo que os logs ou dados das mensagens, e isso deve ser levado em conta ao calcular o espaço em disco total necessário.

_Tabela 2: Requisitos de disco por mensagem HL7 de entrada para carga de trabalho T4 _

| Contribuinte | Requisito de dados |

| ------------------------------ | ------------------ |

| Dados do segmento | 4,5 KB |

| Objeto da mensagem HL7 | 2 KB |

| Cabeçalho da mensagem | 1 KB |

| Log de regra de encaminhamento | 0,5 KB |

| Diários de transações | 42 KB |

| Total | 50 KB |

Lembre-se de que a carga de trabalho T4 usa um mecanismo de roteamento para rotear separadamente mensagens modificadas para cada uma das quatro interfaces de saída. Em média, 4 segmentos da mensagem de entrada foram modificadas em cada transformação (1 entrada para 4 saídas com 4 transformações). Para cada mensagem de entrada, foram executadas quatro transformações de dados, foram enviadas quatro mensagens de saída e foram criados cinco objetos de mensagem HL7 no banco de dados.

Ao configurar sistemas para uso em produção, os requisitos reais devem ser calculados considerando-se os volumes de entrada diários, bem como o agendamento de limpeza de mensagens HL7 e a política de retenção de arquivos de registros de logs. Além disso, é necessário configurar no sistema um espaço adequado para registros de log, para evitar que os volumes de disco de registros de log fiquem cheios. Os arquivos de registros de log devem ficar em discos separados fisicamente dos arquivos de banco de dados, tanto por questões de desempenho quanto de confiabilidade.

## Conclusão

A taxa de transferência de mensagens HL7v2 da InterSystems IRIS for Health demonstrada nesses testes ilustra a enorme capacidade de taxa de transferência com uma configuração básica de servidor de prateleira com 2 soquetes para dar suporte a cargas de trabalho de mensagens bastante exigentes de qualquer organização. Além disso, a InterSystems está comprometida a aprimorar constantemente o desempenho e a escalabilidade a cada versão, além de aproveitar os benefícios das tecnologias mais recentes de servidor e nuvem.

O gráfico abaixo apresenta uma visão geral e um comparativo do aumento da taxa de transferência das comparações anteriores do Ensemble 2015.1 e Ensemble 2017.1 com processadores Intel® E5-2600 v3 (_Haswell_) e a comparação do Ensemble 2017.1 com processadores escaláveis Intel® Platinum Series (_Skylake_) de 1ª geração em relação aos resultados mais recentes com os processadores escaláveis Intel® Xeon® Gold Series (_Cascade Lake_) de 2ª geração executando a IRIS for Health 2020.1.

_Gráfico 1: Taxa de transferência de mensagens (em milhões) por 10 horas em um único servidor _

A InterSystems IRIS for Health continua aumentar a taxa de transferência de interoperabilidade a cada versão, além de oferecer flexibilidade quanto aos recursos de conectividade. Como o gráfico acima mostra, a taxa de transferência de mensagens aumentou significativamente e, com cargas de trabalho T2, dobrou em relação a 2017 e mais que triplicou em relação a 2015 na mesma janela de 10 horas e **sustentou mais de 2,3 bilhões** de taxas de mensagens em 24 horas.

Outro indicador importante dos avanços da IRIS for Health é a melhoria da taxa de transferência com cargas mais complexas T2 e T4, que incorporam transformações e regras de roteamento, ao contrário da operação única de passagem da carga de trabalho T1.

A InterSystems está disponível para conversar sobre soluções de acordo com as necessidades de interoperabilidade de sua organização.

Artigo

Guilherme Koerber · Mar. 26, 2021

Se você precisar escrever a Arquitetura de Dados de sua organização e mapear para o IRIS da InterSystems, considere o seguinte Diagrama de Arquitetura de Dados e referências à documentação da íris entre sistemas, consulte:

Mapeamento de arquitetura:

Base de dados SQL: https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=GSQL

Arquivos gerenciados: https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=AFL_mft e https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=SETEDIGuides

Corretor de IoT, Eventos e Sensores: https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=EMQTT

Mensagens: https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=EMQS

NoSQL: https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=GDOCDB

API e Web Services: https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=GREST, https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=GSOAP, https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=AFL_iam e https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=PAGE_interoperability

ETL: https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=SETAdapters, https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=EDTL, https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=EBPL e

Conectores EAI: https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=SETAdapters

Eventos XEP: https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=BJAVXEP, https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=BNETXEP,

Ingestão de Big Data: https://docs.intersystems.com/irislatest/csp/docbook/DocBook.UI.Page.cls?KEY=BSPK

IA: https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=PAGE_text_analytics, https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=APMML, https://docs.intersystems.com/irislatest/csp/docbook/DocBook.UI.Page.cls?KEY=PAGE_python_native, https://www.intersystems.com/br/resources/detail/machine-learning-made-easy-intersystems-integratedml/

Processos: https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=EBPL

Serviço Corporativo: https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=EESB e https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=AFL_iam

Em memória: https://docs.intersystems.com/irislatest/csp/docbook/DocBook.UI.Page.cls?KEY=GSCALE_ecp

Conteúdo: https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=GDOCDB

Textual: https://docs.intersystems.com/irislatest/csp/docbook/DocBook.UI.Page.cls?KEY=AFL_textanalytics

Proteção: https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=SETSecurity, https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=TSQS_Applications, https://docs.intersystems.com/irislatest/csp/docbook/DocBook.UI.Page.cls?KEY=GCDI e https://docs.intersystems.com/irislatest/csp/docbook/DocBook.UI.Page.cls?KEY=GCAS

Inventário: https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=GSA_using_portal e https://docs.intersystems.com/irislatest/csp/docbook/DocBook.UI.Page.cls?KEY=GOBJ_xdata

Privacidade: https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=GCAS_encrypt

Ciclo da vida TI, Cópia de segurança e Restaurar: https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=GSA_using_portal, https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=GCDI_backup

Gerenciamento de acesso: https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=TSQS_Authentication, https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=TSQS_Authorization, https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=TSQS_Applications

Replicação e HA: https://docs.intersystems.com/irislatest/csp/docbook/DocBook.UI.Page.cls?KEY=PAGE_high_availability

Monitoramento: https://docs.intersystems.com/sam/csp/docbook/DocBook.UI.Page.cls?KEY=ASAM e https://docs.intersystems.com/irislatest/csp/docbook/DocBook.UI.Page.cls?KEY=PAGE_monitoring

Operação TI: https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=PAGE_platform_mgmt

Visualization: https://docs.intersystems.com/irislatest/csp/docbook/DocBook.UI.Page.cls?KEY=PAGE_bi

Anúncio

Angelo Bruno Braga · Mar. 29, 2021

Olá Desenvolvedores!

Aqui estão os bônus tecnológicos para o concurso de programação InterSystems: Ferramentas de Desenvolvimento que irão lhe dar pontos extras na votação.

Uso de contêineres Docker - 2 pontos

A aplicação ganha o bônus 'Uso de contêiner Docker' se a mesma utiliza o InterSystems IRIS em um contêiner docker. Aqui você encontra o modelo mais simples para iniciar.

Implantação em Pacote ZPM - 2 pontos

Você ganhará este ponto de bônus se você criar e publicar o pacote ZPM(Gerenciador de Pacotes ObjectScript) para sua aplicação Full-Stack de forma que ele possa ser implantado com o seguinte comando

zpm "install o-nome-de-sua-solução-full-stack"

em um IRIS com o cliente ZPM instalado.

Documentação.Cliente ZPM.

Teste Unitário - 2 pontos

Aplicações que possuírem Teste Unitário para o código ObjectScript na plataforma de dados InterSystems ganhará este bônus.

Aprenda mais sobre Teste Unitário em ObjectScript na Documentação e na Comunidade de Desenvolvedores.

Demonstração Online de seu Projeto - 3 pontosColete 3 pontos de bônus a mais se você se você provisionar seu projeto para a nuvem como uma demonstração online. Você pode utilizar este modelo ou qualquer outra alternativa de implantação. Exemplo. Aprenda mais sobre no webinar de lançamento.

Análise de qualidade de código sem bugs - 2 pontos

Incluir a ação do Github de qualidade de código para controle estático de código e faça com que mostre 0 bugs para o seu código ObjectScript. Aprenda mais em nosso webinar de lançamento.

Artigo na Comunidade de Desenvolvedores - 2 pontos

Poste um artigo na Comunidade de Desenvolvedores que descrevam as funcionalidades de seu projeto. Ganhe 2 pontos para cada artigo publicado. Traduções para diferentes idiomas também valem.

Vídeo no YouTube - 3 pontos

Crie um vídeo no Youtube que demonstre seu produto em ação e ganhe 3 pontos de bônus para cada vídeo.

Esta lista de bônus é sujeita à alterações. Fiquem ligados !

Anúncio

Angelo Bruno Braga · Abr. 19, 2021

Olá Desenvolvedores,

Esta semana é a semana de votação para o Concurso de Programação Intersystems: Ferramentas de Desenvolvimento! Então, é a hora de dar o seu voto para as melhores soluções construídas com a plataforma de dados InterSystems IRIS.

🔥 Você decide: VOTE AQUI 🔥

Como votar e o que tem de novo ?

Todos os funcionários InterSystems employees podem votar tanto na nomeação dos Experts quanto na nomeação da Community.

Qualquer desenvolvedor pode votar em seu aplicativo – votos serão computados tanto na nomeação de Experts quanto da Community automaticamente (de acordo com o nível do Global Masters).

Membros da Comunidade de Desenvolvedores: Você pode selecionar 3 projetos: o 1°, 2° e 3° colocados de acordo com sua avaliação. É assim que funcionam os votos da Comunidade:

Quadro de Classificação da Comunidade:

Condições

Lugar

1°

2°

3°

Se você tiver um artigo publicado na Comunidade de Desenvolvedores e um app publicado no Open Exchange (OEX)

9

6

3

Se você tiver ao menos 1 artigo postado na Comunidade de Desenvolvedores ou 1 um app publicado no Open Exchange (OEX)

6

4

2

Se você tiver feito alguma contribuição válida para a Comunidade de Desenvolvedores (publicado um comentário/pergunta, etc.)

3

2

1

Para a nomeação dos Experts, níveis diferentes de experts poderão atribuir mais "pontos":

Quadro de Classificação dos Experts:

Nível

Colocação

1°

2°

3°

Nível VIP no GM, Moderadores, Gerentes de Produtos InterSystems

15

10

5

Nível Ambassador no Global Masters

12

8

4

Nível Expert no Global Masters

9

6

3

Nível Especialista no Global Masters

6

4

2

Nível Advocate no Global Masters ou Funcionários InterSystems

3

2

1

Assim que irá funcionar: Para aqueles que tem qualquer um dos níveis Experts acima, votos serão computados tanto para a nomeação de Experts quanto para a da Comunidade automaticamente.

Para fazer parte da votação, você precisa:

Logar no Open Exchange – As credenciais da Comunidade de Desenvolvedores funcionarão lá.

Faça qualquer contribuição válida para a Comunidade de Desenvolvedores – responda ou faça perguntas, escreva um artigo, publique um app no Open Exchange – e então, você estará apto a votar. Verifique esta postagem sobre as formas de colaborar com a Comunidade de Desenvolvedores.

Se você mudar de ideia, cancele sua escolha e dê seu voto para outra aplicação – você tem 7 dias para escolher !

Participantes do concurso podem corrigir bugs e desenvolver melhorias nas suas aplicações durente a semana de votação então, não perca a oportunidade !

➡️ Não se esqueçam de verificar as novas regras de votação para o concurso online InterSystems aqui.

Anúncio

Danusa Calixto · Ago. 19, 2022

Olá, membros da comunidade!

Estamos muito orgulhosos de anunciar que nossa comunidade de desenvolvedores InterSystems atingiu alguns marcos ENORMES:

📝 10,000 postagens publicadas

👥 11,000 membros registrados

👁 5,000,000 visualizações (it's five million!)

Gostaríamos de parabenizar você, nossos queridos membros e nós (administradores, gerentes de conteúdo e moderadores) por atingirmos 11 mil membros, 10 mil postagens e 5 milhões 🍋🍋🍋🍋🍋 de visualizações! Estamos muito orgulhosos de fazer parte desse sucesso, que foi criado exclusivamente por e graças a você!

Gostaríamos de agradecer a cada um de vocês por fazer parte do nosso grupo de pessoas que pensam da mesma forma! Obrigado por fazer perguntas e iniciar conversas! Por compartilhar seu conhecimento e seus sucessos! Por nos dar sugestões e nos fazer pensar e assim nos tornarmos melhores e mais úteis para você! Você está mantendo esta comunidade viva e próspera! Estamos muito felizes em tê-lo conosco! ❤️

E por fazer desta ocasião mais festiva...

O canal da Comunidade de Desenvolvedores do Discord alcançou 500 membros! 🎉

The Developer Community Discord channel reached 500 members! 🎉 Ainda temos muito trabalho pela frente nessa direção, mas estamos à altura do desafio. E esperamos que você também se junte a nós para obter informações e ideias ainda mais úteis. Junte-se aqui! >>

Obrigada novamente ! E vamos crescer juntos!

Artigo

Evgeny Shvarov · Out. 6, 2020

Olá, desenvolvedores!

Muitos de vocês publicam suas bibliotecas InterSystems ObjectScript no [Open Exchange](https://openexchange.intersystems.com/) e GitHub.

Mas o que você faz para facilitar o uso e a colaboração do seu projeto por desenvolvedores?

Neste artigo, quero apresentar uma maneira fácil de iniciar e contribuir com qualquer projeto ObjectScript apenas copiando um conjunto padrão de arquivos para o seu repositório.

Vamos lá!

Copie esses arquivos [deste repositório](https://github.com/intersystems-community/objectscript-docker-template) para o seu repositório:

[Dockerfile](https://github.com/intersystems-community/objectscript-docker-template/blob/master/Dockerfile)

[docker-compose.yml](https://github.com/intersystems-community/objectscript-docker-template/blob/master/docker-compose.yml)

[Installer.cls](https://github.com/intersystems-community/objectscript-docker-template/blob/master/Installer.cls)

[iris.script](https://github.com/intersystems-community/objectscript-docker-template/blob/master/iris.script)

[settings.json](https://github.com/intersystems-community/objectscript-docker-template/blob/master/.vscode/settings.json "settings.json"){#9f423fcac90bf80939d78b509e9c2dd2-d165a4a3719c56158cd42a4899e791c99338ce73}

[.dockerignore](https://github.com/intersystems-community/objectscript-docker-template/blob/master/.dockerignore ".dockerignore"){#f7c5b4068637e2def526f9bbc7200c4e-c292b730421792d809e51f096c25eb859f53b637}

[.gitattributes](https://github.com/intersystems-community/objectscript-docker-template/blob/master/.gitattributes ".gitattributes"){#fc723d30b02a4cca7a534518111c1a66-051218936162e5338d54836895e0b651e57973e1}

[.gitignore](https://github.com/intersystems-community/objectscript-docker-template/blob/master/.gitignore ".gitignore"){#a084b794bc0759e7a6b77810e01874f2-e6aff5167df2097c253736b40468e7b21e577eeb}

E você agora possui uma maneira padrão de lançar e colaborar com seu projeto. Abaixo está o longo artigo sobre como e por que isso funciona.

**OBS.:** Neste artigo, consideraremos projetos que podem ser executados no InterSystems IRIS 2019.1 e versões mais recentes.

**Escolhendo o ambiente de lançamento para projetos do InterSystems IRIS**

Normalmente, queremos que um desenvolvedor teste o projeto/biblioteca e tenha certeza de que será um exercício rápido e seguro.

Na minha humilde opinião, a abordagem ideal para lançar qualquer coisa nova de forma rápida e segura é através da utilização do contêiner Docker, que dá ao desenvolvedor uma garantia de que tudo o que ele/ela inicia, importa, compila e calcula é seguro para a máquina host e de que nenhum sistema ou código será destruído ou deteriorado. Se algo der errado, basta parar e remover o contêiner. Se a aplicação ocupa uma quantidade enorme de espaço em disco, você a limpa com o contêiner e seu espaço estará de volta. Se uma aplicação deteriora a configuração do banco de dados, você exclui apenas o contêiner com configuração deteriorada. É assim, simples e seguro.

O contêiner Docker oferece segurança e padronização.

A maneira mais simples de executar o contêiner Docker do InterSystems IRIS é executar uma [imagem do IRIS Community Edition](https://hub.docker.com/_/intersystems-iris-data-platform/plans/222f869e-567c-4928-b572-eb6a29706fbd?tab=instructions):

1. Instale o [Docker desktop](https://www.docker.com/products/docker-desktop)

2. Execute no terminal do sistema operacional o seguinte:

docker run --rm -p 52773:52773 --init --name my-iris store/intersystems/iris-community:2020.1.0.199.0

3. Em seguida, abra o Portal de Administração do IRIS em seu navegador host em:

4. Ou abra uma sessão no terminal:

docker exec -it my-iris iris session IRIS

5. Pare o contêiner IRIS quando não precisar mais dele:

docker stop my-iris

OK! Executamos o IRIS em um contêiner docker. Mas você deseja que um desenvolvedor instale seu código no IRIS e talvez faça algumas configurações. Isso é o que discutiremos a seguir.

**Importando arquivos ObjectScript**

O projeto InterSystems ObjectScript mais simples pode conter um conjunto de arquivos ObjectScript como classes, rotinas, macro e globais. Verifique o artigo sobre nomenclatura e estrutura de pastas proposta.

A questão é: como importar todo esse código para um contêiner IRIS?

Aqui é o momento em que o Dockerfile nos ajuda pois podemos usá-lo para pegar o contêiner IRIS padrão, importar todo o código de um repositório para o IRIS e fazer algumas configurações com o IRIS, se necessário. Precisamos adicionar um Dockerfile no repositório.

Vamos examinar o [Dockerfile](https://github.com/intersystems-community/objectscript-docker-template/blob/master/Dockerfile) do repositório de [modelos ObjectScript](https://github.com/intersystems-community/objectscript-docker-template):

ARG IMAGE=store/intersystems/irishealth:2019.3.0.308.0-community

ARG IMAGE=store/intersystems/iris-community:2019.3.0.309.0

ARG IMAGE=store/intersystems/iris-community:2019.4.0.379.0

ARG IMAGE=store/intersystems/iris-community:2020.1.0.199.0

FROM $IMAGE

USER root

WORKDIR /opt/irisapp

RUN chown ${ISC_PACKAGE_MGRUSER}:${ISC_PACKAGE_IRISGROUP} /opt/irisapp

USER irisowner

COPY Installer.cls .

COPY src src

COPY iris.script /tmp/iris.script # run iris and initial

RUN iris start IRIS \

&& iris session IRIS < /tmp/iris.script

As primeiras linhas ARG definem a variável $IMAGE - que usaremos então em FROM. Isso é adequado para testar/executar o código em diferentes versões do IRIS, trocando-os apenas pelo que é a última linha antes do FROM para alterar a variável $IMAGE.

Aqui temos:

ARG IMAGE=store/intersystems/iris-community:2020.1.0.199.0

FROM $IMAGE

Isso significa que estamos pegando o IRIS 2020 Community Edition versão 199.

Queremos importar o código do repositório - isso significa que precisamos copiar os arquivos de um repositório para um contêiner do docker. As linhas abaixo ajudam a fazer isso:

USER root

WORKDIR /opt/irisapp

RUN chown ${ISC_PACKAGE_MGRUSER}:${ISC_PACKAGE_IRISGROUP} /opt/irisapp

USER irisowner

COPY Installer.cls .

COPY src src

USER root - aqui, mudamos o usuário para root para criar uma pasta e copiar arquivos no docker.

WORKDIR /opt/irisapp - nesta linha configuramos o diretório de trabalho no qual copiaremos os arquivos.

RUN chown ${ISC_PACKAGE_MGRUSER}:${ISC_PACKAGE_IRISGROUP} /opt/irisapp - aqui, damos os direitos ao usuário e grupo irisowner que executam o IRIS.

USER irisowner - trocando usuário de root para irisowner

COPY Installer.cls . - copiando o [Installer.cls](https://github.com/intersystems-community/objectscript-docker-template/blob/master/Installer.cls) para a raiz do workdir. Não esqueça aqui do ponto.

COPY src src - copia os arquivos de origem da [pasta src no repo](https://github.com/intersystems-community/objectscript-docker-template/tree/master/src/) para a pasta src no workdir no docker.

No próximo bloco, executamos o script inicial, onde chamamos o instalador e o código ObjectScript:

COPY iris.script /tmp/iris.script # executar o iris e iniciar

RUN iris start IRIS \

&& iris session IRIS < /tmp/iris.script

COPY iris.script / - copiamos iris.script para o diretório raiz. Ele contém o ObjectScript que desejamos chamar para configurar o contêiner.

RUN iris start IRIS\ - inicia o IRIS

&& iris session IRIS < /tmp/iris.script - inicia o terminal IRIS e insere o ObjectScript inicial nele.

Ótimo! Temos o Dockerfile, que importa arquivos no docker. Mas nos deparamos com outros dois arquivos: installer.cls e iris.script. Vamos examiná-los.

[**Installer.cls**](https://github.com/intersystems-community/objectscript-docker-template/blob/master/Installer.cls)

Class App.Installer

{

XData setup

{

}

ClassMethod setup(ByRef pVars, pLogLevel As %Integer = 3, pInstaller As %Installer.Installer, pLogger As %Installer.AbstractLogger) As %Status [ CodeMode = objectgenerator, Internal ]

{

#; Deixe o documento XGL gerar código para este método.

Quit ##class(%Installer.Manifest).%Generate(%compiledclass, %code, "setup")

}

}

Francamente, não precisamos do Installer.cls para importar arquivos. Isso pode ser feito com uma linha. Mas frequentemente, além de importar o código, precisamos configurar a aplicação CSP, introduzir configurações de segurança, criar bancos de dados e namespaces.

Neste Installer.cls, criamos um novo banco de dados, namespace com o nome IRISAPP e criamos a aplicação /csp/irisapp padrão para este namespace.

Tudo isso realizamos no elemento :

<Namespace Name="${Namespace}" Code="${Namespace}" Data="${Namespace}" Create="yes" Ensemble="no">

<Configuration>

<Database Name="${Namespace}" Dir="/opt/${app}/data" Create="yes" Resource="%DB_${Namespace}"/>

<Import File="${SourceDir}" Flags="ck" Recurse="1"/>

</Configuration>

<CSPApplication Url="/csp/${app}" Directory="${cspdir}${app}" ServeFiles="1" Recurse="1" MatchRoles=":%DB_${Namespace}" AuthenticationMethods="32"

/>

</Namespace>

E importamos todos os arquivos do SourceDir com a tag Import:

<Import File="${SourceDir}" Flags="ck" Recurse="1"/>

SourceDir aqui é uma variável, que é definida para o diretório/pasta src atual:

<Default Name="SourceDir" Value="#{$system.Process.CurrentDirectory()}src"/>

Uma classe Installer.cls com essas configurações nos dá a confiança de que criamos um novo banco de dados IRISAPP limpo, no qual importamos código ObjectScript arbitrário da pasta src.

[iris.script](https://github.com/intersystems-community/objectscript-docker-template/blob/master/iris.script)

Aqui, você é bem-vindo para fornecer qualquer código de configuração ObjectScript inicial que deseja para iniciar seu contêiner IRIS.

Ex. Aqui carregamos e executamos o installer.cls e então criamos o UserPasswords sem expiração, apenas para evitar a primeira solicitação de alteração da senha, pois não precisamos desse prompt para o desenvolvimento.

; run installer to create namespace

do $SYSTEM.OBJ.Load("/opt/irisapp/Installer.cls", "ck")

set sc = ##class(App.Installer).setup() zn "%SYS"

Do ##class(Security.Users).UnExpireUserPasswords("*") ; call your initial methods here

halt

[docker-compose.yml](https://github.com/intersystems-community/objectscript-docker-template/blob/master/docker-compose.yml)

Por que precisamos de docker-compose.yml ? Não poderíamos simplesmente construir e executar a imagem apenas com Dockerfile? Sim, poderíamos. Mas docker-compose.yml simplifica a vida.

Normalmente, docker-compose.yml é usado para iniciar várias imagens docker conectadas a uma rede.

docker-compose.yml também pode ser usado para tornar a inicialização de uma imagem docker mais fácil quando lidamos com muitos parâmetros. Você pode usá-lo para passar parâmetros para o docker, como mapeamento de portas, volumes, parâmetros de conexão VSCode.

version: '3.6'

services:

iris:

build:

context: .

dockerfile: Dockerfile

restart: always

ports:

- 51773

- 52773

- 53773

volumes:

- ~/iris.key:/usr/irissys/mgr/iris.key

- ./:/irisdev/app

Aqui, declaramos o serviço iris, que usa o arquivo docker Dockerfile e expõe as seguintes portas do IRIS: 51773, 52773, 53773. Além disso, este serviço mapeia dois volumes: iris.key do diretório inicial da máquina host para a pasta IRIS onde é esperado, e ele mapeia a pasta raiz do código-fonte para a pasta /irisdev/app.

Docker-compose nos oferece o comando mais curto e unificado para construir e executar a imagem, quaisquer que sejam os parâmetros que você configurar no docker compose.

em qualquer caso, o comando para construir e lançar a imagem é:

$ docker-compose up -d

e para abrir o terminal IRIS:

$ docker-compose exec iris iris session iris

Node: 05a09e256d6b, Instance: IRIS

USER>

Além disso, docker-compose.yml ajuda a configurar a conexão para o plugin VSCode ObjectScript.

[.vscode/settings.json](https://github.com/intersystems-community/objectscript-docker-template/blob/master/.vscode/settings.json)

A parte relacionada às configurações de conexão da extensão ObjectScript é esta:

{

"objectscript.conn" :{

"ns": "IRISAPP",

"active": true,

"docker-compose": {

"service": "iris",

"internalPort": 52773

}

}

}

Aqui vemos as configurações, que são diferentes das configurações padrão do plugin VSCode ObjectScript.

Aqui, dizemos que queremos nos conectar ao namespace IRISAPP (que criamos com Installer.cls):

"ns": "IRISAPP",

e há uma configuração docker-compose, que informa que, no arquivo docker-compose dentro do serviço "iris", o VSCode se conectará à porta, para a qual 52773 está mapeado:

"docker-compose": {

"service": "iris",

"internalPort": 52773

}

Se verificarmos o que temos para 52773, veremos que esta é a porta mapeada não definida para 52773:

ports:

- 51773

- 52773

- 53773

Isso significa que uma porta aleatória disponível em uma máquina host será obtida e o VSCode se conectará a este IRIS no docker via porta aleatória automaticamente.

**Este é um recurso muito útil, pois oferece a opção de executar qualquer quantidade de imagens do docker com IRIS em portas aleatórias e ter VSCode conectado a elas automaticamente.**

E quanto a outros arquivos?

Nos também temos:

[.dockerignore](https://github.com/intersystems-community/objectscript-docker-template/blob/master/.dockerignore) - arquivo que você pode usar para filtrar os arquivos da máquina host que você não deseja que sejam copiados para a imagem docker que você construir. Normalmente .git e .DS_Store são linhas obrigatórias.

[.gitattributes](https://github.com/intersystems-community/objectscript-docker-template/blob/master/.gitattributes) - atributos para git, que unificam terminações de linha para arquivos ObjectScript em fontes. Isso é muito útil se o repositório for colaborado por proprietários de Windows e Mac/Ubuntu.

[.gitignore](https://github.com/intersystems-community/objectscript-docker-template/blob/master/.gitignore) - arquivos, os quais você não deseja que o git rastreie o histórico de alterações. Normalmente, alguns arquivos ocultos no nível do sistema operacional, como .DS_Store.

Ótimo!

Como tornar seu repositório executável em docker e amigável para colaboração?

1. Clone [este repositório](https://github.com/intersystems-community/objectscript-docker-template).

2. Copie todos esses arquivos:

[Dockerfile](https://github.com/intersystems-community/objectscript-docker-template/blob/master/Dockerfile)

[docker-compose.yml](https://github.com/intersystems-community/objectscript-docker-template/blob/master/docker-compose.yml)

[Installer.cls](https://github.com/intersystems-community/objectscript-docker-template/blob/master/Installer.cls)

[iris.script](https://github.com/intersystems-community/objectscript-docker-template/blob/master/iris.script)

[settings.json](https://github.com/intersystems-community/objectscript-docker-template/blob/master/.vscode/settings.json "settings.json"){#9f423fcac90bf80939d78b509e9c2dd2-d165a4a3719c56158cd42a4899e791c99338ce73}

[.dockerignore](https://github.com/intersystems-community/objectscript-docker-template/blob/master/.dockerignore ".dockerignore"){#f7c5b4068637e2def526f9bbc7200c4e-c292b730421792d809e51f096c25eb859f53b637}

[.gitattributes](https://github.com/intersystems-community/objectscript-docker-template/blob/master/.gitattributes ".gitattributes"){#fc723d30b02a4cca7a534518111c1a66-051218936162e5338d54836895e0b651e57973e1}

[.gitignore](https://github.com/intersystems-community/objectscript-docker-template/blob/master/.gitignore ".gitignore"){#a084b794bc0759e7a6b77810e01874f2-e6aff5167df2097c253736b40468e7b21e577eeb}

para o seu repositório.

Altere [esta linha no Dockerfile](https://github.com/intersystems-community/objectscript-docker-template/blob/10f4422c105d5c75111fde16a184a83f5ff86d06/Dockerfile#L15) para corresponder ao diretório com ObjectScript no repositório que você deseja importar para o IRIS (ou não altere se estiver na pasta /src).

É isso. E todos (e você também) terão seu código importado para o IRIS em um novo namespace IRISAPP.

**Como as pessoas irão iniciar o seu projeto**

o algoritmo para executar qualquer projeto ObjectScript no IRIS pode ser:

1. Clone o projeto Git localmente

2. Execute o projeto:

$ docker-compose up -d

$ docker-compose exec iris iris session iris

Node: 05a09e256d6b, Instance: IRIS

USER>zn "IRISAPP"

**Como qualquer desenvolvedor pode contribuir para o seu projeto **

1. Bifurque o repositório e clone o repositório git bifurcado localmente

2. Abra a pasta no VSCode (eles também precisam que as extensões [Docker](https://marketplace.visualstudio.com/items?itemName=ms-azuretools.vscode-docker) e [ObjectScript](https://marketplace.visualstudio.com/items?itemName=daimor.vscode-objectscript&ssr=false#review-details) estejam instaladas no VSCode)

3. Clique com o botão direito em docker-compose.yml->Reiniciar - [VSCode ObjectScript](https://openexchange.intersystems.com/package/VSCode-ObjectScript) irá conectar-se automaticamente e estará pronto para editar/compilar/depurar

4. Commit, Push e Pull as mudanças solicitadas em seu repositório

Aqui está um pequeno gif sobre como isso funciona:

É isso! Viva a programação!

Artigo

Mikhail Khomenko · Nov. 23, 2020

Imagine que você queira ver o que a tecnologia InterSystems pode oferecer em termos de análise de dados. Você estudou a teoria e agora quer um pouco de prática. Felizmente, a InterSystems oferece um projeto que contém alguns bons exemplos: Samples BI. Comece com o arquivo README, pulando qualquer coisa associada ao Docker, e vá direto para a instalação passo a passo. Inicie uma instância virtual, instale o IRIS lá, siga as instruções para instalar o Samples BI e, a seguir, impressione o chefe com belos gráficos e tabelas. Por enquanto, tudo bem.

Inevitavelmente, porém, você precisará fazer alterações.

Acontece que manter uma máquina virtual sozinha tem algumas desvantagens e é melhor mantê-la com um provedor em nuvem. A Amazon parece sólida e você cria uma conta no AWS (gratuita para iniciar), lê que usar a identidade do usuário root para tarefas diárias é ruim e cria um usuário IAM normal com permissões de administrador.

Clicando um pouco, você cria sua própria rede VPC, sub-redes e uma instância virtual EC2, e também adiciona um grupo de segurança para abrir a porta web IRIS (52773) e a porta ssh (22) para você. Repete a instalação do IRIS e Samples BI. Desta vez, usa o script Bash ou Python, se preferir. Mais uma vez, impressiona o chefe.

Mas o movimento DevOps onipresente leva você a começar a ler sobre infraestrutura como código e você deseja implementá-la. Você escolhe o Terraform, já que ele é bem conhecido de todos e sua abordagem é bastante universal - adequada com pequenos ajustes para vários provedores em nuvem. Você descreve a infraestrutura em linguagem HCL e traduz as etapas de instalação do IRIS e Samples BI para o Ansible. Em seguida, você cria mais um usuário IAM para permitir que o Terraform funcione. Executa tudo. Ganha um bônus no trabalho.

Gradualmente, você chega à conclusão de que, em nossa era de [microsserviços](https://martinfowler.com/articles/microservices.html), é uma pena não usar o Docker, especialmente porque a InterSystems lhe diz [como](https://docs.intersystems.com/irislatest/csp/docbook/DocBook.UI.Page.cls?KEY=ADOCK_iris). Você retorna ao guia de instalação do Samples BI e lê as linhas sobre o Docker, que não parecem complicadas:

$ docker pull intersystemsdc/iris-community:2019.4.0.383.0-zpm$ docker run --name irisce -d --publish 52773:52773 intersystemsdc/iris-community:2019.4.0.383.0-zpm$ docker exec -it irisce iris session irisUSER>zpmzpm: USER>install samples-bi

Depois de direcionar seu navegador para ttp://localhost:52773/csp/user/_DeepSee.UserPortal.Home.zen?$NAMESPACE=USER, você vai novamente ao chefe e tira um dia de folga por um bom trabalho.

Você então começa a entender que “docker run” é apenas o começo e você precisa usar pelo menos docker-compose. Não é um problema:

$ cat docker-compose.ymlversion: "3.7"services: irisce: container_name: irisce image: intersystemsdc/iris-community:2019.4.0.383.0-zpm ports: - 52773:52773$ docker rm -f irisce # We don’t need the previous container$ docker-compose up -d

Então, você instala o Docker e o docker-compose com o Ansible e, em seguida, apenas executa o contêiner, que fará o download de uma imagem se ainda não estiver presente na máquina. Em seguida, você instala Samples BI.

Você certamente gosta do Docker, porque é uma interface simples e legal para várias coisas do kernel. Você começa a usar o Docker em outro lugar e geralmente inicia mais de um contêiner. E descobre que muitas vezes os contêineres devem se comunicar entre si, o que leva à leitura sobre como gerenciar vários contêineres.

E você chega ao Kubernetes.

Uma opção para mudar rapidamente de docker-compose para Kubernetes é usar o [kompose](https://kompose.io/). Pessoalmente, prefiro simplesmente copiar os manifestos do Kubernetes dos manuais e, em seguida, editá-los, mas o kompose faz um bom trabalho ao concluir sua pequena tarefa:

$ kompose convert -f docker-compose.ymlINFO Kubernetes file "irisce-service.yaml" createdINFO Kubernetes file "irisce-deployment.yaml" created

Agora você tem os arquivos de implantação e serviço que podem ser enviados para algum cluster do Kubernetes. Você descobre que pode instalar um minikube, que permite executar um cluster Kubernetes de nó único e é exatamente o que você precisa neste estágio. Depois de um ou dois dias brincando com a sandbox do minikube, você está pronto para usar uma implantação real e ao vivo do Kubernetes em algum lugar da nuvem AWS.

Preparação

Então, vamos fazer isso juntos. Neste ponto, faremos algumas suposições:

Primeiro, presumimos que você tenha uma conta no AWS, [saiba seu ID](https://docs.aws.amazon.com/IAM/latest/UserGuide/console_account-alias.html) e não use credenciais de root. Você criou um usuário IAM (vamos chamá-lo de “my-user”) com [direitos de administrador](https://docs.aws.amazon.com/IAM/latest/UserGuide/getting-started_create-admin-group.html) e apenas acesso programático e armazenou suas credenciais. Você também criou outro usuário IAM, chamado “terraform”, com as mesmas permissões:

Em seu nome, o Terraform irá para sua conta no AWS e criará e excluirá os recursos necessários. Os amplos direitos de ambos os usuários são explicados pelo fato de que se trata de uma demonstração. Você salva as credenciais localmente para os dois usuários IAM:

$ cat ~/.aws/credentials[terraform]aws_access_key_id = ABCDEFGHIJKLMNOPQRSTaws_secret_access_key = ABCDEFGHIJKLMNOPQRSTUVWXYZ01234567890123[my-user]aws_access_key_id = TSRQPONMLKJIHGFEDCBAaws_secret_access_key = TSRQPONMLKJIHGFEDCBA01234567890123

Observação: não copie e cole as credenciais acima. Eles são fornecidos aqui como um exemplo e não existem mais. Edite o arquivo ~/.aws/credentials e introduza seus próprios registros.

Em segundo lugar, usaremos o ID do conta AWS fictícia (01234567890) para o artigo e a região AWS “eu-west-1.” Sinta-se à vontade para usar outra região.

Terceiro, presumimos que você esteja ciente de que o AWS não é gratuito e que você terá que pagar pelos recursos usados.

Em seguida, você instalou o utilitário AWS CLI para comunicação via linha de comando com o AWS. Você pode tentar usar o aws2, mas precisará definir especificamente o uso do aws2 em seu arquivo de configuração do kube, conforme descrito aqui.

Você também instalou o utilitário kubectl para comunicação via linha de comando com AWS Kubernetes.

E você instalou o utilitário kompose para docker-compose.yml para converter manifestos do Kubernetes.

Finalmente, você criou um repositório GitHub vazio e clonou-o em seu host. Vamos nos referir ao seu diretório raiz como . Neste repositório, vamos criar e preencher três diretórios: .github/workflows/, k8s/, e terraform/.

Observe que todo o código relevante é duplicado no repositório github-eks-samples-bi para simplificar a cópia e a colagem.

Vamos continuar.

Provisionamento AWS EKS

Já conhecemos o EKS no artigo Implementando uma aplicação web simples baseado em IRIS usando o Amazon EKS. Naquela época, criamos um cluster semiautomático. Ou seja, descrevemos o cluster em um arquivo e, em seguida, iniciamos manualmente o utilitário eksctl de uma máquina local, que criou o cluster de acordo com nossa descrição.

O eksctl foi desenvolvido para a criação de clusters EKS e é bom para uma implementação de prova de conceito, mas para o uso diário é melhor usar algo mais universal, como o Terraform. Um ótimo recurso, Introdução ao AWS EKS, explica a configuração do Terraform necessária para criar um cluster EKS. Uma ou duas horas gastas para conhecê-lo não será uma perda de tempo.

Você pode brincar com o Terraform localmente. Para fazer isso, você precisará de um binário (usaremos a versão mais recente para Linux no momento da redação do artigo, 0.12.20) e o usuário IAM “terraform” com direitos suficientes para o Terraform ir para o AWS. Crie o diretório /terraform/ para armazenar o código do Terraform:

$ mkdir /terraform$ cd /terraform

Você pode criar um ou mais arquivos .tf (eles são mesclados na inicialização). Basta copiar e colar os exemplos de código da Introdução ao AWS EKS e, em seguida, executar algo como:

$ export AWS_PROFILE=terraform$ export AWS_REGION=eu-west-1$ terraform init$ terraform plan -out eks.plan

Você pode encontrar alguns erros. Nesse caso, brinque um pouco com o modo de depuração, mas lembre-se de desligá-lo mais tarde:

$ export TF_LOG=debug$ terraform plan -out eks.plan$ unset TF_LOG

Esta experiência será útil, e muito provavelmente você terá um cluster EKS iniciado (use “terraform apply” para isso). Verifique no console do AWS:

Limpe-o quando você ficar entediado:

$ terraform destroy

Em seguida, vá para o próximo nível e comece a usar o módulo Terraform EKS, especialmente porque ele é baseado na mesma introdução ao EKS. No diretório examples/ você verá como usá-lo. Você também encontrará outros exemplos lá.

Simplificamos um pouco os exemplos. Este é o arquivo principal em que os módulos de criação de VPC e de criação de EKS são chamados:

$ cat /terraform/main.tfterraform { required_version = ">= 0.12.0" backend "s3" { bucket = "eks-github-actions-terraform" key = "terraform-dev.tfstate" region = "eu-west-1" dynamodb_table = "eks-github-actions-terraform-lock" }}

provider "kubernetes" { host = data.aws_eks_cluster.cluster.endpoint cluster_ca_certificate = base64decode(data.aws_eks_cluster.cluster.certificate_authority.0.data) token = data.aws_eks_cluster_auth.cluster.token load_config_file = false version = "1.10.0"}

locals { vpc_name = "dev-vpc" vpc_cidr = "10.42.0.0/16" private_subnets = ["10.42.1.0/24", "10.42.2.0/24"] public_subnets = ["10.42.11.0/24", "10.42.12.0/24"] cluster_name = "dev-cluster" cluster_version = "1.14" worker_group_name = "worker-group-1" instance_type = "t2.medium" asg_desired_capacity = 1}

data "aws_eks_cluster" "cluster" { name = module.eks.cluster_id}

data "aws_eks_cluster_auth" "cluster" { name = module.eks.cluster_id}

data "aws_availability_zones" "available" {}

module "vpc" { source = "git::https://github.com/terraform-aws-modules/terraform-aws-vpc?ref=master"

name = local.vpc_name cidr = local.vpc_cidr azs = data.aws_availability_zones.available.names private_subnets = local.private_subnets public_subnets = local.public_subnets enable_nat_gateway = true single_nat_gateway = true enable_dns_hostnames = true

tags = { "kubernetes.io/cluster/${local.cluster_name}" = "shared" }

public_subnet_tags = { "kubernetes.io/cluster/${local.cluster_name}" = "shared" "kubernetes.io/role/elb" = "1" }

private_subnet_tags = { "kubernetes.io/cluster/${local.cluster_name}" = "shared" "kubernetes.io/role/internal-elb" = "1" }}

module "eks" { source = "git::https://github.com/terraform-aws-modules/terraform-aws-eks?ref=master" cluster_name = local.cluster_name cluster_version = local.cluster_version vpc_id = module.vpc.vpc_id subnets = module.vpc.private_subnets write_kubeconfig = false

worker_groups = [ { name = local.worker_group_name instance_type = local.instance_type asg_desired_capacity = local.asg_desired_capacity } ]

map_accounts = var.map_accounts map_roles = var.map_roles map_users = var.map_users}

Vejamos um pouco mais de perto o bloco "_terraform_" em main.tf:

terraform { required_version = ">= 0.12.0" backend "s3" { bucket = "eks-github-actions-terraform" key = "terraform-dev.tfstate" region = "eu-west-1" dynamodb_table = "eks-github-actions-terraform-lock" }}

Aqui, indicamos que seguiremos a sintaxe não inferior ao Terraform 0.12 (muito mudou em comparação com as versões anteriores) e também que Terraform não deve armazenar seu estado localmente, mas sim remotamente, no S3 bucket.

É conveniente se o código do terraform possa ser atualizado de lugares diferentes por pessoas diferentes, o que significa que precisamos ser capazes de bloquear o estado de um usuário, então adicionamos um bloqueio usando uma tabela dynamodb. Leia mais sobre bloqueios na página State Locking (bloqueio de estado).

Como o nome do bucket deve ser único em toda o AWS, o nome “eks-github-actions-terraform” não funcionará para você. Pense por conta própria e certifique-se de que ele ainda não foi usado (se sim, você receberá um erro NoSuchBucket):

$ aws s3 ls s3://my-bucketAn error occurred (AllAccessDisabled) when calling the ListObjectsV2 operation: All access to this object has been disabled$ aws s3 ls s3://my-bucket-with-name-that-impossible-to-rememberAn error occurred (NoSuchBucket) when calling the ListObjectsV2 operation: The specified bucket does not exist

Tendo criado um nome, crie o bucket (usamos o usuário IAM “terraform” aqui. Ele tem direitos de administrador para que possa criar um bucket) e habilite o controle de versão para ele (o que lhe salvará em caso de um erro de configuração):

$ aws s3 mb s3://eks-github-actions-terraform --region eu-west-1make_bucket: eks-github-actions-terraform$ aws s3api put-bucket-versioning --bucket eks-github-actions-terraform --versioning-configuration Status=Enabled$ aws s3api get-bucket-versioning --bucket eks-github-actions-terraform{ "Status": "Enabled"}

Com o DynamoDB, ser único não é necessário, mas você precisa criar uma tabela primeiro:

$ aws dynamodb create-table \ --region eu-west-1 \ --table-name eks-github-actions-terraform-lock \ --attribute-definitions AttributeName=LockID,AttributeType=S \ --key-schema AttributeName=LockID,KeyType=HASH \ --provisioned-throughput ReadCapacityUnits=5,WriteCapacityUnits=5

Lembre-se de que, em caso de falha do Terraform, você pode precisar remover um bloqueio manualmente do console AWS. Mas tenha cuidado ao fazer isso.

Com relação aos blocos do módulo eks/vpc em main.tf, a forma de referenciar o módulo disponível no GitHub é simples:

git::https://github.com/terraform-aws-modules/terraform-aws-vpc?ref=master

Agora vamos dar uma olhada em nossos outros dois arquivos Terraform (variables.tf e outputs.tf). O primeiro contém nossas variáveis Terraform:

$ cat /terraform/variables.tfvariable "region" { default = "eu-west-1"}

variable "map_accounts" { description = "Additional AWS account numbers to add to the aws-auth configmap. See examples/basic/variables.tf for example format." type = list(string) default = []}

variable "map_roles" { description = "Additional IAM roles to add to the aws-auth configmap." type = list(object({ rolearn = string username = string groups = list(string) })) default = []}

variable "map_users" { description = "Additional IAM users to add to the aws-auth configmap." type = list(object({ userarn = string username = string groups = list(string) })) default = [ { userarn = "arn:aws:iam::01234567890:user/my-user" username = "my-user" groups = ["system:masters"] } ]}

A parte mais importante aqui é adicionar o usuário IAM “my-user” à variável map_users, mas você deve usar seu próprio ID de conta aqui no lugar de 01234567890.

O que isto faz? Quando você se comunica com o EKS por meio do cliente kubectl local, ele envia solicitações ao servidor da API Kubernetes, e cada solicitação passa por processos de autenticação e autorização para que o Kubernetes possa entender quem enviou a solicitação e o que elas podem fazer. Portanto, a versão EKS do Kubernetes pede ajuda ao AWS IAM com a autenticação do usuário. Se o usuário que enviou a solicitação estiver listado no AWS IAM (apontamos seu ARN aqui), a solicitação vai para a fase de autorização, que o EKS processa sozinho, mas de acordo com nossas configurações. Aqui, indicamos que o usuário IAM “my-user” é muito legal (grupo “system: masters”).

Por fim, o arquivo outputs.tf descreve o que o Terraform deve imprimir após concluir um job:

$ cat /terraform/outputs.tfoutput "cluster_endpoint" { description = "Endpoint for EKS control plane." value = module.eks.cluster_endpoint}

output "cluster_security_group_id" { description = "Security group ids attached to the cluster control plane." value = module.eks.cluster_security_group_id}

output "config_map_aws_auth" { description = "A kubernetes configuration to authenticate to this EKS cluster." value = module.eks.config_map_aws_auth}

Isso completa a descrição da parte do Terraform. Voltaremos em breve para ver como vamos iniciar esses arquivos.

Manifestos Kubernetes

Até agora, cuidamos de onde iniciar a aplicação. Agora vamos ver o que executar.

Lembre-se de que temos o docker-compose.yml (renomeamos o serviço e adicionamos alguns rótulos que o kompose usará em breve) no diretório /k8s/:

$ cat /k8s/docker-compose.ymlversion: "3.7"services: samples-bi: container_name: samples-bi image: intersystemsdc/iris-community:2019.4.0.383.0-zpm ports: - 52773:52773 labels: kompose.service.type: loadbalancer kompose.image-pull-policy: IfNotPresent

Execute o kompose e adicione o que está destacado abaixo. Exclua as anotações (para tornar as coisas mais inteligíveis):

$ kompose convert -f docker-compose.yml --replicas=1$ cat /k8s/samples-bi-deployment.yamlapiVersion: extensions/v1beta1kind: Deploymentmetadata: labels: io.kompose.service: samples-bi name: samples-bispec: replicas: 1 strategy: type: Recreate template: metadata: labels: io.kompose.service: samples-bi spec: containers: - image: intersystemsdc/iris-community:2019.4.0.383.0-zpm imagePullPolicy: IfNotPresent name: samples-bi ports: - containerPort: 52773 resources: {} lifecycle: postStart: exec: command: - /bin/bash - -c - | echo -e "write\nhalt" > test until iris session iris < test; do sleep 1; done echo -e "zpm\ninstall samples-bi\nquit\nhalt" > samples_bi_install iris session iris < samples_bi_install rm test samples_bi_install restartPolicy: Always

Usamos a estratégia de atualização de Recriar, o que significa que o pod será excluído primeiro e depois recriado. Isso é permitido para fins de demonstração e nos permite usar menos recursos.

Também adicionamos o postStart hook, que será disparado imediatamente após o início do pod. Esperamos até o IRIS iniciar e instalar o pacote samples-bi do repositório zpm padrão.

Agora adicionamos o serviço Kubernetes (também sem anotações):

$ cat /k8s/samples-bi-service.yamlapiVersion: v1kind: Servicemetadata: labels: io.kompose.service: samples-bi name: samples-bispec: ports: - name: "52773" port: 52773 targetPort: 52773 selector: io.kompose.service: samples-bi type: LoadBalancer

Sim, vamos implantar no namespace "padrão", que funcionará para a demonstração.

Ok, agora sabemos _onde_ e _o que_ queremos executar. Resta ver _como_.

O fluxo de trabalho do GitHub Actions

Em vez de fazer tudo do zero, criaremos um fluxo de trabalho semelhante ao descrito em [Implantando uma solução InterSystems IRIS no GKE usando GitHub Actions](https://community.intersystems.com/post/deploying-intersystems-iris-solution-gke-using-github-actions). Desta vez, não precisamos nos preocupar em construir um contêiner. As partes específicas do GKE são substituídas pelas específicas do EKS. As partes em negrito estão relacionadas ao recebimento da mensagem de commit e ao uso dela em etapas condicionais:

$ cat /.github/workflows/workflow.yamlname: Provision EKS cluster and deploy Samples BI thereon: push: branches: - master

# Environment variables.# ${{ secrets }} are taken from GitHub -> Settings -> Secrets# ${{ github.sha }} is the commit hashenv: AWS_ACCESS_KEY_ID: ${{ secrets.AWS_ACCESS_KEY_ID }} AWS_SECRET_ACCESS_KEY: ${{ secrets.AWS_SECRET_ACCESS_KEY }} AWS_REGION: ${{ secrets.AWS_REGION }} CLUSTER_NAME: dev-cluster DEPLOYMENT_NAME: samples-bi

jobs: eks-provisioner: # Inspired by: ## https://www.terraform.io/docs/github-actions/getting-started.html ## https://github.com/hashicorp/terraform-github-actions name: Provision EKS cluster runs-on: ubuntu-18.04 steps: - name: Checkout uses: actions/checkout@v2

- name: Get commit message run: | echo ::set-env name=commit_msg::$(git log --format=%B -n 1 ${{ github.event.after }})

- name: Show commit message run: echo $commit_msg

- name: Terraform init uses: hashicorp/terraform-github-actions@master with: tf_actions_version: 0.12.20 tf_actions_subcommand: 'init' tf_actions_working_dir: 'terraform'

- name: Terraform validate uses: hashicorp/terraform-github-actions@master with: tf_actions_version: 0.12.20 tf_actions_subcommand: 'validate' tf_actions_working_dir: 'terraform'

- name: Terraform plan if: "!contains(env.commit_msg, '[destroy eks]')" uses: hashicorp/terraform-github-actions@master with: tf_actions_version: 0.12.20 tf_actions_subcommand: 'plan' tf_actions_working_dir: 'terraform'

- name: Terraform plan for destroy if: "contains(env.commit_msg, '[destroy eks]')" uses: hashicorp/terraform-github-actions@master with: tf_actions_version: 0.12.20 tf_actions_subcommand: 'plan' args: '-destroy -out=./destroy-plan' tf_actions_working_dir: 'terraform'

- name: Terraform apply if: "!contains(env.commit_msg, '[destroy eks]')" uses: hashicorp/terraform-github-actions@master with: tf_actions_version: 0.12.20 tf_actions_subcommand: 'apply' tf_actions_working_dir: 'terraform'

- name: Terraform apply for destroy if: "contains(env.commit_msg, '[destroy eks]')" uses: hashicorp/terraform-github-actions@master with: tf_actions_version: 0.12.20 tf_actions_subcommand: 'apply' args: './destroy-plan' tf_actions_working_dir: 'terraform'

kubernetes-deploy: name: Deploy Kubernetes manifests to EKS needs: - eks-provisioner runs-on: ubuntu-18.04 steps: - name: Checkout uses: actions/checkout@v2

- name: Get commit message run: | echo ::set-env name=commit_msg::$(git log --format=%B -n 1 ${{ github.event.after }})

- name: Show commit message run: echo $commit_msg

- name: Configure AWS Credentials if: "!contains(env.commit_msg, '[destroy eks]')" uses: aws-actions/configure-aws-credentials@v1 with: aws-access-key-id: ${{ secrets.AWS_ACCESS_KEY_ID }} aws-secret-access-key: ${{ secrets.AWS_SECRET_ACCESS_KEY }} aws-region: ${{ secrets.AWS_REGION }}

- name: Apply Kubernetes manifests if: "!contains(env.commit_msg, '[destroy eks]')" working-directory: ./k8s/ run: | aws eks update-kubeconfig --name ${CLUSTER_NAME} kubectl apply -f samples-bi-service.yaml kubectl apply -f samples-bi-deployment.yaml kubectl rollout status deployment/${DEPLOYMENT_NAME}

É claro que, precisamos definir as credenciais do usuário "terraform" (retirá-las do arquivo ~/.aws/credentials), permitindo que o GitHub use seus segredos:

Observe as partes destacadas do fluxo de trabalho. Elas nos permitirão destruir um cluster EKS empurrando uma mensagem de commit que contém a frase “[destroy eks]”. Observe que não executaremos "kubernetes apply" com essa mensagem de commit.

Execute um pipeline, mas primeiro crie um arquivo .gitignore:

$ cat /.gitignore.DS_Storeterraform/.terraform/terraform/*.planterraform/*.json$ cd $ git add .github/ k8s/ terraform/ .gitignore$ git commit -m "GitHub on EKS"$ git push

Monitore o processo de implantação na aba "Actions" da página do repositório GitHub. Aguarde a conclusão com sucesso.

Quando você executa um fluxo de trabalho pela primeira vez, leva cerca de 15 minutos na etapa “Terraform apply”, aproximadamente o mesmo tempo necessário para criar o cluster. Na próxima inicialização (se você não excluiu o cluster), o fluxo de trabalho será muito mais rápido. Você pode verificar isso:

$ cd $ git commit -m "Trigger" --allow-empty$ git push

É claro que seria bom verificar o que fizemos. Desta vez, você pode usar as credenciais do IAM “my-user” em seu computador:

$ export AWS_PROFILE=my-user$ export AWS_REGION=eu-west-1$ aws sts get-caller-identity$ aws eks update-kubeconfig --region=eu-west-1 --name=dev-cluster --alias=dev-cluster$ kubectl config current-contextdev-cluster

$ kubectl get nodesNAME STATUS ROLES AGE VERSIONip-10-42-1-125.eu-west-1.compute.internal Ready 6m20s v1.14.8-eks-b8860f

$ kubectl get poNAME READY STATUS RESTARTS AGEsamples-bi-756dddffdb-zd9nw 1/1 Running 0 6m16s

$ kubectl get svcNAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGEkubernetes ClusterIP 172.20.0.1 443/TCP 11msamples-bi LoadBalancer 172.20.33.235 a2c6f6733557511eab3c302618b2fae2-622862917.eu-west-1.elb.amazonaws.com 52773:31047/TCP 6m33s

Vá para _[http://a2c6f6733557511eab3c302618b2fae2-622862917.eu-west-1.elb.amazonaws.com:52773/csp/user/_DeepSee.UserPortal.Home.zen?$NAMESPACE=USER](http://a2c6f6733557511eab3c302618b2fae2-622862917.eu-west-1.elb.amazonaws.com:52773/csp/user/_DeepSee.UserPortal.Home.zen?%24NAMESPACE=USER) _(substitua o link pelo seu IP externo), então, digite “_system”, “SYS” e altere a senha padrão. Você deve ver vários painéis de Inteligência Empresarial (BI):

Clique na seta de cada um para um mergulho mais profundo:

Lembre-se, se você reiniciar um pod samples-bi, todas as suas alterações serão perdidas. Este é um comportamento intencional, pois esta é uma demonstração. Se você precisar de persistência, criei um exemplo no repositório github-gke-zpm-registry/k8s/statefulset.tpl.

Quando terminar, basta remover tudo que você criou:

$ git commit -m "Mr Proper [destroy eks]" --allow-empty$ git push

Conclusão

Neste artigo, substituímos o utilitário eksctl pelo Terraform para criar um cluster EKS. É um passo à frente para “codificar” toda a sua infraestrutura AWS.

Mostramos como você pode facilmente implantar uma aplicação de demonstração com git push usando GitHub Actions e Terraform.

Também adicionamos o kompose e um postStart hook de um pod à nossa caixa de ferramentas.

Não mostramos a ativação do TLS neste momento. Essa é uma tarefa que realizaremos em um futuro próximo.

Artigo

Mark Bolinsky · Dez. 14, 2020

O Google Cloud Platform (GCP) fornece um ambiente rico em recursos para Infraestrutura como um Serviço (IaaS) como uma oferta em nuvem totalmente capaz de oferecer suporte a todos os produtos da InterSystems, incluindo a mais recente plataforma de dados InterSystems IRIS . Deve-se ter cuidado, como com qualquer plataforma ou modelo de implantação, para garantir que todos os aspectos de um ambiente sejam considerados, como desempenho, disponibilidade, operações e procedimentos de gerenciamento. As especificidades de cada uma dessas áreas serão abordadas neste artigo.

A visão geral e os detalhes abaixo são fornecidos pelo Google e estão disponíveis aqui.

Visão geral

### Recursos do GCP

O GCP é composto por um conjunto de ativos físicos, como computadores e unidades de disco rígido, e também recursos virtuais, como máquinas virtuais (VMs), nos centros de dados do Google em todo o mundo. Cada centro de dados está em uma região do mundo. Cada região é uma coleção de zonas, isoladas de cada uma dentro da região. Cada zona é identificada por um nome que combina uma letra identificadora com o nome da região.

Essa distribuição de recursos tem várias vantagens, incluindo redundância em caso de falha e latência reduzida colocando recursos mais perto dos clientes. Essa distribuição também tem algumas regras quanto a como os recursos podem ser usados conjuntamente.

### Acesso aos recursos do GCP