Limpar filtro

Artigo

Danusa Calixto · Out. 27, 2022

Digamos que eu esteja desenvolvendo uma aplicação web que usa o IRIS como back-end. Estou trabalhando nela com acesso não autenticado. Está chegando a hora em que eu gostaria de implantar para os usuários, mas preciso adicionar a autenticação primeiro. Em vez de usar a autenticação padrão de senha do IRIS, quero que os usuários façam login com o Login Único (single sign-on - SSO, na sigla em inglês) da minha organização ou outro provedor de identidade popular, como Google ou GitHub. Li que o OpenID Connect é um padrão de autenticação comum e compatível com o IRIS. Qual é a maneira mais simples de colocar isso em funcionamento? ### Exemplo 1: uma app CSP simples A documentação [aqui](https://docs.intersystems.com/irislatest/csp/docbook/DocBook.UI.Page.cls?KEY=GOAUTH_client) apresenta uma opção bastante fácil para usar uma aplicação CSP como um cliente OpenID Connect. Estas são as etapas: 1. Configure o servidor OAuth 2.0 e a configuração do cliente no IRIS. Veja mais informações na seção "Caché configuration" do[excelente artigo do Daniel Kutac](https://community.intersystems.com/post/intersystems-iris-open-authorization-framework-oauth-20-implementation-part-1). 2. Copie a rotina OAUTH2.ZAUTHENTICATE do [repositório de amostras no GitHub](https://github.com/intersystems/Samples-Security/blob/master/rtn/OAUTH2.ZAUTHENTICATE.mac) para o namespace %SYS e renomeie como ZAUTHENTICATE. 3. Ative a autenticação delegada no sistema inteiro. 4. Crie uma página de login personalizada que seja uma extensão de %OAuth2.Login e substitua o método DefineParameters para especificar o nome do aplicativo OAuth 2.0 e os escopos:

Class MyOAuth2.Login Extends %OAuth2.Login

{

ClassMethod DefineParameters(Output application As %String, Output scope As %String, Output responseMode As %String)

{

Set application="my application name"

Set scope="openid profile email"

Set responseMode=..#RESPONSEMODE

Quit

}

}

5. Ative a aplicação web para a autenticação delegada e defina MyOAuth2.Login.cls como a página de login personalizada. 6. Um truque final: para a página de login personalizada funcionar, o usuário CSPSystem no IRIS precisa ter o acesso específico de LEITURA à base de dados em que está MyOAuth2.Login.cls. Neste momento, o login deve "simplesmente funcionar": a visita a uma página CSP nesta aplicação web redirecionará para a página de login no provedor de identidade. Depois de fazer o login, o usuário terá uma sessão CSP autenticada. O $username será igual ao identificador de sujeito do SSO/Google/GitHub/etc., então posso usar a autorização integrada do IRIS para determinar a que dar acesso. ### Exemplo 2: o problema com REST E se a aplicação web estiver usando um manipulador REST? O processo acima não funciona. Se uma aplicação web estiver habilitada para REST, não é possível definir uma página de login personalizada. Descobri que são necessárias mais algumas etapas para contornar isso. 7. Crie uma aplicação web separada sem REST habilitado. O caminho nessa app precisa começar com o caminho do app REST. Por exemplo, se o nome da app REST for "/csp/api", você poderá nomear essa nova app como "/csp/api/login". Ative a autenticação delegada e defina a página MyOAuth2.Login.cls como a página de login personalizada. 8. Defina o Caminho do Cookie da Sessão nessa nova app para o mesmo da app REST: por exemplo, "/csp/api". Assim, ambas as aplicações compartilharão uma sessão CSP. 9. Adicione uma página CSP a essa nova app para servir como uma "página inicial". Um usuário precisa primeiro acessar essa página para estabelecer sua sessão. Veja este exemplo que redireciona para um endpoint na API REST após o login:

Class App.Home Extends %CSP.Page

{

ClassMethod OnPage() As %Status [ ServerOnly = 1 ]

{

&html<<script type="text/javascript"> window.location="/csp/api/test" </script>>

return $$$OK

}

}

10. Certifique-se de que a classe do manipulador REST tenha o parâmetro UseSession substituído por true.

Class API.REST Extends %CSP.REST

{

Parameter UseSession As BOOLEAN = 1;

XData UrlMap [ XMLNamespace = "http://www.intersystems.com/urlmap" ]

{

<Routes>

<Route Url="/test" Method="GET" Call="Test" Cors="true"/>

</Routes>

}

ClassMethod Test() As %Status

{

write { "username": ($username) }.%ToJSON()

return $$$OK

}

}

Nesse ponto, o login na app REST também deverá "simplesmente funcionar". O usuário visitará a página inicial, será redirecionado para o login SSO e, finalmente, retornará a app REST, onde tem uma sessão CSP autenticada. Até onde sei, essa é a maneira mais fácil de adicionar o OpenID Connect a um app IRIS REST. Outra opção é usar a amostra "REST.ZAUTHENTICATE" do repositório de amostras de segurança. Com isso, espera-se que o front-end anexe um bearer token OAuth 2.0 a cada solicitação. No entanto, não há uma forma definida para o front-end obter esse token de acesso. Você terá que implementar esse fluxo OAuth por conta própria em JavaScript (ou usar uma biblioteca como [angular-oauth2-oidc](https://github.com/manfredsteyer/angular-oauth2-oidc).) Você também precisará se certificar de que o app JavaScript e o back-end IRIS estejam de acordo em todos os itens de configuração, como o endpoint do emissor do servidor de autorização, o ID do cliente OAuth 2.0 etc. Descobri que essa não é uma tarefa simples. Tenho curiosidade para saber se mais alguém está usando o OpenID Connect para autenticar uma app IRIS. Há uma maneira ainda mais simples? Ou vale a pena usar a abordagem mais complicada com bearer tokens? Comente aqui embaixo.

Anúncio

Rochael Ribeiro · Jun. 6, 2022

Bem vindos aos Lançamentos de Maio de 2022 da Comunidade de Desenvolvedores!

Disponibilizamos algumas melhorias para aprimorar sua experiência recentemente na Comunidade InterSystems:

🆕 Rastreamento aprimorado dos eventos atuais

🆕 Postagem agendada

🆕 Formatação de código aprimorada

🆕 Criação de tabelas mais rápida

🆕 Experiência de resposta enriquecida

🆕 Alterado a prévia de design de postagens

Vamos dar uma olhada mais próxima em todos os detalhes.

AO VIVO AGORA para Eventos

Para tornar os eventos atuais mais fáceis e convenientes de se localizar adicionamos uma nova seção AO VIVO AGORA no canto superior esquerdo da página.

E se você clicar nele, será redirecionado para a página do evento, onde você pode se juntar ao evento (se for online, claro)

Para tirar vantagem do uso desta funcionalidade, seus anúncios de eventos devem atender as seguintes condições:

Crie seu evento normalmente [adicione a tag Eventos -> campos especiais aparecerão automaticamente]

Verifique se seu evento possui horários de início e fim específicos (eventos de dia todo não são tratados nesta seção)

Para permitir que pessoas se juntem ao seu evento online diretamente, adicione a opção Link direto para participar

É isso, pronto para publicar!

Agende sua postagem

Você pediu e nós fizemos! Agora você pode agendar sua postagem para que seja publicada em um horário específico.

Para agendar sua postagem para mais tarde, você precisa apenas clicar na seta para baixo, próxima ao botão Publicar, e escolher Agendar postagem.

Depois, você poderá escolher a data e horário de quando sua postagem será publicada.

Escolhido o horário, clique no botão Agendar postagem. Sua postagem será publicada no horário escolhido - é isso!

Formatação de Código

Para compartilhar seu código com outros, adicionamos um editor embutido para quando ocorrer a inserção de códigos.

In it, you can select the appropriate programming language and tab size.

Assim, o destaque da sintaxe ocorre imediatamente ao se escrever o texto e a linguagem de programação é exibida no canto superior esquerdo.

Como resultado, na sua postagem, você terá um bonito código formatado, na linguagem de programação selecionada.

Criação de Tabelas

Para facilitar a formatação no momento da criação de tabelas, adicionamos uma função para rapidamente criar uma tabela, através da seleção do número desejado de células.

Se você clicar no botão Mais em baixo, será aberta a funcionalidade padrão de criação de tabelas.

Respostas e assinaturas

Para visualizar todas as informações sobre a discussão rapidamente, adicionamos o número de respostas no topo do editor e também um ícone para assinar uma discussão e assim, postar uma nova resposta.

Design da Prévia da Postagem

Para tornar a parte de baixo da postagem mais balanceada, rearranjamos e alteramos os ícones.

Aproveitem as atualizações!

Enviem-nos suas requisições por melhorias e notificações de problemas no GitHub da Comunidade de Desenvolvedores. Ou poste suas sugestões nos comentários desta postagem.

Nos vemos em breve com mais mudanças interessantes!

Artigo

Danusa Calixto · Nov. 4, 2022

O ZPM foi projetado para trabalhar com aplicativos e módulos para a plataforma de dados IRIS da InterSystems. Ele consiste em dois componentes, o ZPN Client que é uma CLI para gerenciar módulos, e o The Registry que é um banco de dados de módulos e meta-informações. Podemos usar o ZPM para pesquisar, instalar, atualizar, remover e publicar módulos. Com o ZPM, você pode instalar classes ObjectScript, aplicativos Frontend, produções de interoperabilidade, soluções IRIS BI, conjuntos de dados IRIS ou quaisquer arquivos como rodas Python incorporadas.

Hoje este livro de receitas passará por 3 seções:

Instalar ZPM

Gerar Módulo

Encontre, instale, publique módulos dentro do Registro

1. Instale o ZPM

Baixe a versão mais recente do ZPM (este deve ser um único arquivo XML) Link para Download

Importe o XML que você baixou para o IRIS e ele só pode ser implantado no terminal IRIS, abra o IRIS e insira

write $SYSTEM.OBJ.Load("C:\zpm.xml", "c")

Observação "C:\zpm.xml" é o caminho do arquivo XML baixado, esta etapa pode demorar um pouco.

Após terminar a instalação, basta digitar zpm, pressionar enter, você verá que está no shell zpm

2. Gerar Módulo

Antes de começarmos a gerar o módulo, precisamos preparar uma pasta que tenha um ou mais arquivos prontos para carregar, por isso criei uma pasta na unidade C chamada zpm.

Execute o comando generate C:/zpm

Depois de especificar todo o necessário, seu primeiro módulo foi gerado com sucesso, você também verá

Observação:

a versão do módulo está usando versionamento semântico

pasta de origem do módulo é a pasta que tem todo o arquivo de classe

zpm também oferece uma opção para adicionar aplicativos web e dependência, neste exemplo vou deixar em branco

Agora, abra o explorador de arquivos, você verá um arquivo chamado "module.xml" como você pode verificar na captura de tela abaixo

Digite command load C:\ZPM\ você verá que seu módulo foi recarregado, validado, compilado e ativado

3. Encontre, instale, publique módulos dentro do Registro

Encontre pacotes disponíveis no Registro atual: zpm:USER>search

Instalar o pacote do registro atual como exemplo permite instalar um módulo chamado zpmshow no registro público: zpm:USER>install zpmshow (o comando é install "moduleName")

Publicar módulo depois de carregado: zpm:USER>publish myFirstZPMDemo

Você pode usar zpm:USER>search para verificar a publicação, no meu caso você pode ver que "myfirstzpmdemo 0.1.0" está no Registro atual.

Nota: Se ocorrer um erro ao publicar um módulo que diz: "ERRO! Publicando módulo, algo deu errado", certifique-se de que o status do Registro atual esteja habilitado e disponível.

Você pode usar zpm:USER>repo -list, para verificar o status do registro atual.

Video disponível: Clique aqui

Artigo

Edilson Eberle Carvalho · Jun. 8, 2023

Incrível esse legado! Esse é um dos motivos principais do sucesso da Intersystems.

Fiz um teste simples essa semana e não é que deu certo? Qual linguagem tem essa capacidade? Qual banco de dados pode-se ter Globais e Tabelas SQL? Isso sem falar na velocidade! Será covardia o BachMark entre MS-SQL e Caché. Qual o sistema que vc pode instalar em seu notebook e apresentar resultados como se estivesse em um Servidor?

Apresentei para meus alunos, e eles ficaram fascinados com facilidade de programação, criação imediata de variáveis, globais, linha de código, etc. Como um aluno me disse: "O bagulho é loko"....rs

O programa abaixo valida CNPJ e CPF, naquela época era CGC rs....

CGC(%CGC) ;PROGRAMA DE VALIDAÇÃO CGC/CPF

; ENTRADA ==> %CGC (CGC/CPF NUMERICO)

; SAIDA ==> VVALUE (CGC/CPF C/PONTUACAO) // PP9 (1-INVALIDO, 0-S/ERRO)

N (VVALUE,PP9,%CGC) Q:%CGC="" %CGC

S %G="" F %I=1:1:$L(%CGC) S:$E(%CGC,%I)?1N %G=%G_$E(%CGC,%I)

S %CGC=%G I $L(%CGC)<14 G CPF

S VVALUE=$E(%CGC,1,2)_"."_$E(%CGC,3,5)_"."_$E(%CGC,6,8)_"/"_$E(%CGC,9,12)_"-"_$E(%CGC,13,14),%CT=$L(%CGC),%N=$E(%CGC,1,%CT-2),%DG=$E(%CGC,%CT-1,%CT),%DI="",PP9=0 D CGC1 S %N=%N_%DC,%CT=%CT+1 D CGC1 S:%DG'=%DI PP9=1

K %N,%D,%DG,%CGC,%CT,%S,%P,%DC,%CTN,%I Q VVALUE

CGC1 S %S=0,%P=2,%CTN=$L(%N) F %I=%CTN:-1:1 S %D=$E(%N,%I),%S=%P*%D+%S,%P=%P+1 S:%P>9 %P=2

S %DC=%S#11*-1+11 S:%DC>9 %DC=0 S %DI=%DI_%DC Q

CPF S VVALUE=$E(%CGC,1,3)_"."_$E(%CGC,4,6)_"."_$E(%CGC,7,9)_"-"_$E(%CGC,10,11),%CT=$L(%CGC),%N=$E(%CGC,1,%CT-2),%DG=$E(%CGC,%CT-1,%CT),%DI="",PP9=0 D CGC2 S %N=%N_%DC,%CT=%CT+1 D CGC2 S:%DG'=%DI PP9=1

K %N,%D,%DG,%CGC,%CT,%S,%P,%DC,%CTN,%I Q VVALUE

CGC2 S %S=0,%P=2,%CTN=$L(%N) F %I=%CTN:-1:1 S %D=$E(%N,%I),%S=%P*%D+%S,%P=%P+1

S %DC=%S#11*-1+11 S:%DC>9 %DC=0 S %DI=%DI_%DC Q

Artigo

Heloisa Paiva · Abr. 18

Sou um grande fã de ficção científica, mas embora eu esteja totalmente a bordo da nave Star Wars (desculpas aos meus colegas Trekkies!), sempre apreciei os episódios clássicos de Star Trek da minha infância.

A tripulação diversificada da USS Enterprise, cada um dominando suas funções únicas, é uma metáfora perfeita para entender os agentes de IA e seu poder em projetos como o Facilis.

Então, vamos embarcar em uma missão intergaláctica, utilizando a IA como a tripulação da nossa nave e ***audaciosamente ir*** audaciosamente ir ***homem jamais esteve***!

Esse conceito de trabalho em equipe é uma analogia maravilhosa para ilustrar como os agentes de IA funcionam e como os usamos em nosso projeto DC-Facilis. Então, vamos mergulhar e assumir o papel de um capitão de nave estelar, liderando uma tripulação de IA em territórios inexplorados!

## Bem-vindo ao CrewAI!

Para gerenciar nossa tripulação de IA, usamos uma estrutura fantástica chamada [CrewAI](https://www.crewai.com/).É enxuta, extremamente rápida e opera como uma plataforma Python multiagente. Uma das razões pelas quais a amamos, além do fato de ter sido criada por outro brasileiro, é sua incrível flexibilidade e design baseado em funções.

```python

from crewai import Agent, Task, Crew

```

### Conheça os Planejadores

No Facilis, nossos agentes de IA são divididos em dois grupos. Vamos começar com o primeiro, que gosto de chamar de "Os Planejadores".

### O Agente de Extração

O papel principal do Facilis é receber uma descrição em linguagem natural de um serviço REST e criar automaticamente toda a interoperabilidade necessária. Portanto, nosso primeiro membro da tripulação é o Agente de Extração. Este agente tem a tarefa de "extrair" as especificações da API a partir da descrição fornecida pelo usuário.

Aqui está o que o Agente de Extração procura:

- Host (obrigatório)

- Endpoint (obrigatório)

- Params (opcional)

- Port (se disponível)

- modelo JSON (para POST/PUT/PATCH/DELETE)

- Autenticação (se aplicável)

```python

def create_extraction_agent(self) -> Agent:

return Agent(

role='Extrator de Especificações de API',

goal='Extrair especificações de API de descrições em linguagem natural',

backstory=dedent("""

Você é especializado em interpretar descrições em linguagem natural

e extrair especificações de API estruturadas.

"""),

allow_delegation=True,

llm=self.llm

)

def extract_api_specs(self, descriptions: List[str]) -> Task:

return Task(

description=dedent(f"""

Extraia as especificações de API das seguintes descrições:

{json.dumps(descriptions, indent=2)}

Para cada descrição, extraia:

- Host (obrigatório)

- Endpoint (obrigatório)

- Params (opcional)

- Port (se disponível)

- modelo JSON (para POST/PUT/PATCH/DELETE)

- Autenticação (se aplicável)

Marque quaisquer campos obrigatórios ausentes como 'missing'.

Retorne os resultados em formato JSON como um array de especificações.

"""),

expected_output="""Um array JSON contendo as especificações de API extraídas com todos os campos obrigatórios e opcionais""",

agent=self.extraction_agent

)

```

### O Agente de Validação

Próximo na fila, o Agente de Validação! Sua missão é garantir que as especificações de API coletadas pelo Agente de Extração estejam corretas e consistentes. Ele verifica:

1. Formato de host válido

2. Endpoint começando com '/'

3. Métodos HTTP válidos (GET, POST, PUT, DELETE, PATCH)

4. Número de porta válido (se fornecido)

5. Presença de modelo JSON para métodos aplicáveis.

```python

def create_validation_agent(self) -> Agent:

return Agent(

role='API Validator',

goal='Validar especificações de API quanto à correção e consistência.',

backstory=dedent("""

Você é um especialista em validação de API, garantindo que todas as especificações

atendam aos padrões e formatos necessários.

"""),

allow_delegation=False,

llm=self.llm

)

def validate_api_spec(self, extracted_data: Dict) -> Task:

return Task(

description=dedent(f"""

Valide a seguinte especificação de API:

{json.dumps(extracted_data, indent=2)}

Verifique:

1. Formato de host válido

2. Endpoint começando com '/'

3. Métodos HTTP válidos (GET, POST, PUT, DELETE, PATCH)

4. Número de porta válido (se fornecido)

5. Presença de modelo JSON para métodos aplicáveis.

Retorne os resultados da validação em formato JSON.

"""),

expected_output="""Um objeto JSON contendo os resultados da validação com quaisquer erros ou confirmação de validade""",

agent=self.validation_agent

)

```

### O Agente de Interação

Avançando, conhecemos o Agente de Interação, nosso Especialista em Interação com o Usuário. Seu papel é obter quaisquer campos de especificação de API ausentes que foram marcados pelo Agente de Extração e validá-los com base nas descobertas do Agente de Validação. Eles interagem diretamente com os usuários para preencher quaisquer lacunas.

### O Agente de Produção

Precisamos de duas informações cruciais para criar a interoperabilidade necessária: namespace e nome da produção. O Agente de Produção interage com os usuários para coletar essas informações, de forma muito semelhante ao Agente de Interação.

### O Agente de Transformação de Documentação

Assim que as especificações estiverem prontas, é hora de convertê-las em documentação OpenAPI. O Agente de Transformação de Documentação, um especialista em OpenAPI, cuida disso.

```python

def create_transformation_agent(self) -> Agent:

return Agent(

role='Especialista em Transformação OpenAPI',

goal='Converter especificações de API em documentação OpenAPI',

backstory=dedent("""

Você é um especialista em especificações e documentação OpenAPI.

Seu papel é transformar detalhes de API validados em documentação

OpenAPI 3.0 precisa e abrangente.

"""),

allow_delegation=False,

llm=self.llm

)

def transform_to_openapi(self, validated_endpoints: List[Dict], production_info: Dict) -> Task:

return Task(

description=dedent(f"""

Transforme as seguintes especificações de API validadas em documentação OpenAPI 3.0:

Informações de Produção:

{json.dumps(production_info, indent=2)}

Endpoints Validados:

{json.dumps(validated_endpoints, indent=2)}

Requisitos:

1. Gerar especificação OpenAPI 3.0 completa

2. Incluir schemas de requisição/resposta apropriados

3. Documentar todos os parâmetros e corpos de requisição

4. Incluir autenticação se especificado

5. Garantir formatação de caminho apropriada

Retorne a especificação OpenAPI nos formatos JSON e YAML.

"""),

expected_output="""Um objeto JSON contendo a especificação OpenAPI 3.0 completa com todos os endpoints e schemas.""",

agent=self.transformation_agent

)

```

### The Review Agent

Após a transformação, a documentação OpenAPI passa por uma revisão meticulosa para garantir conformidade e qualidade. O Agente de Revisão segue esta lista de verificação:

1.Conformidade OpenAPI 3.0

- Especificação de versão correta

- Elementos raiz obrigatórios

- Validação da estrutura do schema

2. Completude

- Todos os endpoints documentados

- Parâmetros totalmente especificados

- Schemas de requisição/resposta definidos

- Esquemas de segurança configurados corretamente

3. Verificações de Qualidade

- Convenções de nomenclatura consistentes

- Descrições claras

- Uso adequado de tipos de dados

- Códigos de resposta significativos

4. Melhores Práticas

- Uso adequado de tags

- Nomenclatura de parâmetros consistente

- Definições de segurança apropriadas

Finalmente, se tudo parecer bom, o Agente de Revisão reporta um objeto JSON saudável com a seguinte estrutura:

```json

{

"is_valid": boolean,

"approved_spec": object (a especificação OpenAPI revisada e possivelmente corrigida),

"issues": [array de strings descrevendo quaisquer problemas encontrados],

"recommendations": [array de sugestões de melhoria]

}

```

```python

def create_reviewer_agent(self) -> Agent:

return Agent(

role='Revisor de Documentação OpenAPI',

goal='Garantir a conformidade e qualidade da documentação OpenAPI',

backstory=dedent("""

Você é a autoridade final em qualidade e conformidade de documentação OpenAPI.

Com vasta experiência em especificações OpenAPI 3.0, você revisa meticulosamente

a documentação para precisão, completude e adesão aos padrões.

"""),

allow_delegation=True,

llm=self.llm

)

def review_openapi_spec(self, openapi_spec: Dict) -> Task:

return Task(

description=dedent(f"""

Revise a seguinte especificação OpenAPI para conformidade e qualidade:

{json.dumps(openapi_spec, indent=2)}

Lista de Verificação da Revisão::

1. Conformidade OpenAPI 3.0

- Verificar a especificação de versão correta

- Verificar os elementos raiz obrigatórios

- Validar a estrutura do schema

2. Completude

- Todos os endpoints devidamente documentados

- Parâmetros totalmente especificados

- Schemas de requisição/resposta definidos

- Esquemas de segurança configurados corretamente

3. Quality Checks

- Consistent naming conventions

- Clear descriptions

- Proper use of data types

- Meaningful response codes

4. Best Practices

- Proper tag usage

- Consistent parameter naming

- Appropriate security definitions

Você deve retornar um objeto JSON com a seguinte estrutura:

{{

"is_valid": boolean,

"approved_spec": object (a especificação OpenAPI revisada e possivelmente corrigida),

"issues": [array de strings descrevendo quaisquer problemas encontrados],

"recommendations": [array de sugestões de melhoria]

}}

"""),

expected_output=""" Um objeto JSON contendo: is_valid (boolean), approved_spec (object), issues (array), e recommendations (array)""",

agent=self.reviewer_agent

)

```

### O Agente Iris

O último agente no grupo do planejador é o Agente Iris, que envia a documentação OpenAPI finalizada para o Iris.

```python

def create_iris_i14y_agent(self) -> Agent:

return Agent(

role='Especialista em Integração Iris I14y',

goal='Integrar especificações de API com o serviço Iris I14y',

backstory=dedent("""

Você é responsável por garantir uma integração suave entre o sistema de

documentação da API e o serviço Iris I14y. Você lida com a

comunicação com o Iris, valida as respostas e garante a integração

bem-sucedida das especificações da API.

"""),

allow_delegation=False,

llm=self.llm

)

def send_to_iris(self, openapi_spec: Dict, production_info: Dict, review_result: Dict) -> Task:

return Task(

description=dedent(f"""

Enviar a especificação OpenAPI aprovada para o serviço Iris I14y:

Informações de Produção:

- Nome: {production_info['production_name']}

- Namespace: {production_info['namespace']}

- É Novo: {production_info.get('create_new', False)}

Status da Revisão:

- Aprovado: {review_result['is_valid']}

Retornar o resultado da integração em formato JSON.

"""),

expected_output="""Um objeto JSON contendo o resultado da integração com o serviço Iris I14y, incluindo o status de sucesso e os detalhes da resposta.""",

agent=self.iris_i14y_agent

)

class IrisI14yService:

def __init__(self):

self.logger = logging.getLogger('facilis.IrisI14yService')

self.base_url = os.getenv("FACILIS_URL", "http://dc-facilis-iris-1:52773")

self.headers = {

"Content-Type": "application/json"

}

self.timeout = int(os.getenv("IRIS_TIMEOUT", "504")) # in milliseconds

self.max_retries = int(os.getenv("IRIS_MAX_RETRIES", "3"))

self.logger.info("IrisI14yService initialized")

async def send_to_iris_async(self, payload: Dict) -> Dict:

"""

Enviar carga útil para o endpoint de geração do Iris de forma assíncrona.

"""

self.logger.info("Enviando carga útil para o endpoint de geração do Iris.")

if isinstance(payload, str):

try:

json.loads(payload)

except json.JSONDecodeError:

raise ValueError("Invalid JSON string provided")

retry_count = 0

last_error = None

# Cria timeout para o aiohttp

timeout = aiohttp.ClientTimeout(total=self.timeout / 1000) # Converte ms para seconds

while retry_count < self.max_retries:

try:

self.logger.info(f"Attempt {retry_count + 1}/{self.max_retries}: Enviando requisição para {self.base_url}/facilis/api/generate")

async with aiohttp.ClientSession(timeout=timeout) as session:

async with session.post(

f"{self.base_url}/facilis/api/generate",

json=payload,

headers=self.headers

) as response:

if response.status == 200:

return await response.json()

response.raise_for_status()

except asyncio.TimeoutError as e:

retry_count += 1

last_error = e

error_msg = f"Timeout occurred (attempt {retry_count}/{self.max_retries})"

self.logger.warning(error_msg)

if retry_count < self.max_retries:

wait_time = 2 ** (retry_count - 1)

self.logger.info(f"Waiting {wait_time} seconds before retry...")

await asyncio.sleep(wait_time)

continue

except aiohttp.ClientError as e:

error_msg = f"Failed to send to Iris: {str(e)}"

self.logger.error(error_msg)

raise IrisIntegrationError(error_msg)

error_msg = f"Failed to send to Iris after {self.max_retries} attempts due to timeout"

self.logger.error(error_msg)

raise IrisIntegrationError(error_msg, last_error)

```

## Conheça os Geradores

Nosso segundo conjunto de agentes são os Geradores. Eles estão aqui para transformar as especificações OpenAPI em interoperabilidade InterSystems IRIS.

Há oito deles neste grupo.

O primeiro deles é o Agente Analisador. Ele é como o planejador, traçando a rota.

Seu trabalho é mergulhar nas especificações OpenAPI e descobrir quais componentes de Interoperabilidade IRIS são necessários.

```python

def create_analyzer_agent():

return Agent(

role="Analisador de Especificações OpenAPI",

goal="Analisar minuciosamente as especificações OpenAPI e planejar os componentes de Interoperabilidade IRIS",

backstory="""Você é um especialista em especificações OpenAPI e em Interoperabilidade InterSystems IRIS.

Seu trabalho é analisar documentos OpenAPI e criar um plano detalhado de como eles devem ser implementados como componentes de Interoperabilidade IRIS.""",

verbose=False,

allow_delegation=False,

tools=[analyze_openapi_tool],

llm=get_facilis_llm()

)

analysis_task = Task(

description="""Analisar a especificação OpenAPI e planejar os componentes de Interoperabilidade IRIS necessários.

Incluir uma lista de todos os componentes que devem estar na classe de Produção."",

agent=analyzer,

expected_output="Uma análise detalhada da especificação OpenAPI e um plano para os componentes IRIS, incluindo a lista de componentes de Produção",

input={

"openapi_spec": openApiSpec,

"production_name": "${production_name}"

}

)

```

Em seguida, os **Agentes de Business Services (BS) e Business Operations (BO)** assumem o controle.

Eles geram os Business Services e as Business Operations com base nos endpoints OpenAPI.

Eles usam uma ferramenta útil chamada MessageClassTool para gerar as classes de mensagens perfeitas, garantindo a comunicação.

```python

def create_bs_generator_agent():

return Agent(

role="Gerador de Produção e Business Service IRIS",

goal="Gerar classes de Produção e Business Service IRIS formatadas corretamente a partir de especificações OpenAPI",

backstory="""Você é um desenvolvedor InterSystems IRIS experiente, especializado em Produções de Interoperabilidade.

Sua expertise reside na criação de Business Services e Produções capazes de receber e processar requisições de entrada com base emespecificações de API."",

verbose=False,

allow_delegation=True,

tools=[generate_production_class_tool, generate_business_service_tool],

llm=get_facilis_llm()

)

def create_bo_generator_agent():

return Agent(

role="Gerador de Business Operation IRIS",

goal="Gerar classes de Business Operation IRIS formatadas corretamente a partir de especificações OpenAPI",

backstory="""Você é um desenvolvedor InterSystems IRIS experiente, especializado em Produções de Interoperabilidade.

Sua expertise reside na criação de Business Operations capazes de enviar requisições para sistemas externos com base em especificações de API.""",

verbose=False,

allow_delegation=True,

tools=[generate_business_operation_tool, generate_message_class_tool],

llm=get_facilis_llm()

)

bs_generation_task = Task(

description="Gerar classes de Business Service com base nos endpoints OpenAPI",

agent=bs_generator,

expected_output="Definições de classes de Business Service do IRIS",

context=[analysis_task]

)

bo_generation_task = Task(

description="Gerar classes de Business Operation com base nos endpoints OpenAPI",

agent=bo_generator,

expected_output="Definições de classes de Business Operation do IRIS",

context=[analysis_task]

)

class GenerateMessageClassTool(BaseTool):

name: str = "generate_message_class"

description: str = "Gerar uma classe de Mensagem IRIS"

input_schema: Type[BaseModel] = GenerateMessageClassToolInput

def _run(self, message_name: str, schema_info: Union[str, Dict[str, Any]]) -> str:

writer = IRISClassWriter()

try:

if isinstance(schema_info, str):

try:

schema_dict = json.loads(schema_info)

except json.JSONDecodeError:

return "Error: Invalid JSON format for schema info"

else:

schema_dict = schema_info

class_content = writer.write_message_class(message_name, schema_dict)

# Armazenar a classe gerada.

writer.generated_classes[f"MSG.{message_name}"] = class_content

return class_content

except Exception as e:

return f"Error generating message class: {str(e)}"

```

Depois que BS e BO fazem o que têm que fazer, é a hora do Agente de Produção brilhar!

Este agente junta tudo para criar um ambiente de produção coeso.

Depois que tudo estiver configurado, o próximo na linha é o Agente de Validação.

Este entra em cena para uma verificação final, garantindo que cada classe Iris esteja ok.

Em seguida, temos o Agente de Exportação e o Agente de Coleção. O Agente de Exportação gera os arquivos .cls, enquanto o Agente de Coleção reúne todos os nomes de arquivos.

Tudo é passado para o importador, que compila tudo no InterSystems Iris.

```python

def create_exporter_agent():

return Agent(

role="Exportador de Classes IRIS",

goal="Exportar e validar definições de classes IRIS para arquivos .cls adequados",

backstory="""Você é um especialista em implantação InterSystems IRIS. Seu trabalho é garantir que as definições de classes IRIS geradas sejam devidamente exportadas como arquivos .cls válidos que

possam ser importados diretamente para um ambiente IRIS.""",

verbose=False,

allow_delegation=False,

tools=[export_iris_classes_tool, validate_iris_classes_tool],

llm=get_facilis_llm()

)

def create_collector_agent():

return Agent(

role="Coletor de Classes IRIS",

goal="Coletar todos os arquivos de classes IRIS gerados em uma coleção JSON",

backstory="""Você é um especialista em sistema de arquivos responsável por reunir e

organizar os arquivos de classes IRIS gerados em uma coleção estruturada.""",

verbose=False,

allow_delegation=False,

tools=[CollectGeneratedFilesTool()],

llm=get_facilis_llm()

)

export_task = Task(

description="Exportar todas as classes IRIS geradas como arquivos .cls válidos",

agent=exporter,

expected_output="Arquivos .cls IRIS válidos salvos no diretório de saída",

context=[bs_generation_task, bo_generation_task],

input={

"output_dir": "/home/irisowner/dev/output/iris_classes" # Optional

}

)

collection_task = Task(

description="Coletar todos os arquivos de classes IRIS gerados em uma coleção JSON",

agent=collector,

expected_output="Coleção JSON de todos os arquivos .cls gerados",

context=[export_task, validate_task],

input={

"directory": "./output/iris_classes"

}

)

```

## Limitações e Desafios

Nosso projeto começou como um experimento empolgante, onde meus colegas mosqueteiros e eu almejávamos criar uma ferramenta totalmente automatizada usando agentes.

Foi uma jornada selvagem!

Nosso foco principal estava em integrações de API REST. É sempre uma alegria receber uma tarefa com uma especificação OpenAPI para integrar; no entanto, sistemas legados podem ser uma história completamente diferente.

Pensamos que automatizar essas tarefas poderia ser incrivelmente útil.

Mas toda aventura tem suas reviravoltas:

Um dos maiores desafios foi instruir a IA a converter OpenAPI para Interoperabilidade Iris.

Começamos com o modelo openAI GPT3.5-turbo, que em testes iniciais se mostrou difícil com depuração e prevenção de interrupções.

A mudança para o Anthropic Claude 3.7 Sonnet mostrou melhores resultados para o grupo Gerador, mas não tanto para os Planejadores...

Isso nos levou a dividir nossas configurações de ambiente, usando diferentes provedores de LLM para flexibilidade.

Usamos GPT3.5-turbo para planejamento e Claude sonnet para geração, uma ótima combinação!

Essa combinação funcionou bem, mas encontramos problemas com alucinações.

A mudança para o GT4o melhorou os resultados, mas ainda enfrentamos alucinações na criação de classes Iris e, às vezes, especificações OpenAPI desnecessárias, como o renomado exemplo Pet Store OpenAPI.

Nos divertimos muito aprendendo ao longo do caminho, e estou super animado com o futuro incrível nesta área, com inúmeras possibilidades!

Artigo

Bob Kuszewski · Maio 20, 2021

# Migrando do Java Business Host para o PEX

Com o lançamento do [PEX](https://docs.intersystems.com/irislatest/csp/docbook/DocBook.UI.Page.cls?KEY=EPEX) a partir do InterSystems IRIS 2020.1 e InterSystems IRIS for Health 2020.1, nossos clientes tem agora uma melhor forma de utilizar Java nas Produções de interoperabilidade que através da utilização do Java Business Host. O PEX (Production EXtension) disponibiliza um conjunto completo de APIs para criar componentes de interoperabilidade e está disponível tanto em Java quanto em .NET. O Java Business Host foi descontinuado e será aposentado em versões futuras.

Vantagens do PEX

* Permite que desenvolvedores criem qualquer componente da Produção de interoperabilidade em Java ou em .NET

* Estruturas de mensagens mais complexas podem ser enviadas através dos componentes

* Configurações simplificadas

* Fluxo de trabalho simplificado , sem utilização de ObjectScript.

O resto deste artigo está focado em como realizar a migração de código existente do Java Business Host para o PEX.

## Visão Geral

As classes e interfaces utilizadas pelo PEX são diferentes das do Java Business Host (JBH). Nós iremos disponibilizar uma visão geral das diferenças neste artigo mas a [documentação completa](https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=EPEX_apiref) te dará maior profundidade sobre o assunto.

* [Convertendo um Business Service](#Converting-a-Business-Service-from-Java-Business-Host-to-PEX)

* [Convertendo um Business Operation](#Converting-a-Business-Operation-from-Java-Business-Host-to-PEX)

* [Configurações](#Settings)

* [Mensagens](#Messages)

* [Registrando](#Logging)

## Convertendo um Business Service do Java Business Host para o PEX

Para criar um Business Service PEX você precisará implementar a `com.intersystems.enslib.pex.BusinessService` ao invés da `com.intersystems.gateway.bh.BusinessService`.

O padrão de design utilizado pelo PEX para Business Service mudou de um onde era esperado que o serviço iniciasse o processo de produção de mensagens para o padrão onde o serviço implementa uma função que é invocada periodicamente para produzir mensagens.

No JBH, seu código seria algo como isso

```java

@Override

public boolean OnInit(Production p) throws Exception {

production = p;

if (messageThread == null) {

Messager messager = new Messager();

messageThread = new Thread(messager);

messageThread.start();

}

return true;

}

```

No PEX, você precisa apenas implementas três funções

```java

public void OnInit() throws Exception {

// Inicialização

return;

}

public Object OnProcessInput(Object messageInput) throws Exception {

// Aqui é onde você invoca a SendMessage() ou SendMessageAsync()

return null;

}

public void OnTearDown() throws Exception {

// Desligar

return;

}

```

Você também precisará alterar como as configurações são utilizadas, mensagens são entregues e onde o registro de log é feito. Falaremos mais sobre estas alterações abaixo.

## Convertendo um Business Operation do Java Business Host para PEX

Para criar um Business Operation PEX você precisará implementar a `com.intersystems.enslib.pex.BusinessOperation` ao invés da `com.intersystems.gateway.bh.BusinessOperation`.

O padrão de design para os Business Operations é estruturalmente o mesmo entre o JBH e o PEX entretanto os parâmetros para os dois principais pontos de entrada forma alterados.

### Mudanças no OnInit()

No PEX o `OnInit()` não recebe parâmetros.

### Mudanças no OnMessage()

No PEX o `OnMessage()` recebe um `Object` genérico no lugar da `String` utilizada no JBH. Isto permite que o criador da produção de interoperabilidade envie qualquer tipo de mensagem desejada.

No JBH sua aplicação ficaria mais ou menos algo assim:

```java

public boolean OnMessage(String message) throws Exception {

// Lógica de negócio aqui

return true;

}

```

No PEX o parâmetro é um Objeto Java genérico, que você deve instanciar apropriadamente, que permite que você transmita mensagens mais complexas que apenas strings. Aqui está um exemplo de como extrair uma requisição que é do tipo file stream.

```java

public Object OnMessage(Object request) throws Exception {

com.intersystems.jdbc.IRISObject streamContainer = (com.intersystems.jdbc.IRISObject)request;

com.intersystems.jdbc.IRISObject str = (com.intersystems.jdbc.IRISObject)streamContainer.get("Stream");

String originalFilename = (String)streamContainer.get("OriginalFilename");

Long contentSize = (Long)str.get("Size");

String content = (String)str.invoke("Read", contentSize);

// Lógica de negócio aqui

return null;

}

```

Você também precisará alterar como as configurações são utilizadas, mensagens são entregues e onde o registro de log é feito. Falaremos mais sobre estas alterações abaixo.

## Settings

A declaração das configurações também foi simplificada.

No JBH as configurações era declaradas através da string `SETTINGS` e recuperada através de código, algo como isso:

```java

String setting = production.GetSetting("Min");

if (!setting.isEmpty()) {

min = Integer.parseInt(setting);

}

```

No PEX as configurações são apenas campos de membros públicos, desta forma elas são automaticamente carregadas quando a classe é instanciada.

```java

public int Min = 0;

```

Qualquer campo de membro público está disponível para ser atribuído em sua produção de interoperabilidade desde que o campo do membro seja um tipo base Java (String, int, etc.).

## Mensagens

O envio de Mensagens no PEX é mais poderoso. No JBH mensagens são enviadas como strings. No PEX as mensagens são enviadas como objetos - tanto IRISObject, para objetos definidos em ObjectScript, ou uma subclasse subclass of `com.intersystems.enslib.pex.Message`, para classes definidas em Java.

No JBH seu código seria algo assim

```java

production.SendRequest(value.toString());

```

No PEX seria algo como isso

```java

MyExampleMessageClass req = new MyExampleMessageClass("mensagem a ser enviada");

SendRequestAsync(Target, req);

```

## Logging

As funções para registro de Logs são todas similares, apenas nomeadas de forma diferente.

No PEX você registraria uma mensagem informativa através da `LOGINFO()`

```java

LOGINFO("mensagem recebida");

```

## Gateway de Objetos

O Java Business Host precisava de seu próprio gateway. Com o PEX você pode utilizar um Java gateway apenas para toda sua necessiade de Java. Ou então usar vários, você escolhe. Aqui você encontra uma boa [introdução ao gateway](https://docs.intersystems.com/irislatest/csp/docbook/Doc.View.cls?KEY=EJVG_intro).

## Conclusão e Feedback

Se você ainda não experimentou utilizar o PEX, o que falta ? O PEX disponibiliza a habilidade de resolver uma quantidade muito mais ampla de problemas de negócio com menos codificação, além de permitir que agora tudo também seja feito em .NET.

Se você tiver dúvidas ou problemas migrando suas aplicações de JBH para PEX, entre em contato conosco pelo WRC.

Artigo

Luana Machado · Jun. 12, 2023

Exemplo de uso do banco de dados FHIR InterSystems IRIS for Health para efetuar modelagem ML através do InterSystems IRIS IntegratedML

Descrição

IntegratedML é uma ótima funcionalidade para treino/teste e implantação de modelos ML. FHIR é um padrão poderoso para a interoperabilidade de informações da saúde. Esse projeto visa mostrar como utilizar as ferramentas IRIS/IRIS for Health. Por exemplo, as transformações DTL para preparar dados do FHIR para aplicação de modelos ML dentro do IntegratedML. Aqui estão algumas potenciais aplicações das ideias apresentadas nesse projeto:

Reutilização e extensão de transformações DTL dentro de outras bases de dados FHIR para modelos ML personalizados

Utilização das transformações DTL para normalizar mensagens FHIR e publicar modelos ML como serviços

Criação de um referencial de modelos e regras de transformação para usar em qualquer conjunto de dados FHIR

Instalação

Clone o repositório em um diretório local:

$ git clone https://github.com/jrpereirajr/fhir-integratedml-example.git

Abra o terminal nesse repositório e execute:

$ cd fhir-integratedml-example

$ docker-compose up -d

Se quiser obter um log do que aconteceu durante a instalação, utilize o seguinte comando :

$ docker-compose up -d > build-log.txt 2>&1

Inicialização de um terminal IRIS

Para inicializar um terminal IRIS, siga esses passos:

Em um terminal powershell/cmd, execute:

docker exec -it fhir-integratedml-example_iris_1 bash

Dentro do shell do linux , crie uma sessão IRIS:

irissession iris

Demonstração

Para demonstrar o conceito do projeto, foram configurados dois modelos:

Um modelo de predição de não-comparecimento à uma consulta;

Um modelo de predição de insuficiência cardíaca.

Primeiro, conjuntos de dados de treinamento foram usados para gerar recursos FHIR sintéticos. Esses conjuntos de dados continham informações sobre pacientes, patologias, observações, consultas e visitas enviadas aos pacientes, representadas por diversos recursos FHIR. Essa etapa emula um banco de dados FHIR real, no qual as previsões de não-comparecimento e insuficiência cardíaca podem ser aplicadas.

Quando o banco de dados FHIR estiver pronto para uso, os dados devem ser transformados, combinando recursos FHIR que são pertinentes ao problema, em tabelas únicas. Essa combinação de FHIR é obtida por transformações DTL, como NoShowDTL e HeartFailureDTL :

Como as transformações DTL podem ser exportadas/importadas, é possível compartilhar os modelos ML aplicados aos dados FHIR. Essas transformações podem igualmente ser entendidas por outras equipes, se necessário.

Depois de aplicar as transformações DTL, os recursos FHIR são mapeados em linhas simples, criando também tabelas que podem ser utilizadas para formar modelos ML para as previsões de não-comparecimento e insuficiência cardíaca.

Para treinar e testar os modelos usando o IntegratedML, utilize as seguintes instruções SQL. Eles são executadas durante a instalação, mas você pode executá-los novamente e experimentar o IntegratedML por conta própria.

Modelo de não-comparecimento

-- criar um conjunto de dados de treinamento

CREATE OR REPLACE VIEW PackageSample.NoShowMLRowTraining AS SELECT * FROM PackageSample.NoShowMLRow WHERE ID < 1800

-- criar um conjunto de dados de teste

CREATE OR REPLACE VIEW PackageSample.NoShowMLRowTest AS SELECT * FROM PackageSample.NoShowMLRow WHERE ID >= 1800

-- evitar os erros no comando CREATE MODEL; ignore qualquer erro aqui

DROP MODEL NoShowModel

-- um modelo IntegratedML para a coluna de previsão noShow (não-apresentação) é criada a partir de outros modelos, utilizando o conjunto de dados PackageSample.NoShowMLRowTraining para a etapa de treinamento; o parâmetro "Semente" (seed) aqui destina-se à assegurar a reprodutibilidade dos resultados.

CREATE MODEL NoShowModel PREDICTING (Noshow) FROM PackageSample.NoShowMLRowTraining USING {"seed": 6}

-- o modelo é treinado, conforme definido no comando de criação de um modelo "CRIAR UM MODELO"

TRAIN MODEL NoShowModel

-- as informações sobre o modelo treinado são exibidas, como por exemplo o modelo ML selecionado pelo IntegratedML

SELECT * FROM INFORMATION_SCHEMA.ML_TRAINED_MODELS

-- a função de previsão (PREDICT) é utilizada para ver como usar o modelo nas intruções SQL

SELECT top 10 PREDICT(NoShowModel) AS PredictedNoshow, Noshow AS ActualNoshow FROM PackageSample.NoShowMLRowTest

-- uma validação em um conjunto de dados de teste é efetuado e as métricas de performance do modelo são calculadas

VALIDATE MODEL NoShowModel FROM PackageSample.NoShowMLRowTest

-- as métricas de performance são exibidas

SELECT * FROM INFORMATION_SCHEMA.ML_VALIDATION_METRICS

Modelo de insuficiência cardíaca

-- criar um conjunto de dados de treinamento

CREATE OR REPLACE VIEW PackageSample.HeartFailureMLRowTraining AS SELECT DEATHEVENT,age,anaemia,creatininephosphokinase,diabetes,ejectionfraction,highbloodpressure,platelets,serumcreatinine,serumsodium,sex,smoking,followuptime FROM PackageSample.HeartFailureMLRow WHERE ID < 200

-- criar um conjunto de dados de teste

CREATE OR REPLACE VIEW PackageSample.HeartFailureMLRowTest AS SELECT DEATHEVENT,age,anaemia,creatininephosphokinase,diabetes,ejectionfraction,highbloodpressure,platelets,serumcreatinine,serumsodium,sex,smoking,followuptime FROM PackageSample.HeartFailureMLRow WHERE ID >= 200

-- evitar os erros no comando CREATE MODEL; ignorar todo erro aqui

DROP MODEL HeartFailureModel

-- as informações sobre o modelo formado são exibidas, como por exemplo o modelo ML selecionado pelo IntegratedML

CREATE MODEL HeartFailureModel PREDICTING (DEATHEVENT) FROM PackageSample.HeartFailureMLRowTraining USING {"seed": 6}

-- o modelo é treinado, conforme definido no comando de criação de um modelo "CRIAR UM MODELO"

TRAIN MODEL HeartFailureModel

-- as informações sobre o modelo treinado são exibidas, como por exemplo o modelo ML selecionado pelo IntegratedML

SELECT * FROM INFORMATION_SCHEMA.ML_TRAINED_MODELS

-- a função de previsão (PREDICT) é utilizada para ver como usar o modelo nas intruções SQL

SELECT top 10 PREDICT(HeartFailureModel) AS PredictedHeartFailure, DEATHEVENT AS ActualHeartFailure FROM PackageSample.HeartFailureMLRowTest

-- uma validação em um conjunto de dados de teste é efetuado e as métricas de performance do modelo são calculadas

VALIDATE MODEL HeartFailureModel FROM PackageSample.HeartFailureMLRowTest

-- as métricas de performance são exibidas

SELECT * FROM INFORMATION_SCHEMA.ML_VALIDATION_METRICS

A última instrução SQL pode indicar os parâmetros de performance da classificação:

A mesma transformação pode ser aplicada para transformar os recursos FHIR provenientes dos sistemas externos através de uma API REST, por exemplo (veja o código):

Solução de problemas

Se você tiver erros durante as requisições API, indicando que o modelo não existe, é provável que alguma coisa anormal se produziu durante a criação do contêiner para os modelos de treinamento. Tente executar o método de treinamento novamente. Abra o terminal IRIS e execute:

ZN "FHIRSERVER"

Do ##class(PackageSample.Utils).TrainNoShowModel()

Do ##class(PackageSample.Utils).TrainHeartFailureModel()

Referências

Recursos FHIR utilizados como modelos: ttp://hl7.org/fhir/

Conjunto de dados para a formação de modelo de não-comparecimento: IntegratedML templat

Conjunto de dados para a formação de modelo de insuficiência cardíaca: kaggle

Artigo

Claudio Devecchi · Fev. 8, 2021

### HealthShare Patient Index

Enterprise Master Patient Index - Este é o nome dado ao processo que faz com que os inúmeros cadastros e registros coletados dos vários sistemas das instituições e redes de saúde sejam identificados univocamente e interligados através de um identificador único por indivíduo.

Isto viabiliza uma infinidade de benefícios para as instituições ou redes de saúde, pois permite, além da gestão das duplicidades em um mesmo sistema de prontuário eletrônico, que todos os dados segregados por número de cadastro sejam visualizados de forma consolidada por indivíduo. Cada vez mais, as instituições estão buscando uma abordagem holística do cuidado contínuo, da prevenção e da experiência centrada no paciente.

Falando sobre o produto [Healthshare Patient Index](https://learning.intersystems.com/course/view.php?id=632) da InterSystems, podemos dividi-lo em 6 grandes grupos de funcionalidades.

### 1 - Integração das informações cadastrais dos pacientes

Esta etapa engloba todos os mecanismos de coleta das informações nos sistemas de origem, seja através de API’s com protocolos específicos de saúde como o HL7, seja através de processos específicos ou customizados.

Neste ponto, é importante que a plataforma de integração ofereça uma série de requisitos de interoperabilidade que assegure flexibilidade, governança e segurança.

É muito comum sistemas de prontuário eletrônico internacionais fornecerem nativamente exportações de dados usando o protocolo HL7, que neste caso também é nativo nos produtos da Intersystems. Os sistemas nacionais geralmente demandam processos menos padronizados, e é por isso que é necessário que a plataforma seja de fácil e rápida implementação.

Geralmente as informações são enviadas ou disponibilizadas no momento em que o paciente é admitido nos estabelecimentos de saúde.

A arquitetura deste processo é definida conforme as necessidades de cada organização e disponibilidade dos recursos computacionais.

### 2 - Análise Qualitativa e Normalização

Normalizar significa trazer para um mesmo plano de comparação informações demográficas que foram cadastradas de formas completamente diferentes. É também nesta etapa que todo o “lixo” é removido. Isto não quer dizer que a informação seja ruim, mas que não serve para o processo do MPI.

Se os dados fossem comparados sem esta etapa, provavelmente cadastros de um mesmo indivíduo nunca seriam comparados, dada à discrepância de sistema para sistema.

Se observarmos o processo de cadastro de cada estabelecimento e sistema de origem, veremos uma infinidade de formas de entrada dos dados e diversas maneiras de armazenamento das informações. Isso depende de como cada sistema foi concebido e como cada processo foi implementado em cada setor da organização.

Um exemplo típico é o processo de admissão em alas emergenciais. Muitas vezes o paciente precisa ser atendido antes mesmo de ser identificado. Isso gera uma série de especificidades que precisam ser tratadas em uma análise qualitativa antes mesmo da implementação do processo de captura dos dados.

O outro exemplo muito comum é o cadastramento de recém nascidos. Cada caso é um caso. Em alguns sistemas os nomes são cadastrados com um prefixo “RN DE” seguido pelo nome da mãe. Isso porque os pais não sabem o nome dos bebês antes do parto e eles já precisam constar nos sistemas de prontuário eletrônico. Como todos os sistemas geralmente exigem o CPF, eles podem ser cadastrados com o mesmo CPF da mãe. É claro que este é só um exemplo de uma situação pontual, mas cada caso deve ser estudado e endereçado da forma mais adequada possível.

Além das especificidades de processo, há as que são de armazenamento dos dados. Documentos como CPF, RG e carteirinhas de seguro são armazenados com pontos e traços em alguns sistemas. Em outros são armazenados sem. O mesmo ocorre com datas. Nomes geralmente são armazenados em um único campo, uns com caixa baixa, outros com alta. Alguns são abreviados pela limitação de caracteres.

Endereços são os vilões na normalização. Os sistemas mais modernos são baseados no CEP, outros não. Os que não são sofrem muitas abreviações devidos aos sufixos, títulos ou até mesmo pela limitação dos caracteres.

Enfim, mesmo que em instituições mais modernas tecnologicamente, há sempre os sistemas legados. Estes também são incorporados ao processo de MPI porque trazem informações históricas valiosas para todo o processo assistencial.

Culturalmente e diferentemente dos sistemas norte americanos, os sistemas brasileiros possuem um único campo para capturar os nomes. Para melhorar a eficácia do processo de vinculação é importante que os sistemas tenham a capacidade de separar os nomes, considerando também os primeiros nomes compostos.

Outra capacidade não menos importante é a capacidade de trabalhar com as abreviações nos endereços. Isto requer um dicionário específico de abreviações para o nosso país.

### 3 - Indexação ou formação dos pares de comparação

Nesta etapa é que se decide quais serão os cadastros que serão comparados entre si, formando assim os chamados pares de comparação.

A decisão de se comparar registros não se baseia apenas nos documentos do paciente, assim como o CPF. Isso acontece porque há casos que não se tem o CPF do paciente ou casos que os filhos recebem o CPF dos pais. Para isto é necessário que o processo utilize os dados probabilísticos, assim como o nome, a data de nascimento, o sexo, os dados de contato e o endereço.

É preciso que este processo tenha algoritmos sofisticados para que os sistemas não gerem um número excessivo de comparações indevidas, assim como não deixem de fora comparações necessárias.

Por exemplo: A comparação de todos os “Josés” com todos os outros “Josés” não seria tão eficaz, pois poderia acarretar numa sobrecarga de processamento.

Outro ponto não menos importante nesta fase é a capacidade de se trabalhar com algoritmos fonéticos para o mercado brasileiro, que são completamente diferentes dos algoritmos americanos.

Isso significa que nomes escritos de maneiras diferentes ou equivocadas também serão considerados no processo. Exemplo: Dois cadastros de um determinado paciente com os nomes Walter Xavier e Valter Chavier podem se referir ao mesmo indivíduo.

O Healthshare MPI utiliza um processo extremamente eficiente de análise combinatória que evita este tipo de problema, utilizando tanto informações demográficas determinísticas quanto probabilísticas.

### 4 - Pontuação dos pares

Para cada par de comparação gerado, todas as variáveis demográficas são pontuadas separadamente: Primeiros nomes, nomes do meio, sobrenomes, documentos, sexo, cep, telefones, e-mails e endereços.

Antes de iniciar a comparação, é determinado um peso com uma pontuação máxima e mínima para cada variável, considerando a singularidade de cada uma. Por exemplo, o sexo possui um peso menor que a data de nascimento, que possui peso menor que o nome, que possui um peso menor que o CPF. E assim por diante.

Cada variável possui um algoritmo específico não binário de comparação que vai atribuir uma pontuação entre a mínima e a máxima para cada variável demográfica.

Exemplo: Se o sexo for o mesmo, serão atribuídos 2 pontos. Se não for o mesmo será atribuída a pontuação mínima, -4 pontos. Se o CPF for o mesmo, serão atribuídos 14 pontos,

Primeiros nomes e sobrenomes comuns também recebem pontuações menores que nomes mais comuns, assim como Silva e Souza.

Nomes de casada e solteira também devem ser considerados aqui no Brasil.

### 5 - Avaliação e determinação do identificador unívoco dos pares

Antes desta etapa, é necessário configurar as faixas de pontuação ou limiares que serão utilizados para vincular (mesmo indivíduo) ou não vincular (indivíduos diferentes) os pares de cadastro.

Neste ponto, pode-se definir também a faixa de pontuação dos pares que irão para uma lista de trabalho, passíveis de uma avaliação ou revisão humana.

Limiares a serem configurados:

**Vínculo Automático** – Acima de quantos pontos os pares serão automaticamente vinculados. Exemplo: Se o total de pontos dos pares estiver acima de 35 os mesmos serão automaticamente vinculados e não necessitarão de revisão humana.

**Vínculo com posterior avaliação na Lista de Trabalho** – Entre quantos pontos os pares irão para a lista de trabalho como vinculados (mesmos indivíduos) para avaliação humana. Exemplo: Os pares entre 30 e 35 pontos serão vinculados, mas poderão sofrer revisão de um profissional ou equipe designados para esta tarefa.

**Não vínculo** – Abaixo de quantos pontos os pares não serão vinculados. Exemplo: Se o total de pontos dos pares for abaixo de 30 eles não serão vinculados (indivíduos diferentes).

**Não vínculo com revisão posterior na Lista de Trabalho** – Entre quantos pontos os pares irão para a lista de trabalho como não vinculado (indivíduos diferentes) para uma revisão humana. Exemplo: Os pares entre 25 e 30 pontos não serão vinculados, mas poderão sofrer revisão de um profissional ou equipe designados para esta tarefa.

Há várias situações de exceções, onde mesmo pares com pontuação elevada podem não se referir ao mesmo indivíduo. Um exemplo típico são os gêmeos, que moram na mesma residência. Para isso é necessário que o produto disponibilize de artifícios para identificar estes casos.

Há outras situações que pares com baixa pontuação podem sofrer revisões se determinadas situações ocorrerem. Exemplo: pares com o mesmo CPF e data de nascimento e baixa pontuação. Este caso é no mínimo curioso, pois pode apontar um problema na baixa qualidade dos dados.

No HealthShare Patient Index, estes dispositivos são chamados de regras de vinculação (rules), que prevalecem sobre a regra de pontuação.

O produto já possui nativamente uma série de regras de exceção e elas são fundamentais para a segurança e confiabilidade de todo o processo.

Após esta etapa, todos os cadastros recebem um identificador universal denominado MPIID - Master Patient Index Identification. Os cadastros que possuírem o mesmo MPIID são referentes ao mesmo indivíduo.

### 6 – Serviços e API’s ###

Concluindo todo o processo de vinculação (Matching), é essencial que a plataforma ofereça maneiras passivas ou ativas de se comunicarem ou interoperarem com os sistemas de origem ou outros sistemas. Neste momento entram novamente todos os requisitos de interoperabilidade do produto, que já estão presentes na plataforma HealthShare da Intersystems.

As API’s de consumo do MPI são disponibilizadas neste momento através de protocolos conhecidos (HTTP Soap ou Rest) para que sistemas consigam obter as informações desejadas para diversos casos de uso.

Estes são alguns exemplos comuns de consumo de API’s do HealthShare MPI:

• Obter identificadores de outros sistemas partindo do identificador do sistema consumidor. Este tipo de consulta é denominada pelo IHE como PIX. Exemplo: Antes de enviar a prescrição para o laboratório o sistema de origem envia o seu identificador do cadastro e recebe uma resposta da API com o número do identificador do mesmo paciente no laboratório.

• Realizar pesquisas probabilísticas por dados demográficos. Exemplo: Consultar se existem cadastros demográficos para o paciente de nome Claudio Devecchi Junior. Este tipo de consulta é denominada pelo IHE como PDQ).

• Obter o melhor dado demográfico (Golden Record ou Composite Record) de um determinado paciente para enriquecer os cadastros demográficos ou para aproveitar os seus dados no momento de um determinado cadastro.

Existem também mecanismos ativos, onde o MPI se comunica com os sistemas para enviar informações úteis. Estes mecanismos também podem ser acionados de forma passiva através da chamada das Api’s.

Alguns exemplos são:

• No momento que um cadastro está sendo incluído ou atualizado o MPI pode fazer uma chamada retornando o identificador universal - MPIID. Desta forma o sistema de origem sempre ficará atualizado com este identificador. Quaisquer mudanças nas Listas de Trabalho são gatilhos para este tipo de chamada (callback)

• Quando algum cadastro for incluído e o MPI identificar que já existe esta mesma pessoa no mesmo sistema de origem, já é possível enviar uma notificação de duplicidade. Para os casos de resolução das duplicidades, é importante que exista um serviço específico para receber as mensagens de fusão de pacientes (PIX merge).

### Conclusão

Todo o processo descrito anteriormente demonstra um pouco de como o produto HealthShare Patient Index trata dos desafios na área com relação aos cadastros e identificação dos pacientes e como é importante tratar das especificidades não somente do país, mas de organização para organização.

No próximo artigo, falaremos um pouco de como funciona o Healthshare Unified Care Record (UCR) e de como ele é fundamental para ajudar as instituições na abordagem holística do cuidado contínuo, da prevenção e da experiência centrada no paciente.

Artigo

Heloisa Paiva · Abr. 28

Tenho um novo projeto para armazenar informações de respostas REST em um banco de dados IRIS. Precisarei sincronizar informações de pelo menos duas dúzias de endpoints REST separados, o que significa criar quase essa quantidade de classes ObjectScript para armazenar os resultados desses endpoints.

Poderia usar o ChatGPT para ter uma vantagem inicial na criação dessas classes? A resposta é "Sim", o que é ótimo, já que esta é minha primeira tentativa de usar IA generativa para algo útil. Gerar fotos de girafas tomando sopa estava ficando meio batido...

Aqui está o que eu fiz:

Obter alguma saída de chamada REST JSON de amostra usando "curl" para consultar o endpoint.

Visitar o ChatGPT (a InterSystems fornece uma licença para toda a empresa para os funcionários)

Tenha o seguinte diálogo com o ChatGPT.

Coloquei o seguinte pedido no prompt "Message ChatGPT":

Eu: Gere uma classe ObjectScript que armazenará dados do seguinte JSON:

Apertei "Enter" antes de inserir o JSON, então o ChatGPT me direcionou da seguinte forma:

ChatGPT: Por favor, forneça a estrutura JSON para a qual você gostaria que eu gerasse a classe ObjectScript. Se você tiver um objeto JSON de exemplo, cole-o aqui e eu criarei a classe InterSystems ObjectScript correspondente para você.

Eu inseri o seguinte no prompt:

{

"id": 335818632,

"appId": 113,

"appName": "Batch",

"contentId": 182455380233,

"subject": "Test Subject",

"name": "Test email campaign name",

"counters": {

"processed": 3910,

"deferred": 86,

"unsubscribed": 17,

"statuschange": 17,

"bounce": 153,

"mta_dropped": 8,

"dropped": 299,

"delivered": 3749,

"sent": 3903,

"click": 16,

"open": 323

},

"lastProcessingFinishedAt": 1733232499000,

"lastProcessingStartedAt": 1733232303000,

"lastProcessingStateChangeAt": 1733232499000,

"numIncluded": 4201,

"processingState": "DONE",

"scheduledAt": 1733232300000,

"type": "BATCH_EMAIL"

}

Resposta do ChatGPT:

Aqui está a classe InterSystems ObjectScript que mapeia a estrutura JSON fornecida:

Class MyNamespace.MyJSONData Extends (%Persistent, %JSON.Adaptor)

{

Property id As %Integer;

Property appId As %Integer;

Property appName As %String;

Property contentId As %Integer;

Property subject As %String;

Property name As %String;

Property counters As MyNamespace.Counters;

Property lastProcessingFinishedAt As %BigInt;

Property lastProcessingStartedAt As %BigInt;

Property lastProcessingStateChangeAt As %BigInt;

Property numIncluded As %Integer;

Property processingState As %String;

Property scheduledAt As %BigInt;

Property type As %String;

ClassMethod %OnJSONImport(jsonObject As %Object, instance As MyNamespace.MyJSONData) As %Status

{

Quit ..%JSONImport(jsonObject, .instance)

}

}

Class MyNamespace.Counters Extends (%SerialObject, %JSON.Adaptor)

{

Property processed As %Integer;

Property deferred As %Integer;

Property unsubscribed As %Integer;

Property statuschange As %Integer;

Property bounce As %Integer;

Property mta_dropped As %Integer;

Property dropped As %Integer;

Property delivered As %Integer;

Property sent As %Integer;

Property click As %Integer;

Property open As %Integer;

}

Junto com uma explicação:

Explicação:

Mynamespace.MyJSONData: A principal classe representando o objeto JSON.

As propriedades mapeiam diretamente para os campos no JSON.

Ela estende tanto %Persistent quanto %JSON.Adaptor para persistência e compatibilidade com JSON.

Mynamespace.Counters: Uma classe aninhada para representar o objeto counters no JSON.

Esta classe é definida como um %SerialObject, pois faz parte do objeto principal e não precisa de persistência independente.

Manipulação de JSON:

O %JSON.Adaptor lida automaticamente com a serialização e desserialização de/para o formato JSON.

O método %OnJSONImport permite a personalização da importação JSON, embora o método padrão %JSONImport seja suficiente para esse mapeamento direto.

Você pode salvar esse código em um arquivo de classe e usá-lo para analisar ou armazenar dados JSON. Avise se quiser recursos adicionais ou mais personalizações!

Este código é um ótimo começo, mas eu gostaria que ele se encaixasse no meu pacote chamado“MyPkg”e desse o nome "EmailCampaign" para a classe. Além disso, usando um pouco de NI (Network Intelligence), sei que os valores que geraram as propriedades "%BigInt" são, na verdade, tempos Linux e as propriedades deveriam ser "%Library.PosixTime".

Faço o seguinte pedido (não tenho certeza por que estou dizendo "por favor" para uma máquina; acho que meus pais fizeram um bom trabalho):

Eu: Podemos recriar a classe novamente, renomeando o pacote para "MyPkg" e a Classe como "EmailCampaign"? Além disso, por favor, altere os tipos das propriedades de %BigInt para %Library.PosixTime.

Resposta do ChatGPT:

Aqui está a classe ObjectScript atualizada com o nome do pacote e o nome da classe especificados, e as propriedades de timestamp atualizadas para usar %Library.PosixTime:

Class MyPkg.EmailCampaign Extends (%Persistent, %JSON.Adaptor)

{

Property id As %Integer;

Property appId As %Integer;

Property appName As %String;

Property contentId As %Integer;

Property subject As %String;

Property name As %String;

Property counters As MyPkg.Counters;

Property lastProcessingFinishedAt As %Library.PosixTime;

Property lastProcessingStartedAt As %Library.PosixTime;

Property lastProcessingStateChangeAt As %Library.PosixTime;

Property numIncluded As %Integer;

Property processingState As %String;

Property scheduledAt As %Library.PosixTime;

Property type As %String;

ClassMethod %OnJSONImport(jsonObject As %Object, instance As MyPkg.EmailCampaign) As %Status

{

Quit ..%JSONImport(jsonObject, .instance)

}

}

Class MyPkg.Counters Extends (%SerialObject, %JSON.Adaptor)

{

Property processed As %Integer;

Property deferred As %Integer;

Property unsubscribed As %Integer;

Property statuschange As %Integer;

Property bounce As %Integer;

Property mta_dropped As %Integer;

Property dropped As %Integer;

Property delivered As %Integer;

Property sent As %Integer;

Property click As %Integer;

Property open As %Integer;

}

Junto com esta explicação:

Alterações Feitas:

Nome do Pacote e da Classe:

O pacote agora é CRMBI.

A classe principal foi renomeada para EmailCampaign.

Propriedades de Timestamp:

lastProcessingFinishedAt, lastProcessingStartedAt, lastProcessingStateChangeAt e scheduledAt agora utilizam %Library.PosixTime.

%Library.PosixTime é apropriado para propriedades que armazenam timestamps no formato UNIX.

Outras Propriedades:

Todos os outros campos permanecem inalterados e seguem a estrutura original do JSON.

Esta classe está pronta para lidar com a serialização/desserialização JSON e fornece o mapeamento correto para o objeto aninhado counters. Me avise se precisar de mais ajustes ou tiver novos requisitos!

Depois de copiar o código "como está" para o VSCode, problemas de sintaxe com as chaves foram destacados. Classes ObjectScript não habilitam definições de classe internas.

Pedir ao ChatGPT para corrigir o problema das "chaves" movendo a classe interna MyPkg.Counters para uma classe separada é uma "não-operação"; um humano precisará mover essa classe para outro arquivo. O ChatGPT renomeou essa classe após o seguinte pedido:

Eu: A classe como está escrita não compila. Podemos mover a classe interna chamada MyPkg.Counters para fora da classe principal para sua própria classe e renomeá-la para MyPkg.CampaignCounters?

Resposta do ChatGPT:

Aqui está o código ObjectScript atualizado com a classe MyPkg.CampaignCounters movida para fora como sua própria classe:

Class MyPkg.EmailCampaign Extends (%Persistent, %JSON.Adaptor)

{

Property id As %Integer;

Property appId As %Integer;

Property appName As %String;

Property contentId As %Integer;

Property subject As %String;

Property name As %String;

Property counters As MyPkg.CampaignCounters;

Property lastProcessingFinishedAt As %Library.PosixTime;

Property lastProcessingStartedAt As %Library.PosixTime;

Property lastProcessingStateChangeAt As %Library.PosixTime;

Property numIncluded As %Integer;

Property processingState As %String;

Property scheduledAt As %Library.PosixTime;

Property type As %String;

ClassMethod %OnJSONImport(jsonObject As %Object, instance As MyPkg.EmailCampaign) As %Status

{

Quit ..%JSONImport(jsonObject, .instance)

}

}

Class MyPkg.CampaignCounters Extends (%SerialObject, %JSON.Adaptor)

{

Property processed As %Integer;

Property deferred As %Integer;

Property unsubscribed As %Integer;

Property statuschange As %Integer;

Property bounce As %Integer;

Property mta_dropped As %Integer;

Property dropped As %Integer;

Property delivered As %Integer;

Property sent As %Integer;

Property click As %Integer;

Property open As %Integer;

}

Depois de colar o código acima no VSCode e compilá-lo, o compilador relatou que o tipo chamado "%Object" não existe em ObjectScript. De acordo com a documentação do IRIS, a propriedade para o primeiro parâmetro do método %JSONImport() de %JSON.Adaptor é flexível:

“O argumento de entrada é JSON como uma string ou stream, ou uma subclasse de %DynamicAbstractObject.”

Depois de remover a propriedade "As %Object" para o primeiro parâmetro de %OnJSONImport() na primeira classe e separar as duas classes em arquivos separados, a classe MyPkg.EmailCampaign compilou com sucesso. No entanto, a MyPkg.CampaignCounters não compilou; o ChatGPT não sabe (ainda?) que o sublinhado é um caractere especial em ObjectScript (o operador de concatenação de strings)

Vamos tentar ensiná-lo.

Eu: O caractere sublinhado "_" é um caractere especial em ObjectScript. Por favor, altere as propriedades com um sublinhado em seus nomes para nomes em camel case e remova o sublinhado.

Resposta do ChatGPT:

Aqui está o código atualizado com as propriedades que tinham sublinhados em seus nomes convertidas para camel case:

Class MyPkg.EmailCampaign Extends (%Persistent, %JSON.Adaptor)

{

Property id As %Integer;

Property appId As %Integer;

Property appName As %String;

Property contentId As %Integer;

Property subject As %String;

Property name As %String;

Property counters As MyPkg.CampaignCounters;

Property lastProcessingFinishedAt As %Library.PosixTime;

Property lastProcessingStartedAt As %Library.PosixTime;

Property lastProcessingStateChangeAt As %Library.PosixTime;

Property numIncluded As %Integer;

Property processingState As %String;

Property scheduledAt As %Library.PosixTime;

Property type As %String;

ClassMethod %OnJSONImport(jsonObject As %Object, instance As MyPkg.EmailCampaign) As %Status

{

Quit ..%JSONImport(jsonObject, .instance)

}

}

Class MyPkg.CampaignCounters Extends (%SerialObject, %JSON.Adaptor)

{

Property processed As %Integer;

Property deferred As %Integer;

Property unsubscribed As %Integer;

Property statusChange As %Integer;

Property bounce As %Integer;

Property mtaDropped As %Integer;

Property dropped As %Integer;

Property delivered As %Integer;

Property sent As %Integer;

Property click As %Integer;

Property open As %Integer;

}

Junto com esta explicação:

Mudanças Realizadas:

1. Conversão para Camel Case:

Propriedades em CampaignCounters com underscores agora são escritas em camel case:

statuschange → statusChange

mta_dropped → mtaDropped

2. Nomes de Propriedades em JSON:

ObjectScript irá mapear automaticamente nomes de propriedades em camel case para seus correspondentes com underscore no JSON usando o %JSON.Adaptor.

Este código atualizado compila corretamente e preserva a funcionalidade para serialização/desserialização JSON! Avise-me se precisar de mais ajustes!

O ChatGPT foi além e alterou outra propriedade, uma nomeada com duas palavras separadas, para camel case também (statuschange); estou mantendo essa alteração, já que outras propriedades com nomes semelhantes na classe principal estão todas em camel case.

Com o código gerado mais recente em dois arquivos separados (e removendo a definição "As %Object" na definição do método %OnJSONImport()), todo o código compila com sucesso.

Essas classes geradas são um excelente ponto de partida para o que preciso e repetirei o processo para as outras fontes de dados REST para este projeto, me poupando muita digitação desnecessária.

Artigo

Danusa Calixto · Jul. 27, 2022

**Histórico**

| Versão| Data | Atualizações|

| :----- | :-- | :----- |

| V1 | 2022-02-08 | Início |

| V1.1 | 2022-04-06 | Geração de certificados com arquivo sh em vez de pki-scriptUsando variáveis de ambiente em arquivos de configuração|

Olá Comunidade,

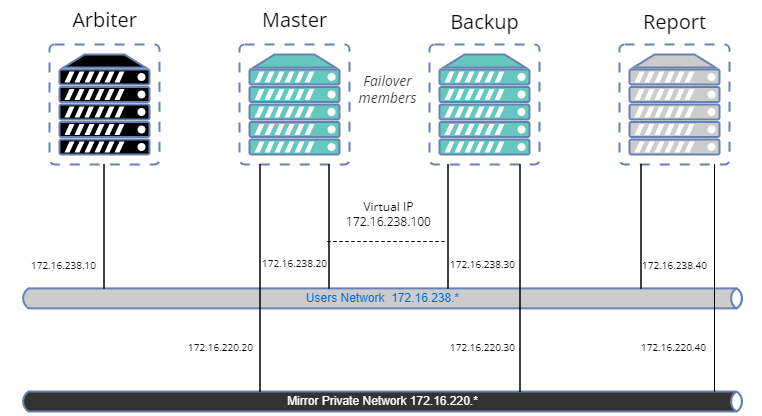

Vocês já configuraram um ambiente espelhado? Tem rede privada, IP virtual, e configuração SSL?

Após fazer isso algumas vezes, eu me dei conta que isso é longo, e há várias ações manuais obrigatórias para gerar os certificados e configurar cada instancia IRIS.

É uma dor no pescoço para quem tem que fazer isso muitas vezes.